芯片战场丨瞄准大模型摩尔线程首个千卡智算中心落地

为满足大模型的“暴力”计算需求,国内GPU企业正加码算力基础设施建设。

12月19日,摩尔线程首个全国产千卡千亿模型训练平台——摩尔线程KUAE智算中心落地。据其介绍,这是国内首个以国产全功能GPU为底座的大规模算力集群。

同时,摩尔线程CEO张建中在当天发布了大模型智算加速卡MTT S4000,以及专为千亿参数大模型训练和推理提供支持的摩尔线程KUAE平台。

近年在AI热潮之下,国内的智算中心不断兴建。根据此前国家信息中心联合浪潮信息发布的《智能计算中心创新发展指南》统计,目前全国超过30个城市在建或筹建智算中心,预计“十四五”期间,在智算中心实现80%应用水平的情况下,城市对智算中心的投资可带动人工智能核心产业增长2.9至3.4倍,带动相关产业增长36至42倍。

而智算中心底座离不开GPU、CPU等芯片,大模型时代,以GPU为代表的智能算力更是基石。此次摩尔线程KUAE智算中心正是基于其GPU产品来构建算力集群,其中就包括了最新发布的MTT S4000。

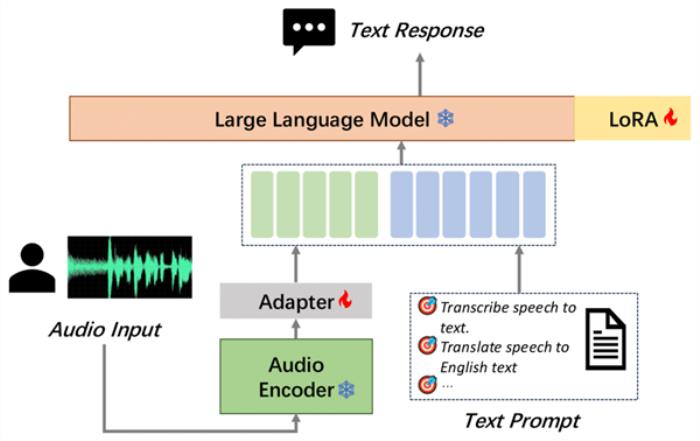

据摩尔线程介绍,MTT S4000采用第三代MUSA内核,单卡支持48GB显存和768GB/s的显存带宽。基于摩尔线程自研MTLink1.0技术,MTT S4000可以支持多卡互联,加速分布式计算。同时,通过摩尔线程自研MUSIFY开发工具,MTT S4000计算卡可以利用现有CUDA软件生态,实现CUDA代码零成本迁移到MUSA平台。

CUDA为英伟达的计算平台,也是生态壁垒。可以说,CUDA是英伟达建立的并行运算的一整套软硬件生态标准,几乎所有GPU、AI芯片都兼容CUDA平台。多年来,国内的GPU企业也在建设自己的运算平台和生态。

再看基于GPU的智算中心,此次摩尔线程KUAE智算中心解决方案是专为大模型而造,包括以KUAE计算集群为核心的基础设施、KUAE Platform集群管理平台以及KUAE ModelStudio模型服务。

目前,摩尔线程支持包括LLaMA、GLM、Aquila、Baichuan、GPT、Bloom、玉言等各类主流大模型的训练和微调。摩尔线程表示,基于摩尔线程KUAE千卡集群,70B到130B参数的大模型训练,线性加速比均可达到91%,算力利用率基本保持不变。以2000亿训练数据量为例,智源研究院700亿参数Aquila2可在33天完成训练;1300亿参数规模的模型可在56天完成训练。此外,摩尔线程KUAE千卡集群支持长时间连续稳定运行,支持断点续训,异步Checkpoint少于2分钟。

在业内人士看来,智算中心不断建成后,更重要的是要让算力有效地流动到应用中、更好地支持大模型服务千行百业。而生态是关键一环,为此,摩尔线程联合国内产业链成立了摩尔线程PES -KUAE智算联盟和摩尔线程PES-大模型生态联盟,加速国内大模型产业发展。

业内的共识是,智算中心不应只是硬件的堆积,更是对软硬一体化的GPU智算系统整合能力的考验,GPU分布式计算系统的适配、算力集群的管理和高效推理引擎的应用等,都是提高算力中心可用性的重要因素。而国产智算中心的发展,更是依托于将各方需求和优势充分融合,产业聚力才能实现整个生态的协同。

(文章来源:21世纪经济报道)

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

21世纪经济报道

2023-12-20

21世纪经济报道

2023-12-20