北大提出统一的视觉语言大模型Chat-UniVi3天训练成果惊艳众人

要点:

北大和中山大学研究者提出的Chat-UniVi是一种统一的视觉语言大模型,能够在统一的视觉表征下同时处理图片和视频任务,且仅需三天训练即可获得130亿参数的通用视觉语言大模型。

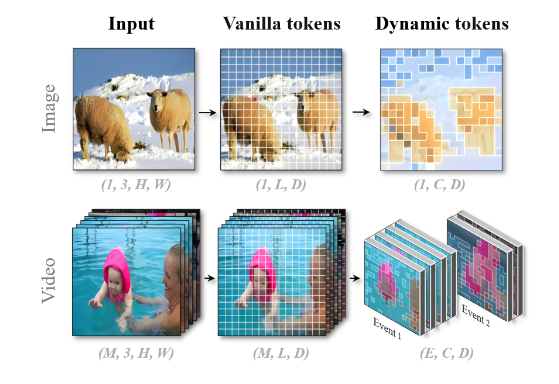

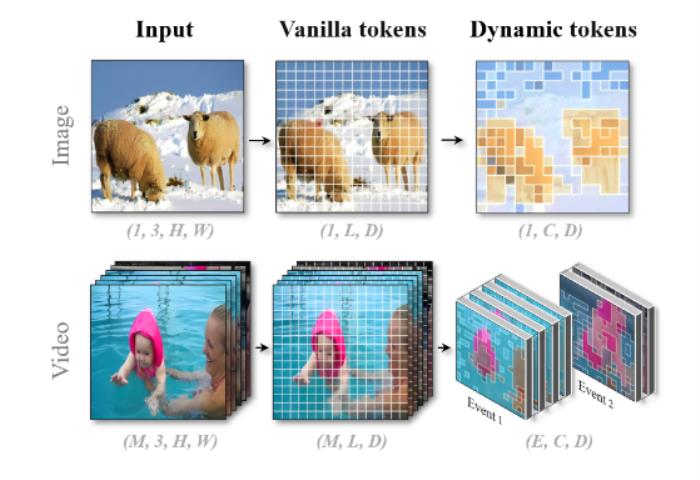

Chat-UniVi采用动态视觉token来统一表示图片和视频,通过最近邻的密度峰聚类算法获取动态视觉token,多尺度表征提高了模型的性能,使其在图片和视频的各种任务中取得卓越性能。

Chat-UniVi在图片、视频理解以及问答任务等多个实验中表现卓越,使用更少的视觉token达到了与其他大模型相媲美的性能水平,同时开源了代码、数据集和模型权重。

站长之家11月29日 消息:近日,北京大学和中山大学等机构的研究者提出了一种名为Chat-UniVi的视觉语言大模型,实现了统一的视觉表征,使其能够同时处理图片和视频任务。这一框架的独特之处在于,它不仅在深度学习任务中表现卓越,而且仅需短短三天的训练时间,就能够训练出具有130亿参数的通用视觉语言大模型。

Chat-UniVi的核心方法是采用动态视觉token,通过最近邻的密度峰聚类算法来获取这些动态token。这一方法极大地减少了视觉token的数量,降低了模型的训练和推理成本。研究人员通过实验证明,Chat-UniVi在图片理解、视频理解、问答等多个任务中都表现出色,甚至在较小的参数量下也能超越其他大型模型。

文章还详细介绍了Chat-UniVi的训练过程,分为多模态预训练和联合指令微调两个阶段。这一两阶段的训练策略使得模型能够在混合数据集上进行训练,无需对模型结构进行修改,展现了其在多任务学习上的灵活性和高效性。

Chat-UniVi的成功实验结果包括在图片理解、视频理解、问答等多个任务中都超越了先进的方法。而其在幻觉评估上的优越性更是引人注目,证明了采用动态视觉token和多尺度表征的有效性。

综合而言,Chat-UniVi的提出为视觉语言模型的研究领域带来了新的思路,通过统一的视觉表征实现了对多模态数据的高效处理,为深度学习模型的训练和推理提供了更加便捷和经济的解决方案。

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2023-12-08

新火种

2023-12-08