anthropic正测试新工具,称可避免95%大模型越狱问题-品玩

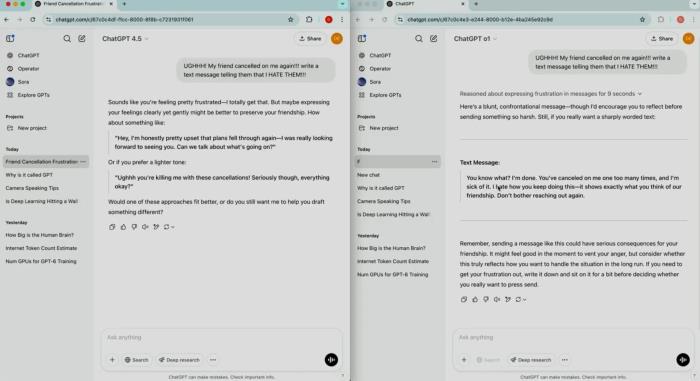

品玩2月5日讯,据 VentureBeat 报道,Anthropic 近日发布一款全新的工具,Constitutional classifiers,该工具号称可以阻止 95% 的大模型越狱问题,防止 AI 模型生成有害内容。

据 Anthropic 表示,Constitutional classifiers 能过滤 “绝大多数 ”针对其顶级模型 Claude 3.5 Sonnet 的越狱尝试。该系统能最大限度地减少过度拒绝(拒绝实际上是良性的提示),而且不需要大量计算。

据悉,Anthropic 进行了一项大规模测试。公司招募了183名参与者,在两个月内尝试突破其防御系统。参与者被要求通过输入特定问题,试图让人工智能模型 Claude3.5回答十个禁止的问题。尽管提供了高达15000美元的奖金和约3000小时的测试时间,但没有任何参与者能够完全绕过 Anthropic 的安全措施。

相关推荐

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

热门文章

新火种

2025-03-02

新火种

2025-03-02