生成式AI服务安全标准公开征求意见提出语料黑名单、关切个人信息保护

生成式人工智能商业化落地探索走深,保障安全也成为其进程中的一个重要议题。

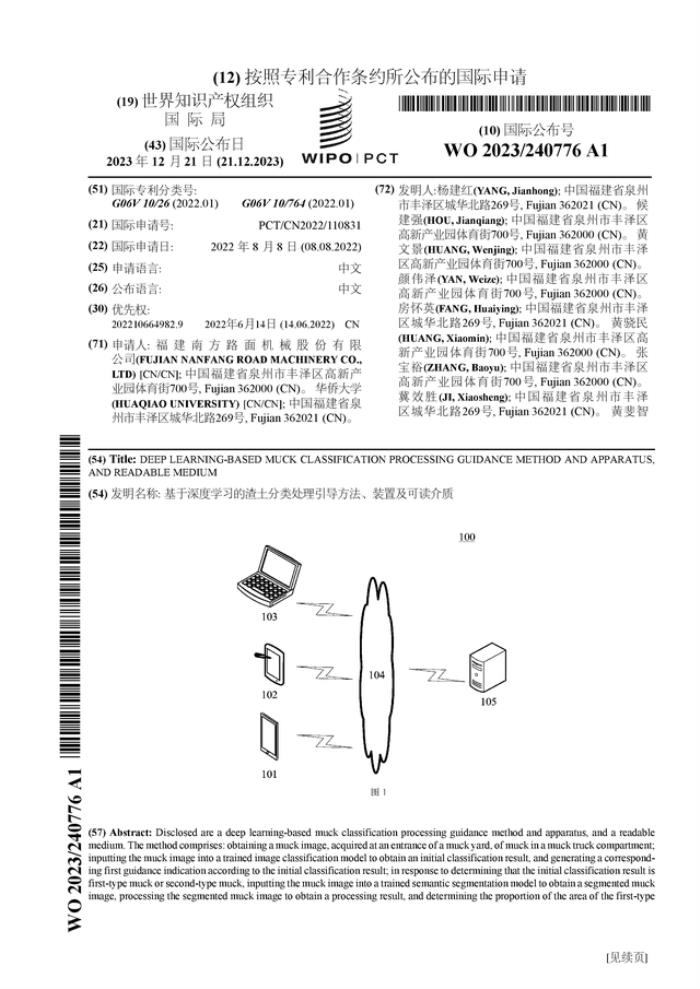

近日,全国信息安全标准化技术委员会组织(以下简称信安标委)组织制定的《生成式人工智能服务安全基本要求》(征求意见稿)(以下简称“征求意见稿”)公开征求意见,从语料安全、模型安全、 安全措施、安全评估等多方面对生成式人工智能服务在安全方面的基本要求。

建立语料来源黑名单,明确语料可溯源

数据是生成式人工智能发展的燃料,此次征求意见稿亦对输入数据做了相关要求。征求意见稿对于训练语料(Training Data)进行明确,即所有直接作为模型训练输入的数据,包括预训练、优化训练过程中的输入数据。

值得关注的是,欧盟的《人工智能法》也明确了Training Data的范围。北京航空航天大学法学院副教授赵精武在接受21世纪经济报道记者采访时表示,相较于欧盟模式而言,征求意见稿侧重于对人工智能系统背后算法模型的影响,将预训练、优化训练等环节的输入端数据均纳入“训练语料”的范畴。

训练数据良莠不齐一直是大模型成长难以忽视的重难点。征求意见稿对语料来源安全进行了规制,要对各来源语料进行安全评估,单一来源语料内容中含违法不良信息超过5%的,应将该来源加入黑名单,而进入黑名单的语料将不会用以训练。

中国政法大学数据法治研究院教授张凌寒指出,目前国家对人工智能生成内容的治理高度重视,对投放市场的AI产品推行黑名单机制是必然的。“尤其针对境外语料源,意见稿已经给出了相对细化的评判标准,黑名单机制具有较高可操作性。”

不过,北京师范大学法学院博士生导师、中国互联网协会研究中心副主任吴沈括指出,实践中建立语料来源黑名单,还需关注如何建立具有广泛覆盖性的语料参照标准,对语料做出准确的识别和认定。

环球律师事务所合伙人孟洁介绍道,目前语料内容筛选的方式主要包括:关键词过滤、分类模型、人工筛选等。关键词筛选需要企业提前预置词库,成本较高,无法做到穷尽列举;人工筛选则存在人力成本高、效率低等问题;分类模型是机器学习任务中的常见手段,但处理复杂数据有限或需要大量训练数据等问题还需要解决。

征求意见稿还对语料来源的可追溯进行明确,指出开源语料应具有该语料来源的开源授权协议或相关授权文件。自采语料,包括自行生产的语料以及从互联网采集的语料,应具有采集记录,不应采集他人已明确声明不可采集的语料。

“对语料可追溯性提出要求的主要目的是增强可解释性,是作为暂行办法中对模型透明度要求的补充和细化,也是避免、解决权益争议和实现产业监督的重要支持。”张凌寒在接受21世纪经济报道记者采访时表示。

赵精武提示,自采语料、商业语料均能够对语料采集行为进行记录和存档较好地进行约束,而开源语料则需要规范化开源方式,尤其是开源授权协议等文件应当载明数据来源,由于开源自身的开放性,这可能对现有的开源方式产生一定影响,相较于前者,难度略高。

保护知识产权、个人信息

书籍、音乐、影像等版权内容有时也会被用于大模型训练,相关知识产权风险令人担忧。

征求意见稿中提出应设置语料以及生成内容的知识产权负责人。在训练前,相关负责人需要对预料中的知识产权侵权情况进行识别,不应使用有侵权问题的语料进行训练。

“征求意见稿在现有知识产权法体系下重申和细化了相关知识产权合规要求。”赵精武说道。保护知识产权并不必然阻碍技术创新,细化训练语料阶段的知识产权保护要求,是为了避免人工智能系统生成具有著作权侵权问题的图像、文字等。

对于提供者而言,语料的内容安全还需尤其关注个人信息。今年6月,Open AI被匿名人士发起集体诉讼,诉讼的焦点在于OpenAI是否按照其隐私政策合法合理地收集并利用用户个人信息,以及是否有效识别并剔除其训练数据来源中“偶然”包含的个人信息。

征求意见稿指出,应使用包含个人信息的语料时,获得对应个人信息主体的授权同意,或满足其他合法使用该个人信息的条件;应使用包含敏感个人信息的语料时,获得对应个人信息主体的单独授权同意,或满足其他合法使用该敏感个人信息的条件;应使用包含人脸等生物特征信息的语料时,获得对应个人信息主体的书面授权同意,或满足其他合法使用该生物特征信息的条件。

赵精武指出,征求意见稿对个人信息保护所提出的相关要求实质上还是在《个人信息保护法》等法律法规的要求范围内,并没有发生实质意义上的义务增加。“对AI研发企业最直接影响是,既有的个人信息业务合规范围既包括了算法模型研发、设计阶段,也包括人工智能系统应用阶段,实现全业务流程的个人信息安全保护。”

“征求意见稿重申个人信息保护的内容,并且针对生成式人工智能工作原理和产业现状适当扩展。这些可操作的规则能够帮助企业在不侵害个人信息权益的前提下开展业务,降低合规成本,有利于个人信息保护制度在生成式人工智能领域的落地。”张凌寒进一步说道。

延续立法逻辑,企业实践可参考注意

“《征求意见稿》继承了《互联网信息服务算法推荐管理规定》《生成式人工智能服务管理暂行办法》等规定中的立法逻辑,进一步明晰了AI大模型开发企业提供了内部合规的具体落地建议,具有很强的实操性。”孟洁在接受21世纪经济报道记者采访时指出。

征求意见稿中还针对模型安全提出了诸多要求,涵盖生成内容、服务透明度等多方面。以交互界面提供大模型服务的,应在显著或便于查看的位置公开用户、服务局限性、机制机理等信息、第三方基础模型使用情况。生成内容则需要保证安全、准确和可靠,包括内容积极正向、有效内容含量高以及所包含的数据及表述应符合科学常识或主流认知、不含错误内容等。

在孟洁看来,实践中的模型安全应包括技术安全、内容安全、使用安全。大模型提供者应该依照此次征求意见稿以及此前多部规章制度的要求,从这三方面做好保障。

值得注意的是,征求意见稿总则部分明确,本文件支撑《生成式人工智能服务管理暂行办法》,提出了提供者需遵循的安全基本要求。提供者在向相关主管部门提出生成式人工智能服务上线的备案申请前,应按照本文件中各项要求逐条进行安全性评估,并将评估结果以及证明材料在备案时提交。

她提醒道,此处的“上线备案”,不同于既有的“算法备案”“舆论属性安全评估”,也与以往“双新评估”在名称上存在差异,需要相关企业特别注意并积极与监管部门进行确认和跟进,确保在产品上线前完成相关备案手续,履行自身的合规义务。

吴沈括指出,目前,征求意见稿还并未成为强制性国家标准。“不过如果未来监管机关在监管活动中将其选定为执法标准,它将产生相应的约束力。”他表示。

(文章来源:21世纪经济报道)

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2023-10-20

新火种

2023-10-20