国产大模型DeepSeek-V3一夜火爆全球,671B的MoE,训练成本仅558万美元

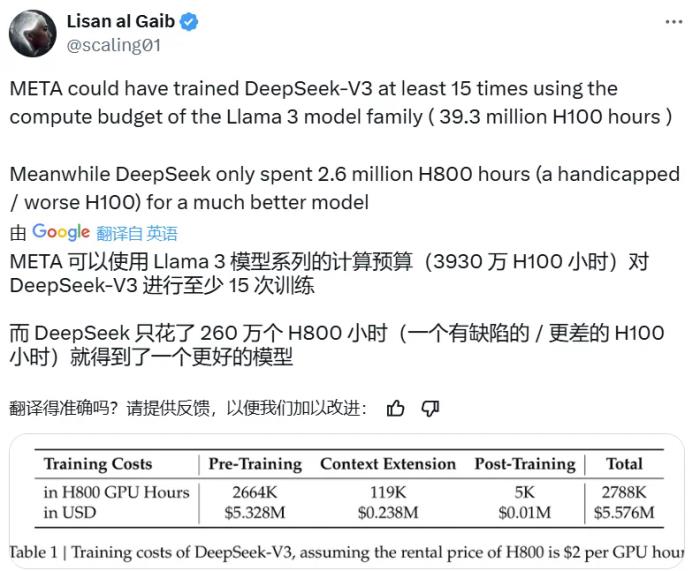

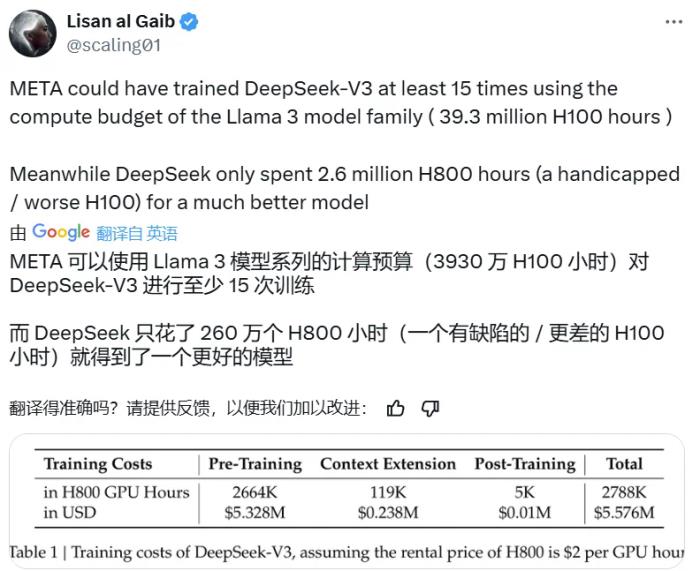

今天,一个国产大模型火遍了世界。打开 X,满眼都是讨论 DeepSeek-V3 的推文,而其中最热门的话题之一是这个参数量高达 671B 的大型语言模型的预训练过程竟然只用了 266.4 万 H800 GPU Hours,再加上上下文扩展与后训练的训练,总共也只有 278.8 H800 GPU Hours。相较之下,Llama 3 系列模型的计算预算则多达 3930 万 H100 GPU Hours—— 如此计算量足可训练 DeepSeek-V3 至少 15 次。

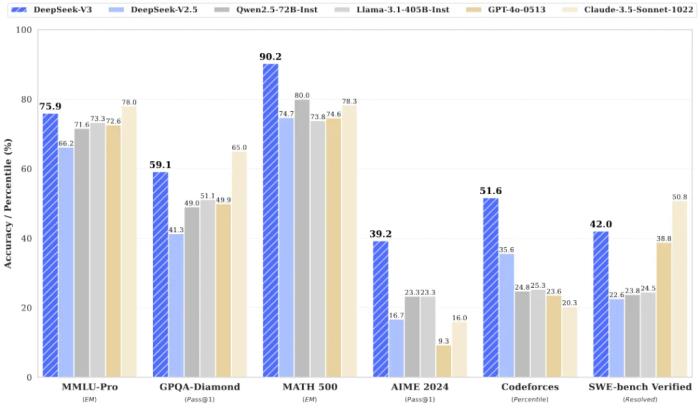

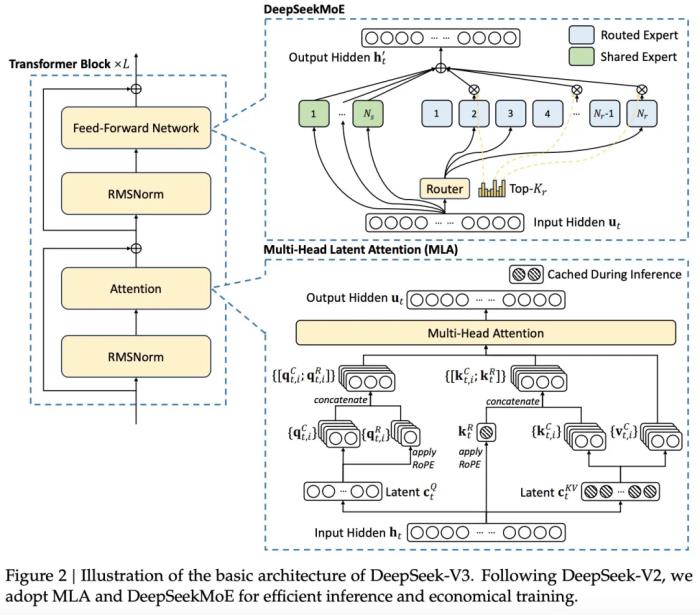

虽然相对于其它前沿大模型, DeepSeek-V3 消耗的训练计算量较少,但其性能却足以比肩乃至更优。据最新发布的 DeepSeek-V3 技术报告,在英语、代码、数学、汉语以及多语言任务上,基础模型 DeepSeek-V3 Base 的表现非常出色,在 AGIEval、CMath、MMMLU-non-English 等一些任务上甚至远远超过其它开源大模型。就算与 GPT-4o 和 Claude 3.5 Sonnet 这两大领先的闭源模型相比,DeepSeek-V3 也毫不逊色,并且在 MATH 500、AIME 2024、Codeforces 上都有明显优势。 DeepSeek-V3 的惊人表现主要是得益于其采用的 MLA(多头隐注意力)和 DeepSeekMoE 架构。此前,这些技术已经在 DeepSeek-V2 上得到了验证,现在也成为了 DeepSeek-V3 实现高效推理和经济训练的基石。此外,DeepSeek-V3 率先采用了无辅助损失的负载平衡策略,并设定了多 token 预测训练目标,以实现更强大的性能。他们使用的预训练 token 量为 14.8 万亿,然后还进行了监督式微调和强化学习。正是在这些技术创新的基础上,开源的 DeepSeek-V3 一问世便收获了无数好评。

DeepSeek-V3 的惊人表现主要是得益于其采用的 MLA(多头隐注意力)和 DeepSeekMoE 架构。此前,这些技术已经在 DeepSeek-V2 上得到了验证,现在也成为了 DeepSeek-V3 实现高效推理和经济训练的基石。此外,DeepSeek-V3 率先采用了无辅助损失的负载平衡策略,并设定了多 token 预测训练目标,以实现更强大的性能。他们使用的预训练 token 量为 14.8 万亿,然后还进行了监督式微调和强化学习。正是在这些技术创新的基础上,开源的 DeepSeek-V3 一问世便收获了无数好评。

Meta AI 研究科学家田渊栋对 DeepSeek-V3 各个方向上的进展都大加赞赏。

Meta AI 研究科学家田渊栋对 DeepSeek-V3 各个方向上的进展都大加赞赏。

著名 AI 科学家 Andrej Karpathy 也表示,如果该模型的优良表现能够得到广泛验证,那么这将是资源有限情况下对研究和工程的一次出色展示。

正在创业(Lepton AI)的著名研究者贾扬清也给出了自己的深度评价。他认为 DeepSeek-V3 的诞生标志着我们正式进入了分布式推理的疆域,毕竟 671B 的参数量已经无法放入单台 GPU 了。

DeepSeek-V3 再一次引爆了人们对开源模型的热情。OpenRouter 表示自昨天发布以来,该平台上 DeepSeek-V3 的使用量已经翻了 3 倍!

一些已经尝鲜 DeepSeek-V3 的用户已经开始在网上分享他们的体验。

接下来我们看技术报告内容。

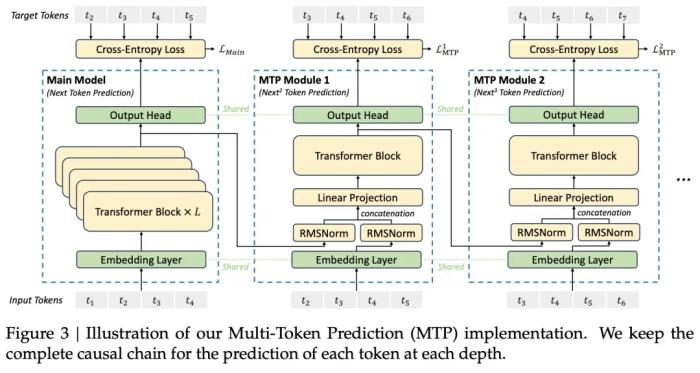

报告地址:https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf项目地址:https://github.com/deepseek-ai/DeepSeek-V3Hugging Face:https://huggingface.co/collections/deepseek-ai/deepseek-v3-676bc4546fb4876383c4208b架构为了高效的推理和经济的训练,DeepSeek-V3 采用了用于高效推理的多头潜在注意力(MLA)(DeepSeek-AI,2024c)和用于经济训练的 DeepSeekMoE(Dai et al., 2024),并提出了多 token 预测(MTP)训练目标,以提高评估基准的整体性能。对于其他细节,DeepSeek-V3 遵循 DeepSeekV2(DeepSeek-AI,2024c)的设置。与 DeepSeek-V2 相比,一个例外是 DeepSeek-V3 为 DeepSeekMoE 额外引入了辅助无损耗负载平衡策略(Wang et al., 2024a),以减轻因确保负载平衡而导致的性能下降。图 2 展示了 DeepSeek-V3 的基本架构:

MTP 将预测范围扩展到每个位置的多个未来 token。一方面,MTP 目标使训练信号更加密集,并且可以提高数据效率。另一方面,MTP 可以使模型预规划其表征,以便更好地预测未来的 token。

预训练数据构建与 DeepSeek-V2 相比,V3 通过提高数学和编程样本的比例来优化预训练语料库,同时将多语言覆盖范围扩大到英语和中文之外。此外,新版本对数据处理流程也进行了改进,以最大限度地减少冗余,同时保持语料库的多样性。DeepSeek-V3 的训练语料在 tokenizer 中包含 14.8T 个高质量且多样化的 token。超参数模型超参数:本文将 Transformer 层数设置为 61,隐藏层维度设置为 7168。所有可学习参数均以标准差 0.006 随机初始化。在 MLA 中,本文将注意力头

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

热门文章

新火种

2024-12-28

新火种

2024-12-28