基于CPU服务器实现Llama2等应用落地,英特尔展示五代至强可扩展芯片实践

本周,英特尔数据中心产品技术媒体分享会在北京举行。多位英特尔技术专家为我们从多个角度,以实践应用的角度解析了最新一代服务器 CPU 产品的技术特性及独特价值。

当前,AI 技术落地的速度正在加快,有全球调研结果显示,58% 的企业期待在近未来导入生成式 AI 等技术。预计到 2026 年,生成式 AI 的市场规模将达到 3000 亿美元,这其中包括硬件、软件、解决方案等。约会有 80% 以上的公司,会在 2026 年之前会导入某种程度的生成式 AI 以提高企业生产力。

据预测,到 2026 年,有 50% 以上的边缘应用也会采用 AI 技术。到 2028 年,还将有 80% 以上的 PC 会转换成 AIPC,通过 AI 提升桌面端生产力。

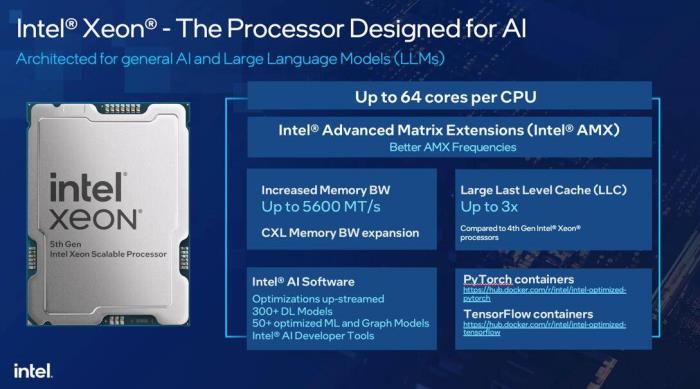

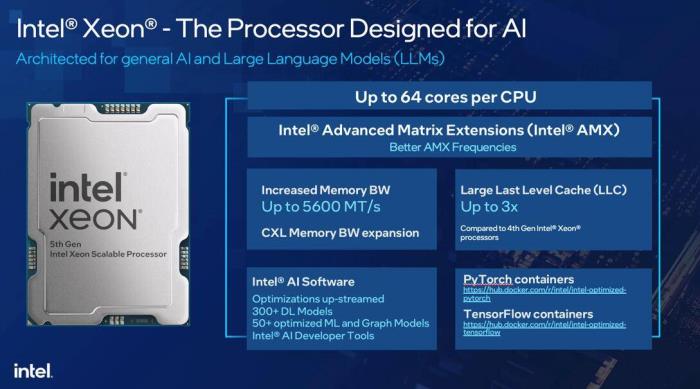

在这样的背景下,英特尔去年底发布了第五代英特尔至强可扩展处理器。与上代产品相比,其在核心数,以及多种性能指标上都有很大提升。第五代至强最多搭载 64 核心,英特尔通过 AI 相关的新指令集,如 AMX、AVX 等进一步提高了性能,这些性能提升对一些生成式 AI 应用带来了很大帮助。

在 AI 相关的参数上,新一代服务器芯片也有了提升。第五代至强在业界数据中心级的处理器当中,拥有较高内存带宽,达到 5600MT/s,也增加了三倍三级缓存。

随第五代至强的发布,英特尔在深度学习社区已贡献了超过 300 个模型,也支持了 50 个以上对新一代 CPU 优化过模型。此外,英特尔也加大了对主流大模型、AI 框架优化兼容的投入,让使用 PyTorch 和 TensorFlow 开发的资产可以无缝拓展至英特尔至强可扩展处理器上。

基于硬件和软件的优化,第五代至强和上代相比在 AI 训练、实时推理、批量推理上,基于不同的算法,都可以获得不同程度的性能提升,最高能达到 40%。

活动中,英特尔展示了通用服务器热门生成式 AI 大模型,如 GPT-J(6B)和 Llama2(13B)在一些通用场景中推理上的性能。

在聊天机器人、内容生成、代码生成或搜索等应用上,第五代至强从性能上可以满足应用需求,second token 生成的响应时间小于 100ms。

在满足 AI 应用的同时,使用 CPU 进行大模型推理也可以在性价比上满足需求,不论是在 BF16 或 int8 精度上,英特尔展示的用例都可以满足 100ms 的需求。

第五代至强可扩展处理器的性能同时得到了合作伙伴的验证。阿里云、百度云分别论证了基于第五代至强能够运行 Llama2 70B 参数的推理。实践证明使用第五代至强,在 Llama2 70B 参数的模型下,通过一个四节点的服务器,可以达到 87.5 毫秒的推理延迟性能。

有合作伙伴认为,在全盘考虑部署和运维成本等因素后,企业导入基于至强的生成式 AI 服务,如聊天机器人、知识库问答等基础的大模型使用,比基于服务器的云服务的初期导入成本低一半左右。

英特尔表示,在模型调优、推理和应用上,使用基于 CPU 的通用服务器是具有性价比的选择。尤其是当企业面临多种任务负载,如聊天机器人、内容生成、摘要分析等时。目前,百度云基于第五代至强 CPU 的服务器已在提供大模型服务。在京东基于第五代至强的应用中可以看到,和前一代的处理器相比,在 Llama2 13B 的模型上,获得了 50% 的性能提升。

「整体来看,在一些通用型应用,如会议纪要提取、大纲总结、内容分析,以及一些生成任务,尤其是最近较热门的文生图、聊天机器人、代码生成等生产力提升的应用中,使用通用算力,尤其是基于第五代至强的服务器是具有优势的,」英特尔市场营销集团副总裁、资深技术专家庄秉翰表示。「因此,我们非常有信心能够满足生成式 AI 模型的更多工作负载需求。」

在活动中,英特尔分享了未来至强可扩展处理器的发展路线图。

基于现在的第五代至强,英特尔计划发布下一代的性能核,也就是高主频、高性能的 CPU 核架构,为主流和复杂的数据中心的应用进行性能优化。面向目前流行的虚拟算力机制,用户可以获得非常好的性能提升。

同时对于新兴的,尤其是基于云原生的设计,英特尔提供能效核设计,每瓦性能可以做到相对极致,因为该版本核心较为精简,可以提高 CPU 和服务器的核心密度,所以它会支持面向云的高密度超高能效运算进行优化。

值得关注的是,英特尔近两年保持着密集的新产品发布节奏。该公司表示,在强大的执行力推动下,未来产品的研发和推出进度均在按期进行。

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2024-11-17

新火种

2024-11-17