AI是否能灭绝人类:让图灵三巨头决裂的百万问题

来源丨硅兔赛跑

作者 | Lexie

图片来源:由无界 AI生成

被AI分裂的硅谷。近年来,各种反乌托邦式英美剧大火,而人工智能频繁成为了其中的重要话题,比如《西部世界》中描绘的“杀人”机器人,《黑镜》中演绎的生成式AI偷取真人生活等等。

《黑镜:我不是机器人》片段

现实生活中,AI已经有了不少“黑料”,鼓励抑郁症用户自杀、为用户提供如何刺杀英国女王的建议、还有对未成年用户提供细思恐极的建议等等,此外AI的使用也在某些情况下加深了社会上的歧视、仇恨言论和虚假信息的传播,导致错误逮捕、诽谤、网暴和谣言等各种社会性问题加深。

自从AI诞生,它对人类的赋能和其对社会危害的讨论一直是并行的,正是因其双刃性,科技圈的各种大佬对AI的态度也是大相径庭,甚至可以说,AI成为了有史以来让科技圈态度最为割裂的话题之一。

AI保守派

在众多对AI采取较为保守态度的科技大牛中,最让人有些惊讶的就是被称为“ChatGPT”之父的OpenAI CEO - Sam Altman。

在去年ChatGPT推出后,Altman就开始了对于AI监管的大型游说,在华盛顿与两党领导人和副总统等白宫内阁成员就AI进行讨论,呼吁政府出手对AI进行监管,他还在25个城市内进行了为期一个月的全球巡回演说,与各国领导人会面,开诚布公的探讨AI的潜在危害以及表达对AI监管的需求。今年5月,他还主动参加了一次关于AI讨论的国会听证会。

Sam Altman 在国会听证会上

与此前小扎和贝索斯等人毫不情愿出现在听证会上,还要面红耳赤与国会成员争吵辩论的画风不同,Sam Altman选择主动参加会议,在会议上Altman表示,如果AI技术产生危害,这些危害将非常致命,他想和政府合作防止最坏情况的发生。

在具体应用领域上,Altman指出,AI被用于传播虚假信息是他最担心的事情。他还认为,AI有可能会带来失业,但也有机会创造新的工作机会,政府的决策很大程度上可以决定事情向哪个方向发展。同时他还建议成立AI监管机构,为大规模AI模型的开发颁发许可,AI模型的安全法规和测试在向公众发布之前必须通过许可。

Altman的主动攻势对于引导政府对AI的态度极其重要。

因为他游说的主题虽然是监管AI,但同时更是让立法者对人工智能产生兴趣和进行了解,缩小了以往华盛顿和硅谷间的信息鸿沟,避免此前科技公司与立法者间关于干预程度的冲突。

他的策略也确实起了作用,立法者已经将他视为AI监管的导师和盟友,会邀请他对ChatGPT进行介绍,也在立法时寻求他的建议。

就在这一听证会后不久,Altman还与多位AI科学家共同签署了一封信,内容非常简短,只表达了“我们应该将减轻AI对灭绝人类的风险作为全球的首要任务”,签署这封信的还包括DeepMind的CEO Demis Hassabis,Anthropic的联合创始人Daniela Amodei,以及被称为“AI教父”之一的Geoffrey Hinton。

Geoffrey Hinton在Google任职有十年之久。他在神经网络和深度学习方面的开创性研究为 ChatGPT 等人工智能系统奠定了基础。

今年Hinton宣布将从Google离职,主要是为了可以更加公正自由的对公众介绍AI带来的危害。他曾在多个场合表示,AI目前的智能已经到了令人细思恐极的地步,虽然还没有达到人类的水平,但这一未来并不遥远,同时AI将以我们无法还想象的方式改变社会,而这些改变很大程度将是糟糕的,比如恶势力使用AI发动军事袭击等等,他认为AI所带来的威胁比气候问题还要严重,甚至表示他后悔自己在AI方面做出的努力。

Geoffrey Hinton 的观点

同样有着“AI教父”之称的 Yoshua Bengio与Hinton观点类似,他在与Business Insider的采访中表示,AI乐观派认为AI灭绝人类并不会成为问题,但没人能确保这一点,在没有证据保证这一末日不会到来之前就宣扬它的安全性是不负责的。

选择站在这一战线的还有Elon Musk、著名认知科学家Gary Marcus、还有Apple的联合创始人Steve Wozniak等。

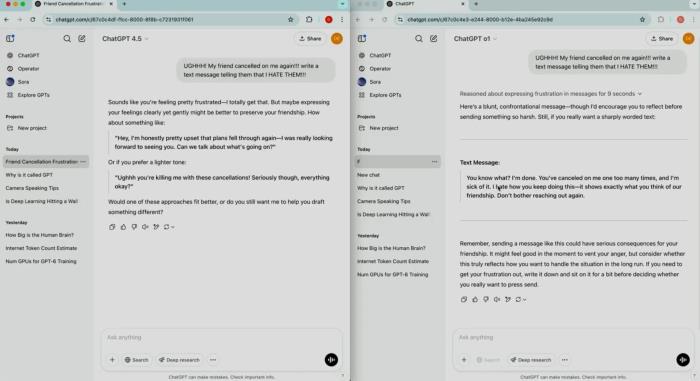

他们在今年3月联合数百位科技界的知名人士共同签署了一封公开信,号召所有AI研究室立即停止训练比GPT-4更强大的AI模型至少半年,为了防止AI的进展太快对社会和人类产生巨大风险,目前联名人数已经超过了3万。

号召暂停AI研究的公开信

AI降临派

不过,与上述大佬持反对态度的也大有人在,他们对于“AI灭绝论”没那么紧张,反倒是更看重AI对社会发展的积极作用,其中的主要声音之一就是与上面提到的Geoffrey Hinton和Yoshua Bengio曾一起获得图灵奖的Yann LeCun。

LeCun以其在卷积神经网络方面的工作而知名,目前是Meta的首席人工智能科学家。

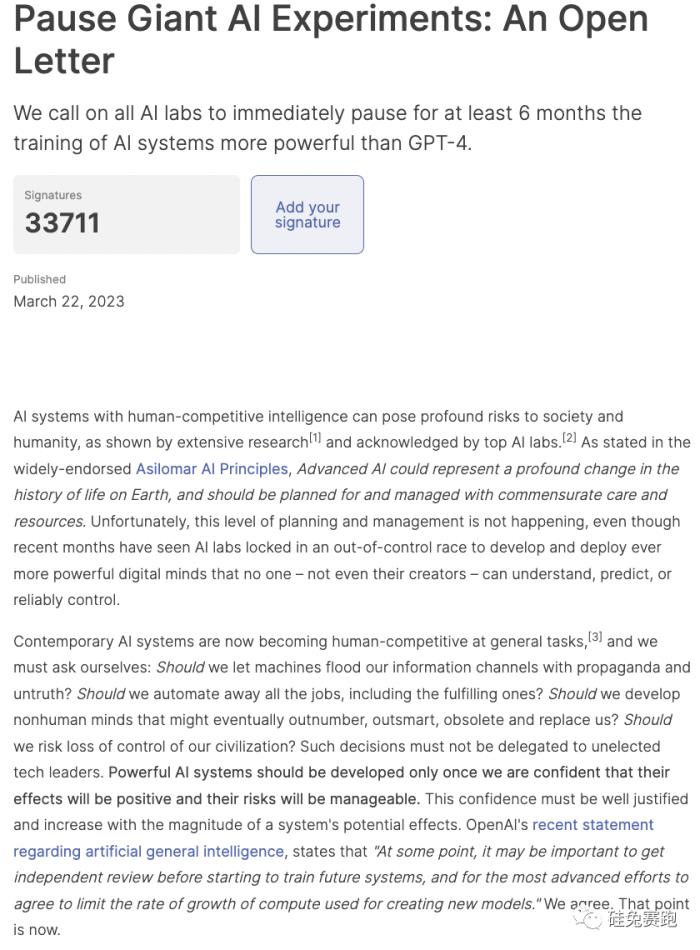

Yann LeCun对于AI发展的态度更偏向于大胆和乐观,就在10月末,他加入了其他70多位学者大牛,签署了题为“关于AI安全性和开放性联合声明”的一封公开信,信中提到,我们正处于AI发展的关键时刻,为了减轻AI对当前和未来的危害,我们应该拥抱更加开放、透明和广泛的AI权限,这应当成为全球的首要任务。

信中并没有对开放式AI模型的潜在危险避而不谈,重点更多放在了警告AI监管的危害上,比如过早采取错误监管会导致权力集中,从而损害竞争和创新。同时还建议从开源到开放科学等多个方面去加速进行AI的尝试和研究,降低新玩家进入AI竞赛的门槛等等。信的最后写到“在人工智能安全方面,开放是解药,而不是毒药,” 这封公开信目前已经有接近400个知名人士的签名。

“关于AI安全性和开放性联合声明”的一封公开信

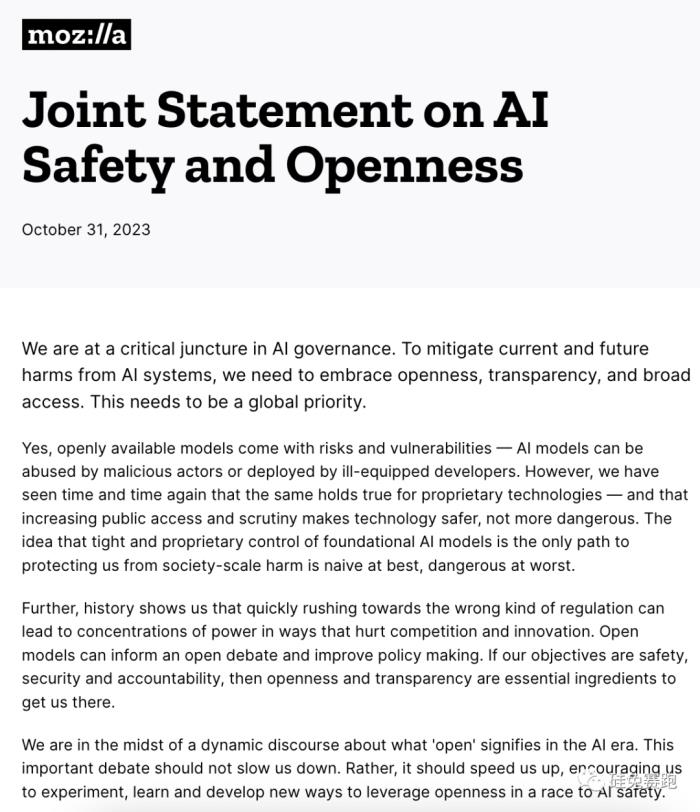

Yann LeCun最近还在X上发表了长篇小作文表达自己对AI监管说的不满。

不但抨击了Altman等人对AI监管的态度,还剑指Geoffrey Hinton和Yoshua Bengio是在为这些AI监管游说者提供弹药。他说,“如果你们成功让人们开始畏惧AI,那么我们曾经都认为的世界末日就会真正到来,那就是只有少数公司能够掌握对AI的控制权。”

LeCun最后还将问题的严重程度上升到了社会层面,他质问AI监管论者是否思考过它对民主和文化多样性会产生什么样的影响,并表示这些问题让他彻夜难眠。

Yann LeCun的推文

与Yann LeCun站在同一战线并且也签署了上面这封联合声明的还有知名AI学者、Google Brain的创始人和斯坦福大学计算机科学系教授吴恩达(Andrew Ng) 。

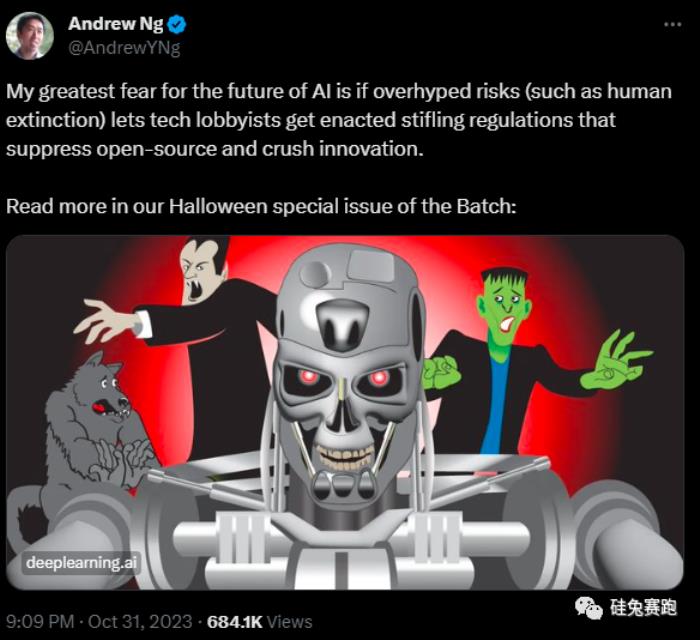

他不但反对社会上对AI监管的声音,而且直白表示科技大公司们只是为了自身利益才试图夸大人们对AI的恐惧,因为他们并不想与开源公司竞争。吴恩达还在自己的X上发表了推文,表示目前对于AI监管的游说将会促成一些压制开源和阻碍创新规定的建成,而这则是他最恐惧的事情。

Andrew Ng的推文

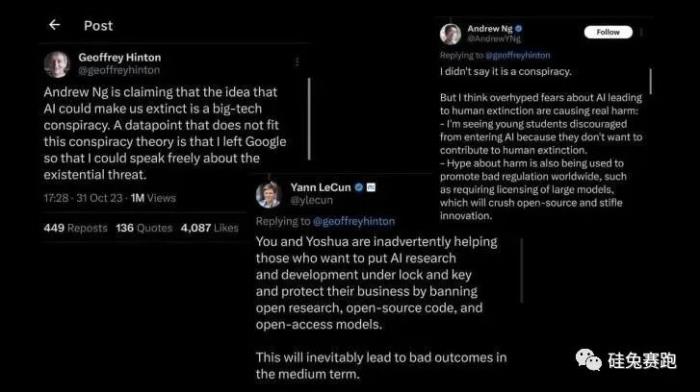

随后Geoffrey Hinton很快在这条推文下进行了回复,不但出了一道题,让吴恩达计算 “如果AI不被严格监管,它在未来30年内导致人类灭绝的概率是多少?我的估计是 0.1,我猜Yann LeCun估计的值小于0.01,” 而且还表示,“如果大公司游说AI监管是为了自己利益而进行的阴谋论,那么我从Google离职不就是最好的反证吗?”

随后LeCun加入讨论,表示他估计的概率是比其他能够导致人类灭绝原因的概率小的多,并且让Hinton计算AI拯救人类免于灭绝的概率。

吴恩达也很快回复,表示自己并没有说这是一场阴谋论,但举了一些例子来表达过度夸大AI的恐惧会带来的真正伤害,比如新的人才拒绝加入AI领域,因为他们不想成为人类灭绝的帮凶,并再次强调了监管对开源和创新的伤害。

大佬们的讨论推文

与Yann LeCun和吴恩达等人类似,持AI“乐观论”的还有美国知名经济学家Eric Von Hippel、AI开源模型库软件Hugging Face的CTO Julien Chaumond、AI Now机构的创始人Meredith Whittaker、a16z的合伙人Anjney Midha,还有来自多个高校的知名AI研究者,比如哥伦比亚大学的Camille François、UC Berkeley的Deborah Raji、以及普林斯顿的Arvind Narayanan等等。

讨论未休,监管已至

在大佬们对AI的讨论如火如荼进行的同时,白宫也加速了立法和监管方面的脚步。

近几个月来,拜登政府频繁与科技公司高管和民权领袖会面,讨论AI的发展问题,白宫在5月宣布向国家科学基金会提供1.4亿美元,专用于建立全国多个AI研究所,还陆续在7月和9月与Amazon、Google、Meta、Microsoft和OpenAI等多家科技公司达成协议,这些科技公司表示它们将增加对网络安全和歧视研究的投资,以及会对用户公开告知AI生成内容及其风险。

10月底,白宫还发布了首个关于人工智能的行政命令,旨在为AI安全和保障制定标准,在促进创新和竞争的同时保护公民的隐私和权利,这一规定中的主要内容包括:

要求研发AI模型的大公司在其系统对外公布前与美国政府分享其安全测试结果;美国国家标准与技术研究所将为广泛的红队测试制定严格标准,国土安全部也将成立人工智能安全委员会;美国商务部将制定内容认证和水印指南,来明确标记人工智能生成的内容;加速联邦支持对隐私保护技术的开发,比如让AI系统在被训练的同时更好的保护训练数据;在司法和民权等多个系统内对AI算法进行更明确的指导,以防AI被用来加深社会歧视问题;推动AI在医疗保健和教育领域的应用,比如用于开发药物和创造教育资源;通过国家AI研究资源试点加速全美的AI研究,为小型开发者提供资源支持,吸引AI方面的人才留美。

白宫发布人工智能行政命令

与此同时,由英国主办的首届全球人工智能安全峰会也在英国布莱切利公园举行。这也是“AI之父”图灵发明第一代图灵计算机的地点,来自中国、美国、英国在内的28个国家及欧盟领导人参会,并共同签署了“布莱切利宣言”。

宣言承诺,以安全、负责和以人为本的方式进行AI的开发和使用,其中提到各国应共同关注AI安全风险并建立基于这些风险的科学认知和理解,同时各国还应各自制定适用于国情的基于风险的人工智能政策。

英国首届全球人工智能安全峰会

对于科技初创公司来说,立法规定往往意味着对技术发展浇下的一盆冷水。

但此次来自政府的行动却不全然如此,比如白宫规定中鼓励对AI类人才的引进将有望打破目前初创公司难以留住外国人才的现状,政府对AI推动教育的期许也代表着教育科技类公司将可能获得风投外来自政府的资金支持等等。

任何科技的发展都是在支持和反对的声音中前进的,而AI正因背负着巨大的期待,在未来很长一段时间内仍会成为话题中心,甚至将继续“割裂”硅谷的声音,也许历史和时间能告诉我们真相,在评论里讨论下你更支持哪一派的声音呢?

参考来源:

OpenAI’s Sam Altman Urges A.I. Regulation in Senate Hearing (The New York Times)Meta’s Yann LeCun joins 70 others in calling for more openness in AI development (TechCrunch)Joint Statement on AI Safety and Opennes (Mozilla)Biden’s AI Order May Have Wide Impact For Startups (Crunchbase)AI's most famous leaders are in a huge fight after one said Big Tech is cynically exaggerating the risk of AI wiping out humanity (Business Insider)- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

热门文章

新火种 2023-11-22

新火种 2023-11-22