我们经常说的GPT是什么意思?详解GPT的运作原理

GPT的运作原理实质上就是接龙游戏,让我们来看个简单的例子:今天的天气很______,那么,我们应该填什么字让这个句子完整呢?可以是:今天的天气很热,今天的天气很好,这些都是合理的句子。如果填今天的天气很香,就可能有点不合适了。

如果我们问电脑这个问题,它是怎么回答的呢?在电脑被训练之前,它并不知道答案,它就像是一个小婴儿,因此如果想让电脑能够回答问题,我们就要先让它学习人类的语言。为此,我们需要将所有书籍、维基、百科等文本内容都丢给电脑,让它使用一套复杂的算法自学,让它自己在这些文本中学习人类语言的结构和文本之间的关联关系。那电脑学习之后的结果就是一个可以预测下一个文字的模型,在这里是GPT,它就会预测今天的天气很后面的文字。

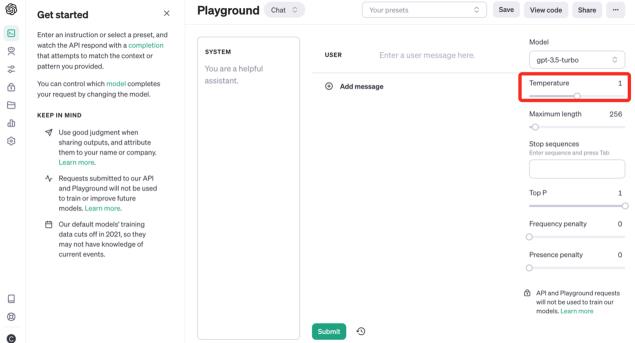

参数:温度(temperature)

它实际上是有一个可能的文字列表,包括这个文字以及这个文字的概率,比如80%的概率是热,60%可能是冷,90%可能是好等等。那么GPT它是不是就选择概率最高的呢?也不一定。它具体选择哪一个,这是由一个叫做温度(temperature)的参数来控制的。

温度越高,GPT的选择就会越随意,它就可能会选中更多低概率的词。而温度越低GPT就越保守,他就会选择高概率的词。

因此,如果用同样的方法,一个字一个字的进行,那么使用GPT就可以完整地输出一句话甚至一篇文章。但是,必须要知道,GPT的预测不是以字为单位进行的,它的预测单位被称为token,而一个token可能只是一个英文单词的一部分。后面我们还会再次提到token的相关信息。

大语言模型

我们已经了解了什么是模型以及语言模型的基本工作原理。之所以称它们为大语言模型,是因为为了提高模型的准确度,它们需要很多很多的参数。例如,GPT3模型就拥有了1750亿个参数。

我们之前提到过,我们可以把文本丢给电脑让它自学,最终学会了一套模型,这个过程就叫无监督学习。电脑自学的模型被称为基本大语言模型或Basic Large Language Model。那么,怎么进一步提高语言模型的预测能力呢?这时候就需要人类的指导了。仅靠自学是不够的,老师必须上场。

比如,当语言模型给出结果“今天天气真好”时,训练工程师会给出反馈说“不对,应该说‘今天天气真热’”。如此反复之后,模型就会在人类的指导和反馈下,通过对基本大语言模型的微调,形成一个更符合我们期望的模型。这个模型是基于人类反馈的强化学习微调得到的,因此被称为指令微调(Instruction-Tuned-LLM)的大语言模型。因此,当我们看到InstructGPT时,这个Instruct就是指导指令的意思,而我们经常看到的另外一个词,RLHF(Reinforcement Learning fromHuman Feedback,人类反馈强化学习)就是基于人类反馈的强化学习单词的首字母的缩写简称。

概念小结

了解了整个过程之后,咱们来简单总结一下。

模型是机器通过学习获得的一种输入数据和输出数据之间的映射关系,影响模型效果的因素的权重就是模型的参数。

GPT本质上就是一个不断预测下一个token的概率的模型。温度(temperature)会控制GPT使用低概率token的频率。

大语言模型可以简单地分为两类:基本大语言模型和指令微调的大语言模型。

那我们经常说的GPT又是什么意思?

GPT的全称是Generative Pretrained Transformer,通过上面的概念梳理,我们就可以更加容易地去理解这三个词的意思了。

Generative(生成式),它意味着模型的目的,是生成或者输出新的文本。GPT能够生成连续流程的句子或者文本段落,这并不是简单的,它从训练数据当中复制和粘贴出来的结果。

而Pretrained(预训练),这就表示模型它首先是在大量的文本上进行了预先的训练,预训练的过程它就让模型学会了许多关于语言的知识。

Transformer,这是一种特定的机器学习架构,就类似于我们之前说的机器学习文本时候用的学习方法算法。

我们只需要知道这一点就可以了,不用再去深入了解它的到底是什么样的算法,我们只要知道它是一种学习的算法就行了。另外,虽然这个单词翻译成中文是变压器,但是,一般我们不会去叫它变压器,需要的时候呢,我们就直接使用Transformer这个英文名词就可以了。

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2023-11-17

新火种

2023-11-17