“百模大战”下半场开打,平台将成关键

原文来源:钛媒体

图片来源:由无界 AI生成

离大模型走进人们的视野已经过去近一年的时间,在AI大模型的浪潮下,各大科技企业争先恐后的推出了各自的大模型产品。与此同时,各行业企业也对大模型保持着高度关注。

如果说,各大厂商纷纷推出大模型产品形成“百模大战”的局势,是大模型这场“战役”的上半场的话,那么这场“战役”的下半场将更聚焦在大模型产品的整合能力,以及平台化、行业化的发展方向。

下半场开打,平台化、行业化将成关键赛道

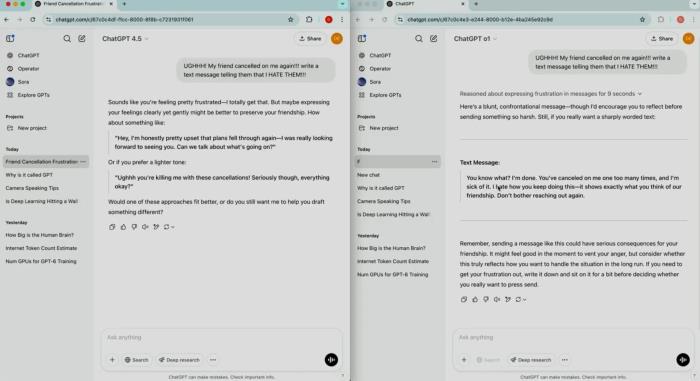

从大模型这一年的发展可以看出,目前各个厂商的大模型几乎是“各自为战”,都通过自身的产品意图抢占更多的市场,以大模型“鼻祖”ChatGPT为例,ChatGPT是个应用,可以看作一个APP,而GPT4则是个大模型,构建了类似大模型的生态,让企业可以以此为基础,打造自身的大模型。

从上述案例可以看出,过去近一年的时间,各家都将主要精力放在类似“ChatGPT”的产品打磨上,落地点在应用侧,而对于企业侧而言,目前行业还是较缺乏一个平台,让企业可以灵活调用各家大模型产品,或者基于某家的产品开放针对自身需求的大模型。在神州数码副总裁CTO李刚看来,大模型如果想要在企业侧实现应用的爆发,需要一个,甚至多个开源、开放的大模型平台。

说到企业级大模型应用,就不得不提一提行业大模型,钛媒体观察发现,目前行业级大模型还处于发展的初级阶段,虽然有很多家企业推出了行业大模型,但是应用并不很好。

以发展较快的金融行业为例,今年3月,彭博首度针对金融业推出大型语言模型BloombergGPT,引发市场对金融垂直领域大模型的关注;6月,哥伦比亚大学联合上海纽约大学推出FinGPT 。

在国内,7月,华为全新发布盘古大模型,金融行业大模型正是其中数个行业通用大模型之一;9月,蚂蚁集团正式发布自研“蚂蚁基础大模型”,以及在此基础上进行定制的“蚂蚁金融大模型”。

李刚对钛媒体表示,目前市面上的大模型种类主要分为几类,一类是通用的基础大模型,一般来说,这些大模型通过自然语言的语料构建数据库,经过清洗、训练等操作,打造了基础大模型,“这类模型,语料库越大、参数量越大,能力就越强。”李刚表示。

另一类就是行业大模型,这类模型具有极强的专业性,需要大量行业专业知识库,“目前,这个行业知识库的语料需控制在20%,不多不少。”李刚强调,“超过20%,训练出来的大模型可能就‘不会说人话’,造成沟通障碍;少于20%,又不具备行业的专业性。”

打造大模型的“PaaS”层

就像云计算有IaaS、PaaS、SaaS之分一样,在神州数码战略营销部总经理皇甫子乔看来,大模型时代,企业也需要一个类似云时代PaaS平台。

为了给企业构建一个更好使用大模型的平台,神州数码近日正式发布了神州问学平台,谈及平台发布的意义时,李刚对钛媒体表示:“以神州问学平台为核心,我们不做基础大模型,而是做大模型的集成与应用开发交付平台,从而加速企业AI创新;我们做大数据的服务伙伴,从而加速企业数据治理升级;我们做生态纽带、模型市场、数据集市、应用商店,从而加速产业创新与生态破局。”

今年初,华为云发布了盘古大模型,并将大模型按照L0、L1、L2进行了分级。按照华为云的分类,L0指基础大模型,L1指行业大模型,L2则是指面向更加细分场景的推理模型。

基础大模型方面,以图网络大模型为例,一个大模型可以适配工艺优化、时序预测、智能分析等多个场景,同时应用在金融、煤矿、制造等多个行业。

行业大模型方面,华为云推出了如盘古金融大模型、盘古矿山大模型、盘古电力大模型、盘古制造质检大模型、盘古药物分子大模型等行业大模型。

推理模型方面,以在电力行业为例,华为云基于盘古电力大模型,针对无人机电力巡检细分场景,通过一次预训练+下游任务的微调,推出盘古电力巡检大模型,解决了无人机智能巡检系统(缺陷检测)中的小样本学习、主动学习、增量学习等问题,解决了海量数据标注工作量大和缺陷种类繁多的问题。

上述是华为云对于大模型的理解,以及华为云的一些产业布局。基于此,皇甫子乔对钛媒体表示,神州数码问学平台在帮助企业从L0到L2行业应用场景落地过的程中,将起到“转换器”的作用,“为企业提供一个类似云计算时代PaaS平台的能力。”皇甫子乔如是说。

无独有偶,百度CTO王海峰也曾公开表示,面对大模型产业化的挑战,行业需要类似芯片代工厂模式,采用“集约化生产,平台化应用”的模式,即具有算法、算力和数据综合优势的企业将模型生产的复杂过程封装起来,通过低门槛、高效率的生产平台,为千行百业提供大模型服务。

据钛媒体了解,目前,这一产业化路径已在文心大模型产业实践中得到验证,百度与各行业头部企业、机构共建了包括能源、金融、航天、制造、传媒、城市、社科以及影视等行业大模型。

更低成本、更低门槛是目标

虽然大模型已经逐渐向各行各业渗透,但就现阶段大模型发展来看,对于企业级用户而言,大模型的使用成本依然让很多企业望而却步。

以GPT-3为例,英伟达曾披露训练一次1750亿参数的GPT-3需要34天,使用1024张A100 GPU芯片,单次训练成本高达1200万美元。为了训练超大规模的AI模型,微软甚至为OpenAI构建的一台排名世界前五的超级计算机。

与此同时,据国盛证券《ChatGPT 需要多少算力》报告估算,大模型的前期训练成本很高,一次训练的成本超过百万美元。这个费用不仅涵盖了模型的架构、算法和训练数据的选择,还包括了模型训练所需要的大量计算资源和时间成本。而且随着大模型版本的升级,其训练成本也呈几何式增长。

百度创始人、董事长兼首席执行官李彦宏也曾指出:“无论是哪家公司,都不可能靠突击几个月就能做出这样的大语言模型。深度学习、自然语言处理,需要多年的坚持和积累,没法速成。”

面对如此高额的大模型使用成本和使用门槛,是一般企业承担不起的,也正是如此,目前为止,还没有一个真正意义上完善落地的行业大模型产品面世。对此,皇甫子乔表示,大模型的使用成本是很多企业应用大模型赋能业务的最大阻碍,而神州问学平台的定位就是希望通过开源的形式,让企业以更低的选择成本,使用大模型产品。“神州问学主要包含两个部分,一部分是平台,另一部分是开箱即用的场景应用。”皇甫子乔对钛媒体表示,“这两部分一方面希望集合更多生态伙伴,共同赋能用户;另一方面,希望企业可以更快、更便捷的使用大模型产品。”

将大模型的使用成本和使用门槛降低是行业内的共识,无论是“一卡难求”的GPU,还是高额的电费,都是现阶段企业应用大模型的门槛,而诸如神州问学、百度千帆、昆仑万维等,“风格迥异”,却目标相同——“助力大模型落地”的平台级产品的涌现,以及大模型生态中合作伙伴的不断增加,企业应用大模型的门槛和成本必将进一步的降低,我们离行业大模型的普惠也将越来越近。

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

热门文章

新火种

2023-11-11

新火种

2023-11-11