DeepSparse:利用稀疏性加速神经网络推理

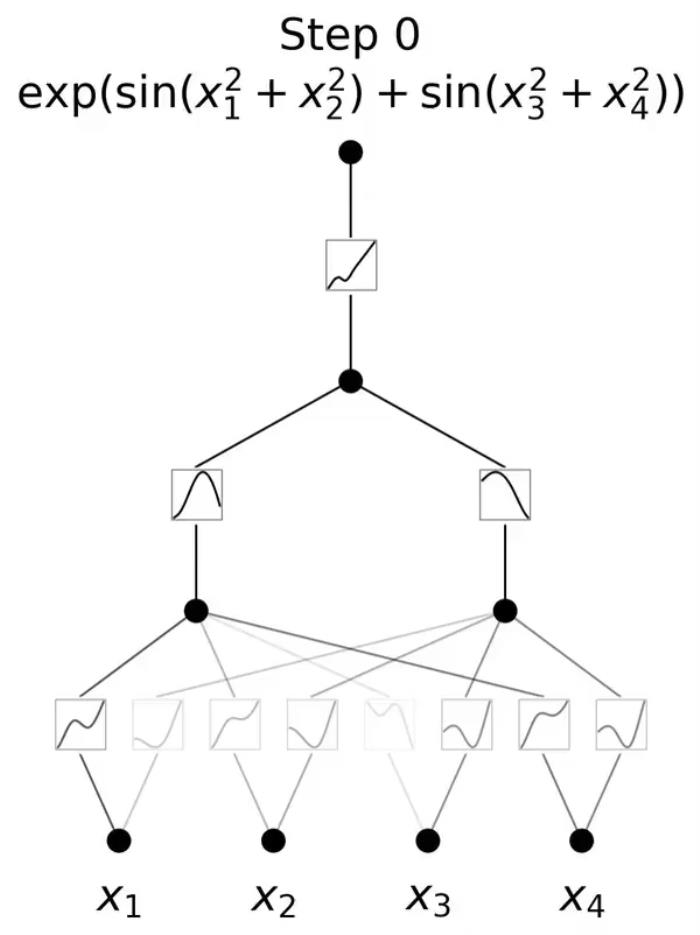

站长之家10月26日 消息:DeepSparse是一种突破性的CPU推理运行时,采用了复杂的稀疏性技术,从而实现了神经网络推理的加速。稀疏性是指神经网络中存在许多连接权重为零的情况。

DeepSparse充分利用了这些零权重的连接,以跳过不必要的计算,从而有效地提高了推理速度。作为一个开源项目,DeepSparse的代码库可以在GitHub上找到。

项目地址:https://github.com/neuralmagic/deepsparse

目前,DeepSparse已经成功集成到了TensorFlow中,并成为了TensorFlow不可或缺的一个组件。

最新的DeepSparse LLM支持以稀疏内核进行加速,实现从非结构化稀疏权重中的速度提升和内存节省,同时支持8位权重和激活量化以及高效使用缓存的注意力键和值,从而减少内存移动。不仅如此,DeepSparse还支持多种计算机视觉和自然语言处理模型,包括BERT、ViT、ResNet、YOLOv5/8等等。

核心功能:

稀疏性加速: DeepSparse使用稀疏性来加速神经网络推理,从而提高性能。

LLM支持: 支持性能卓越的LLM推理,包括稀疏内核、8位权重和激活量化,以及缓存注意力键和值的高效使用。

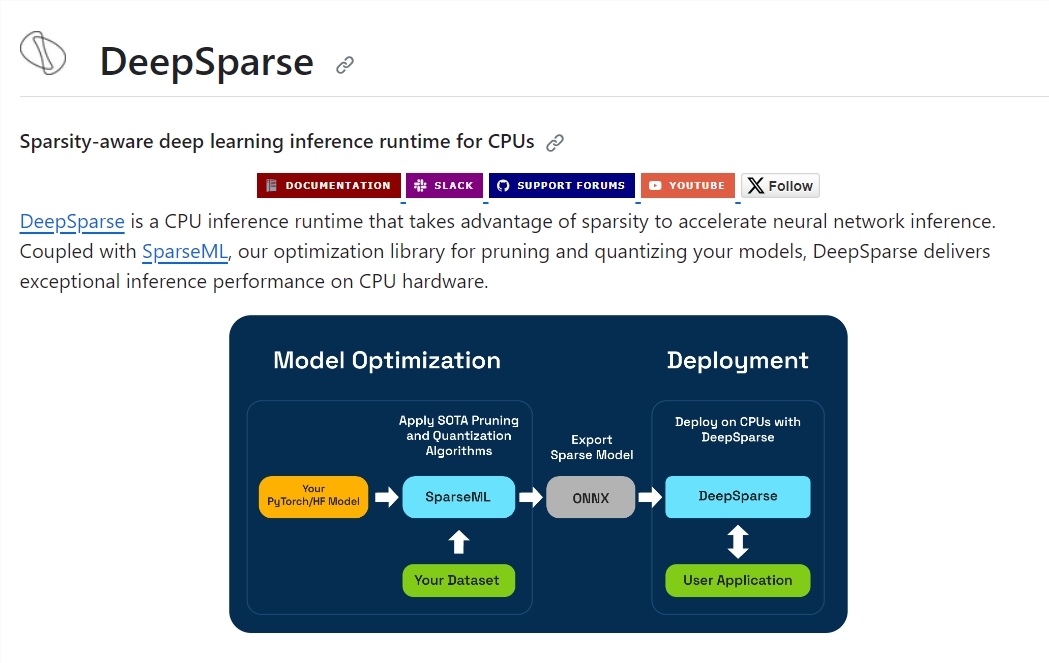

模型优化: 与SparseML合作,DeepSparse可以进行模型修剪和量化,以优化神经网络模型。

多种模型支持: 支持多种计算机视觉和自然语言处理模型,适用于各种任务。

多层次API: 提供引擎、管道和服务器等多层次的API,以满足不同应用场景的需求。

相关推荐

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2023-10-29

新火种

2023-10-29