AI科学家何恺明将从Facebook回归学界:明年起执教麻省理工学院

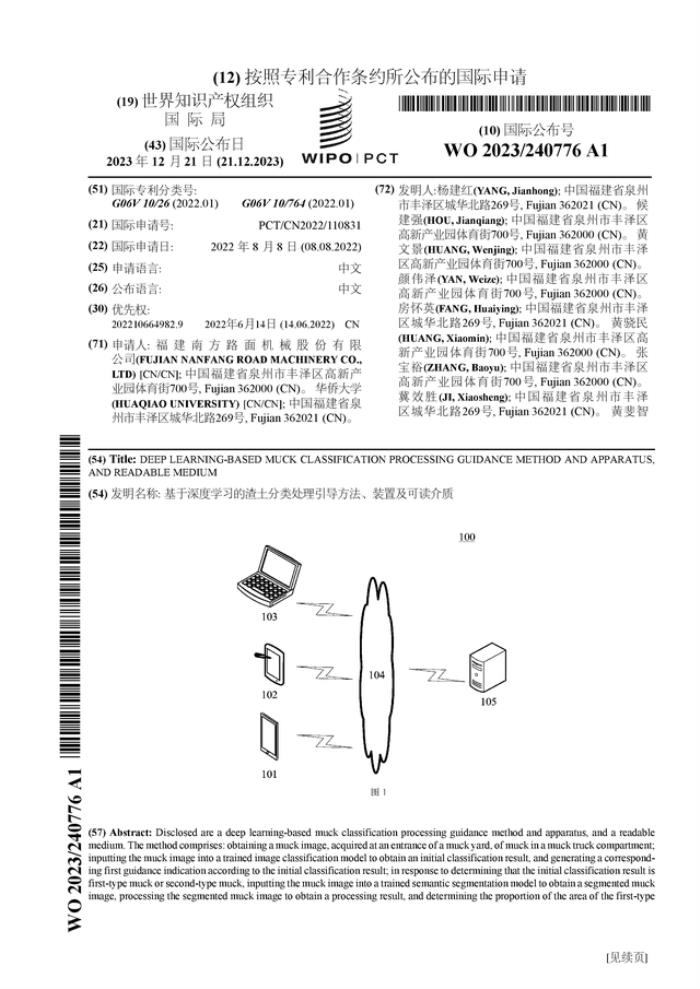

·“作为一位FAIR(Facebook AI Research)研究科学家,我将于2024年加入麻省理工学院(MIT)电气工程与计算机科学系EECS担任教职。”

·何凯明的CNN(卷积神经网络)模型ResNet在网络的每一层引入了一个直连通道,从而解决了深度网络的梯度传递问题,获得了2016年CVPR的最佳论文奖,是计算机视觉历史上被引用最多的论文。

近日,AI领域著名学者、残差神经网络ResNet发明人何恺明在个人网站上宣布即将回归学界,加入麻省理工学院(MIT)担任教职。

何恺明的主要研究领域为计算机视觉和深度学习,他的ResNets论文是2019年、2020年和2021年Google Scholar Metrics所有研究领域中被引用最多的论文,并建立了现代深度学习模型的基本组成部分。在深度学习模型Transformers、AI围棋工具AlphaGo Zero、AI蛋白质结构预测工具AlphaFold中都有使用ResNet。

今年3月,何恺明在MIT的一场演讲中透露,接下来的研究方向会是AI for science(人工智能用于科研),将聚焦计算机视觉、NLP(自然语言处理)和self-supervised(自监督学习)。作为目前Facebook AI Research(FAIR)的研究科学家,他已经在个人网站中换上了全新的头像,并在置顶的声明中表示,“作为一位FAIR研究科学家,我将于2024年加入麻省理工学院(MIT)电气工程与计算机科学系EECS担任教职。”

AI领域著名学者、残差神经网络ResNet发明人何恺明在个人网站上的声明。

师从汤晓鸥

2003年,何恺明以标准分900分获得广东省高考总分第一,被清华大学物理系基础科学班录取。毕业后,他进入香港中文大学多媒体实验室攻读博士学位,师从香港中文大学教授汤晓鸥。何恺明曾于2007年进入微软亚洲研究院视觉计算组实习,实习导师为孙剑博士。

2011年博士毕业后,何恺明加入微软亚洲研究院任研究员。2016年,他加入Facebook人工智能实验室,任研究科学家至今。

何恺明的研究曾数次获奖。2009年,汤晓鸥教授、孙剑博士和当时博士研究生在读的何恺明共同完成的论文《基于暗原色的单一图像去雾技术》拿到了国际计算机视觉顶会CVPR(IEEEConference on Computer Vision and Pattern Recognition,即IEEE国际计算机视觉与模式识别会议)的最佳论文奖,也是该会议创办25年来首次有亚洲学者获得最高奖项。

2016年,何恺明凭借ResNet再获CVPR最佳论文奖,此外,他还有一篇论文进入了CVPR2021最佳论文的候选。何恺明还因为Mask R-CNN(实例分割算法)获得过ICCV(IEEE International Conference on Computer Vision,即国际计算机视觉大会)2017年的最佳论文马尔奖(Marr Prize),同时也参与了当年最佳学生论文的研究。

根据Google Scholar的统计,何恺明一共发表了73篇论文,H Index数据为67。截至2023年7月,何恺明的研究引用次数超过46万次,并且每年以超过10万次的速度增长。

ResNet发明人

何恺明最著名的一项工作是提出了一种残差网络的结构ResNet,用以解决神经网络中的退化问题,即网络的层数越深,在数据集上的性能表现却越差。而ResNet允许网络结构尽可能地加深,并引入了全新结构,目前的人工智能或多或少都受到了这个结构的影响。

汤晓鸥曾在2023世界人工智能大会上介绍了何恺明的工作和成就,“在2015年之前,深度学习最多只能训练20层,而CNN(卷积神经网络)模型ResNet在网络的每一层引入了一个直连通道,从而解决了深度网络的梯度传递问题,获得了2016年CVPR的最佳论文奖,是计算机视觉历史上被引用最多的论文。”

“在ResNet之后就可以有效地训练超过百层的深度神经网络,把网络打得非常深。”汤晓鸥说,“在大模型时代,以Transformer为核心的大模型,包括GPT系列,也普遍采用了ResNet结构,以支撑上百层的Transformer的堆叠。何恺明把神经网络做深了,谷歌把神经网络的入口拉大了,又深又大,才成为今天的大模型。”

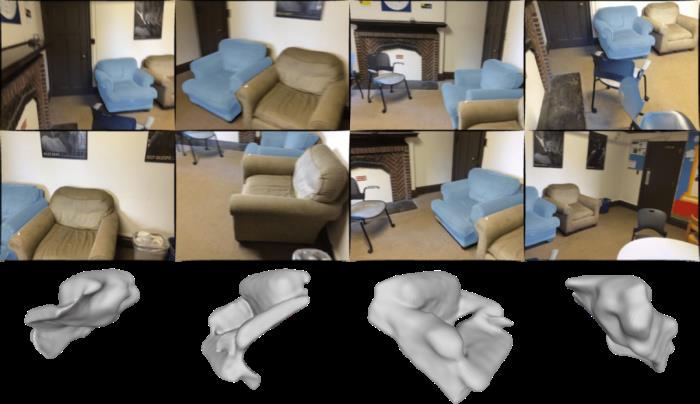

汤晓鸥表示,何恺明还有一项工作——Mask R-CNN算法,是就职于Facebook时开发的,是一个真正高性能的物体检测算法框架,获得了ICCV 2017年最佳论文。“恺明应该是世界上唯一一个在毕业不到10年内3次以第一作者身份获得CVPR和ICCV最佳论文的人。”汤晓鸥表示,Mask R-CNN首次把基于掩码的自编码思想用于视觉领域的非监督学习,开启了计算机视觉领域自监督学习的大门,并被推广到3D领域、音频领域,甚至是AI for science领域。

2021年11月,何恺明以一作身份发表论文《Masked Autoencoders Are Scalable Vision Learners》,提出了一种泛化性能良好的计算机视觉识别模型,同样是刚刚发表就成为了计算机视觉圈的热门话题。

从何恺明个人网站上的叙述来看,这可能也是他接下来的研究方向:“通过计算机视觉问题的视角,我的目标是开发适用于各个领域的通用方法。我目前的研究重点是构建可以学习复杂世界表示的计算机模型,并探索面向复杂世界的智能。我研究的长期目标是通过更强大的人工智能来增强人类智能。”

据悉,何恺明加入MIT后会立刻成为该校论文引用量最高的学者。

附:何恺明个人网站的声明全文

我将于2024年加入麻省理工学院(MIT)电气工程与计算机科学系(EECS),担任教职。我目前是Facebook AI Research(FAIR)的研究科学家。

我的研究涵盖了计算机视觉和深度学习的广泛主题。通过计算机视觉问题的视角,我的目标是开发适用于各个领域的通用方法。我目前的研究重点是构建可以学习复杂世界表示的计算机模型,并探索面向复杂世界的智能。我研究的长期目标是通过更强大的人工智能来增强人类智能。

我在计算机视觉和深度学习领域发表了一系列极具影响力的论文。我关于深度残差网络(ResNets)的论文是2019年、2020年和2021年Google Scholar Metrics所有研究领域中被引用最多的论文,并建立了现代深度学习模型的基本组成部分(例如,在Transformers、AlphaGo Zero、AlphaFold中)。我在视觉目标检测方面的工作,包括Faster R-CNN和Mask R-CNN,产生了重大影响,是这些领域被引用最多的论文之一。我在视觉自监督学习方面的作品是CVPR 2020年、2021年和2022年发表的被引次数最多的论文。我的论文有超过46万次引用(截至2023年7月),每年增加超过10万次。

我是领域中几个著名奖项的获得者,包括2018年PAMI青年研究员奖,CVPR 2009年最佳论文奖,CVPR 2016年,ICCV 2017年,ICCV 2017年最佳学生论文奖,ECCV 2018年最佳论文荣誉奖,CVPR 2021年,以及ICCV 2021年的最佳论文奖。

在2016年加入FAIR之前,我曾于2011年至2016年在微软亚洲研究院(MSRA)担任研究员。2011年在香港中文大学获得博士学位,2007年在清华大学获得学士学位。

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

热门文章

新火种

2023-10-28

新火种

2023-10-28