耳听眼见≠实!AI催生诈骗更复杂:7成受访大学生恐慌AI诈骗

伴随生成式AI的迅猛发展,普通人应用的门槛越来越低:10秒就能克隆声音,复刻你的照片,甚至能生成“你”的视频。这为新型的诈骗提供了技术土壤,AI诈骗成为社会关注热点。

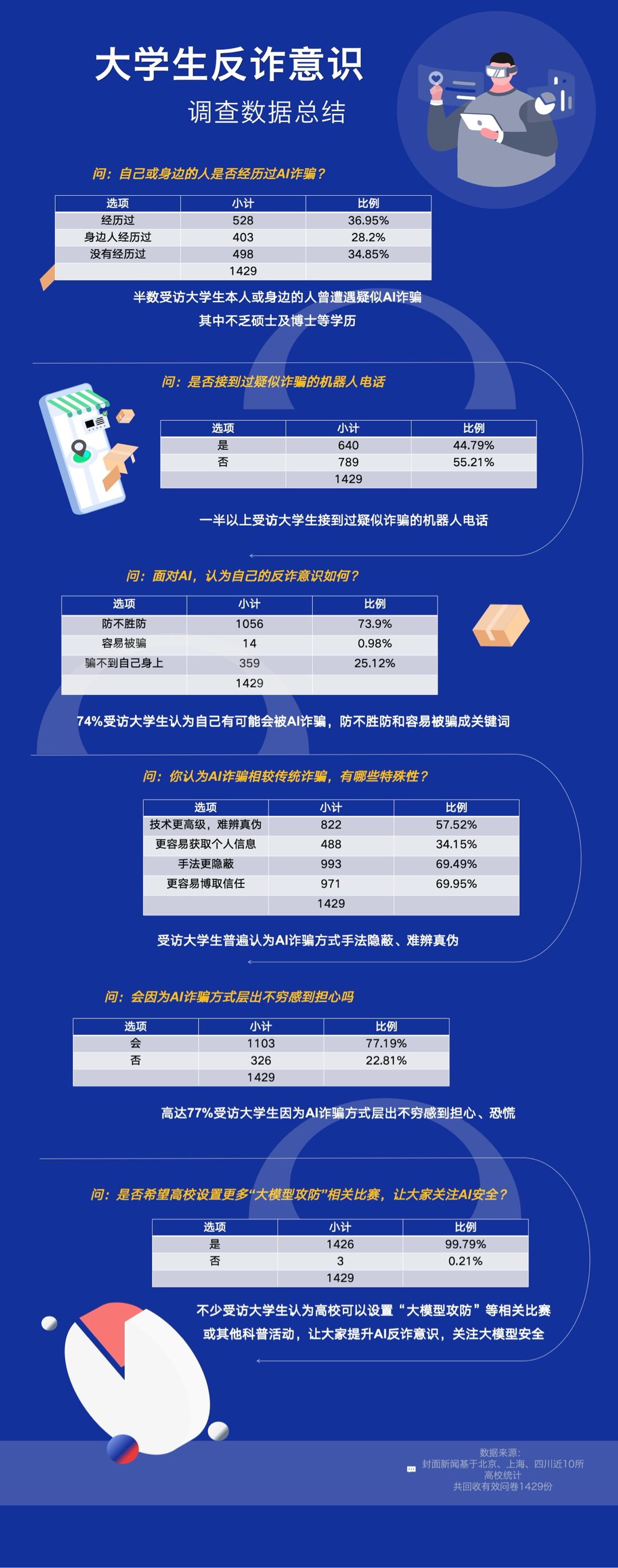

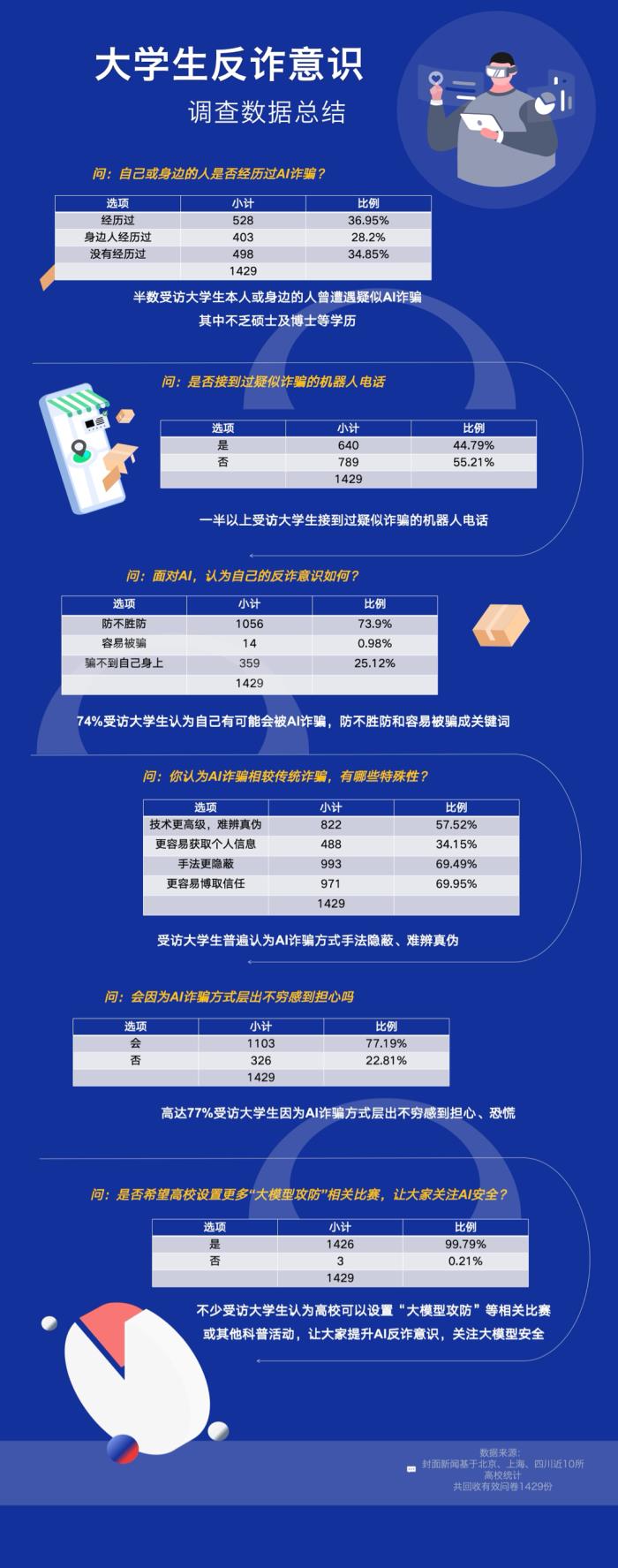

日前,一项由封面新闻发起的大学生调研,在回收的近1500份有效调查问卷中,半数受访大学生本人或身边的人曾遭遇疑似AI诈骗,7成大学生对AI诈骗感到恐慌,表示自己会被AI诈骗。调研结果显示,不少受访大学生认为高校可以设置AI课程、大模型攻防比赛等科普教育活动,让大家提升AI反诈意识。

由于大模型在与用户交互过程中,涉及大量个人信息和数据,AI诈骗的背后关乎着用户隐私,业内专家呼吁应提高自身安全意识、保护个人信息安全,同时业界共同关注大模型安全刻不容缓。

该调查样本选取了四川、北京、上海等地近10所大学的1500名大学生。数据显示,半数的受访大学生本人或身边的人曾遭遇疑似AI诈骗,不乏硕士及博士等学历的学生。诈骗形式最多的是电话,同时也包括AI换脸、AI音频伪造、视频造假、AI投资顾问骗局等,其中一半以上受访大学生,表示接到过疑似诈骗的机器人电话。高达77%的受访大学生会因为AI诈骗方式层出不穷感到恐慌。

在媒体实地走访高校过程中,不少大学生表示,对于当下的AI诈骗手段,自己没有绝对把握识别骗局;对于媒体展示的某著名企业家的AI合成音频,近8成大学生无法分辨是真人还是AI制作。不少大学生表达了他们的担心,如若父母辈遭遇诈骗,后果不堪设想。

AI诈骗相比传统诈骗,技术手段更高级、诈骗手段更隐蔽,也更容易引起信任。此外,有74%的受访大学生认为自己有可能会被AI诈骗,防不胜防和容易被骗成为他们在形容自己AI诈骗意识时候的关键词。

不少受访大学生认为高校可以设置大模型攻防等相关比赛或其他科普活动,让大家提升AI反诈意识,关注大模型安全。

“当下AI诈骗主要分为语音诈骗、文本诈骗、视频诈骗等几种类型。AI拟音、换脸,是基于真人信息,这也意味着AI诈骗背后是用户隐私的泄漏。”

蚂蚁集团安全实验室首席科学家、全球AI大模型攻防挑战赛评审委员会委员王维强在接受采访时指出,保护大模型与保障用户隐私紧密相连。大模型在与用户交互的过程中,不可避免地会涉及大量的个人信息和数据,一旦存在各种漏洞和缺陷,极有可能引发严重后果。只有切实保障大模型安全,才能为用户的合法权益筑起坚固的防护墙。“安全,是大模型技术持续发展的坚实地基。”王维强总结。

如何守护大模型安全?王维强建议,不能仅仅依赖技术手段,还需要加强安全规范和安全意识。只有当技术、规范和意识三者协同发力,我们才能真正守护好大模型的安全,为其持续健康发展创造良好的条件。

基于此,由中国图象图形学学会、蚂蚁集团、云安全联盟(CSA)大中华区联合主办,联合清华大学、上海交通大学、浙江大学等高校及多家产学研组织共同发起的,国内首个AI大模型攻防挑战赛,通过大模型技术攻防实战演练,助力AI反诈,保护大模型安全。

王维强介绍,大赛的举办,第一可以寻找优秀技术方案,为选手们提供相互交流的平台,第二是可以遴选优秀人才,为行业的未来发展储备智力资源。据了解,赛事启动至今,吸引了全球范围内2700多个赛队、3200余名技术精英参与,覆盖中国、美国、英国、印度、韩国等18个国家和地区。参赛选手分别来自清华大学、北京大学、中国科学院、上海交通大学、南洋理工大学、约翰霍普金斯大学、香港科技大学、悉尼大学等290多个国内外高校。该赛事将在乌镇世界互联网大会公布其全球十强。

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2024-11-21

新火种

2024-11-21