苹果芯跑大模型不用降计算精度,投机采样杀疯了,GPT-4也在用

声明:本文来自于

专攻代码的Code Llama一出,大家伙都盼着谁来后续量化瘦身一下,好在本地也能运行。

果然是llama.cpp作者Georgi Gerganov出手了,但他这回不按套路出牌:

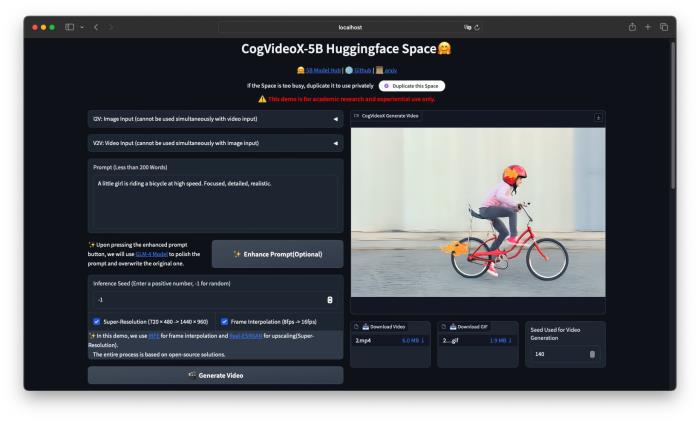

不量化,就用FP16精度也让34B的Code LLama跑在苹果电脑上,推理速度超过每秒20个token。

Tags:

相关推荐

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2023-10-05

新火种

2023-10-05