新开源之王来了!1320亿参数,还比Llama2-70B快1倍

“最强”开源大模型之争,又有新王入局:

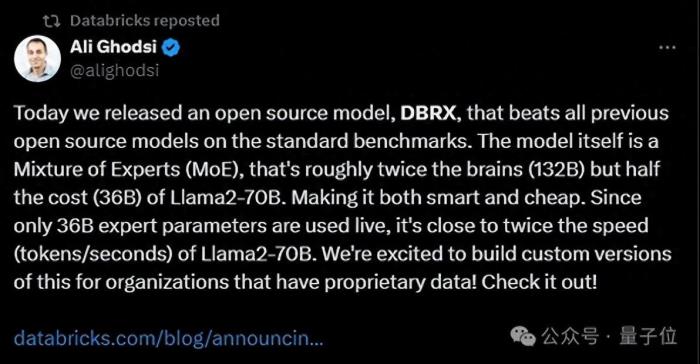

大数据巨头Databricks,刚刚发布MoE大模型DBRX,并宣称:

包括同为混合专家模型的Grok-1和Mixtral。

新王搅局,迅速引发了开源社区的热议。

毕竟,仅从纸面数据来看,DBRX颇具特点:总参数量为1320亿,但因为是混合专家模型,每次激活参数量仅为360亿。

就是说,在总参数量接近Llama2-70B的2倍的情况下,DBRX的生成速度也比Llama2-70B快1倍。

△DBRX vs Llama2-70B

另外,DBRX是在12T token上从头训练的,训练数据量是Llama2的6倍,远高于Chinchilla定律推荐量。

网友们的第一反应be like:

首席科学家:打赌输了就把头发染蓝

来看DBRX的具体细节。

DBRX由16个专家模型组成,每次训练推理会有4个专家处于激活状态。其上下文长度为32K。

为了训练DBRX,Databricks团队从云厂商那里租用了3072个H100。

一个细节是,团队向Wired透露,经过两个月的训练之后,DBRX已经在基准测试中取得了不错的分数。而在那个时候,他们买的云资源还能再跑一个星期。

团队因此产生了小小的分歧:是用这些资源来训练一个小杯版本,还是再投喂给模型一些高质量数据,用课程学习(curriculum learning)的方法来提高DBRX在一些特定任务上的能力?

经过一番热烈的内部讨论,Databricks团队最终决定走课程学习路线。

正是这一决策使他们收获颇丰:

Databricks首席科学家Jonathan Frankle(就叫他老弗吧)认为,课程学习使得DBRX“产生了有意义的变化”。

具象化一点来说,就是老弗本来觉得DBRX可能搞不太定代码生成,还打赌说如果他判断错了,就去把头发染成蓝色。

而这是他的最新照片:

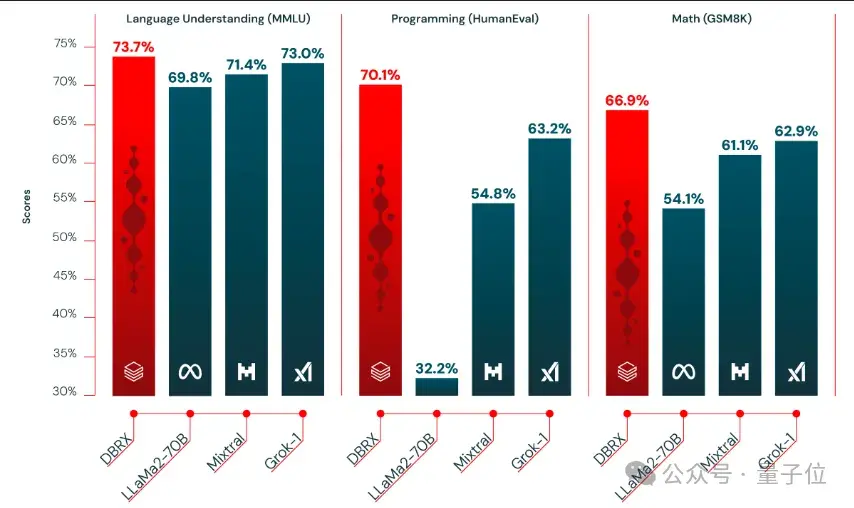

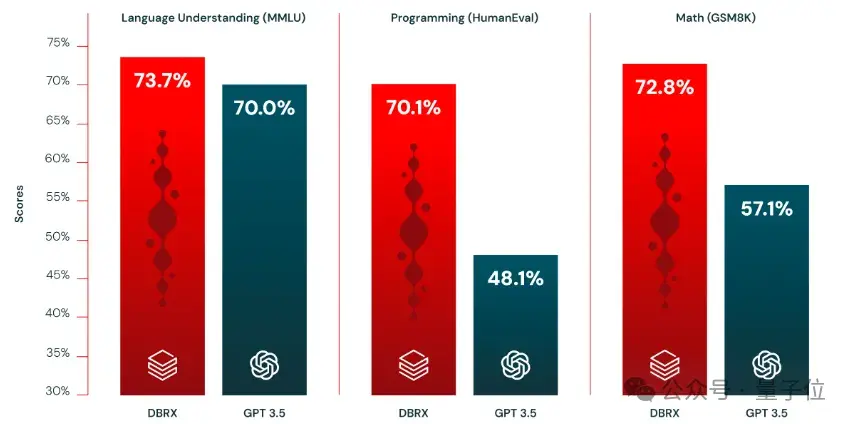

回到正题,DBRX的测试结果显示,它在语言理解、编程、数学和逻辑方面都达到了SOTA,击败包括Llama2-70B、Mixtral和Grok-1在内的一众开源大模型。

还在大多数基准测试中都击败了GPT-3.5。

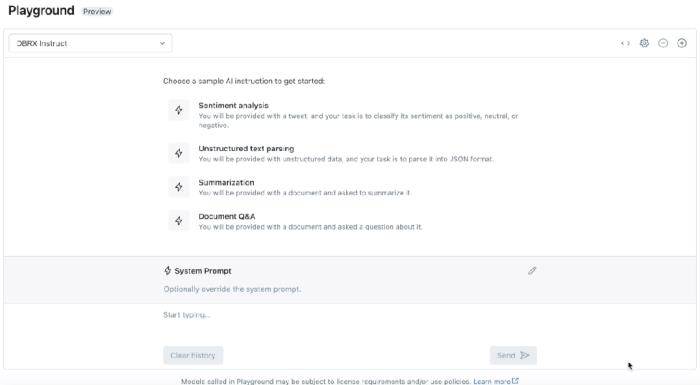

Databricks这次开源了DBRX的两个版本:DBRX Base和DBRX Instruct,前者是预训练基础模型,后者则经过指令微调。

老弗还对Wired透露,他们团队接下来计划对模型训练的那个“最后一周”展开研究,看看DBRX这样强大的模型是如何在其中收获额外技能的。

值得一提的是,去年6月,Databricks以13亿美元(约93亿人民币)的价格,买下了仅62名员工的AI初创公司MosaicML——

就是发布了MPT系列开源模型的那家。

老弗当时就是MosaicML的首席科学家。此后,他和他的团队一起留在了Databricks。

开源社区嗨翻

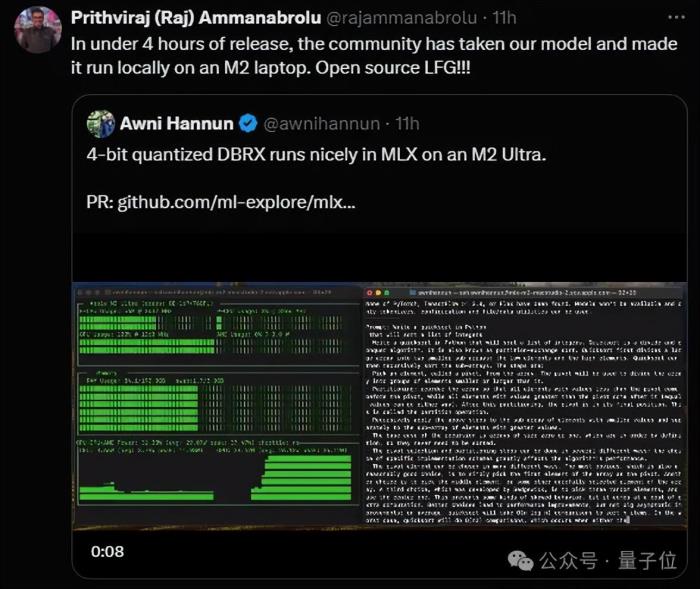

DBRX发布不到4小时,已经有人把它成功部署到苹果M2芯片笔记本电脑上了。

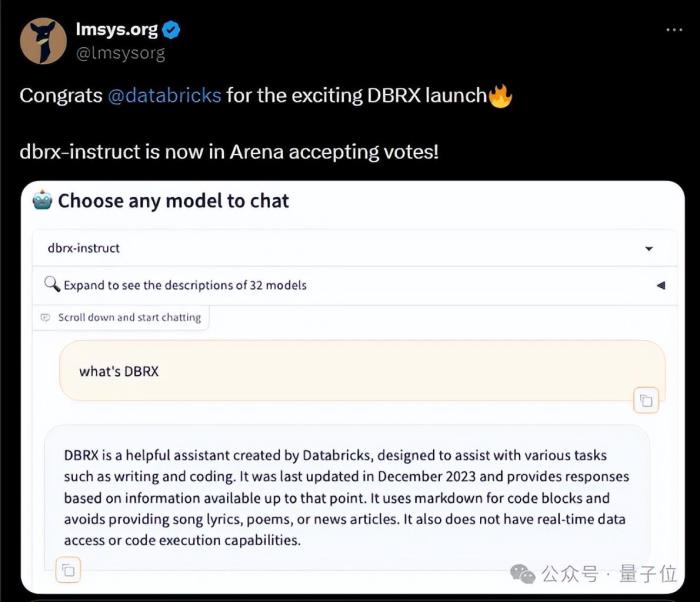

而大模型竞技场也第一时间开放了DBRX-instruct的投票。

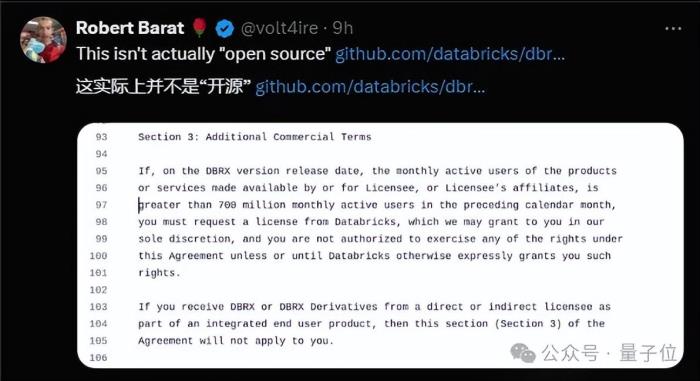

不过,也有人对DBRX的“开源”提出了质疑:

根据Databricks公布的协议,基于DBRX打造的产品,如果月活超过7亿,就必须另行向Databricks提交申请。

— 完 —

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

热门文章

新火种

2024-03-29

新火种

2024-03-29