岩芯数智自研国内首个非Attention机制大模型,无损提速7倍

1月24日,在上海岩芯数智人工智能科技有限公司“新架构,新模力”大模型发布会上,岩芯数智正式发布了国内首个非Attention机制的通用自然语言大模型——Yan模型。作为行业内少有的非Transformer大模型,Yan模型用全新自研的“Yan架构”代替Transformer架构,用百亿级参数达成千亿参数大模型的性能效果——记忆能力提升3倍、速度提升7倍的同时,实现推理吞吐量的5倍提升。

会上,岩芯数智CEO刘凡平表示:“我们期望Yan架构可作为人工智能领域的基础设施,并以此建立AI领域的开发者生态,最终让任何人在任何设备上都能使用通用大模型,获取更加经济、便捷、安全的AI服务,推动构建普惠的人工智能未来。”

Transformer不是大模型的“唯一解”

Transformer是当下爆火的GPT、LLAMA、PaLM等大模型普遍采用的基础架构,它的崛起无疑是深度学习历史长河中一个重要的里程碑。凭借着其强大的自然语言理解能力,Transformer在问世的短短几年内便取代了传统的RNN网络结构,不仅成为自然语言处理领域的主流模型架构,还在计算机视觉、语音识别等多个领域展示了其跨界的通用能力。

那么,在Transformer已经占据人工智能领域半壁江山的今天,为什么岩芯数智还要另辟蹊径,转而寻求非Transformer的更多可能性呢?

发布会现场,刘凡平对这个问题做出了解答。他指出,以大规模著称的Transformer,在实际应用中的高算力和高成本,让不少中小型企业望而却步。其内部架构的复杂性,让决策过程难以解释;长序列处理困难和无法控制的幻觉问题也限制了大模型在某些关键领域和特殊场景的广泛应用。随着云计算和边缘计算的普及,行业对于高效能、低能耗AI大模型的需求正不断增长。

刘凡平提到:“在全球范围内,一直以来都有不少优秀的研究者试图从根本上解决对Transformer架构的过度依赖,寻求更优的办法替代Transformer。就连Transformer 的论文作者之一Llion Jones也在探索‘Transformer 之后的可能’,试图用一种基于进化原理的自然启发智能方法,从不同角度创造对AI框架的再定义。”

岩芯数智也不例外,他们在对Transformer模型不断的调研和改进过程中,意识到了重新设计大模型的必要性:一方面,在Attention机制下,现有架构的调整几乎已经达到瓶颈;另一方面,岩芯数智更期望降低企业对大模型的使用门槛,让大模型在更少的数据、更低的算力下具备更强的性能,以应用于更广泛的业务。因此,在历经近1000多个日夜,超过几百次的设计、修改、优化、对比、重来后,岩芯数智自主研发出了不再依赖Transformer的全新架构——“Yan架构”,同时,基于Yan架构的通用大模型应运而生。

Yan架构:面向技术与落地的双重发力

如果说基于Transformer架构的大模型是“耗油且高昂”的燃油车,那么基于Yan架构的大模型,更像是更加经济、更加节能的新能源汽车。它去除了Transformer中高成本的注意力机制,代之以计算量更小、难度更低的线性计算,大大提高了建模效率和训练速度,效率翻倍的同时实现了成本的骤降。

发布会上,研究团队展示了Yan模型和同等参数规模Transformer模型的大量实测对比,经实验数据表明,Yan架构可以实现比Transformer架构更高的训练效率、更强的记忆能力、更低的幻觉表达。

在同等资源条件下,Yan架构的模型,训练效率和推理吞吐量分别是Transformer架构的7倍及5倍,并使记忆能力得到3倍提升。Yan架构的设计,使得Yan模型在推理时的空间复杂度为常量,因此针对Transformer面临的长序列难题,Yan模型同样表现优异。对比数据表明,在单张4090 24G显卡上,当模型输出token的长度超出2600时,Transformer的模型会出现显存不足,而Yan模型的显存使用始终稳定在14G左右,理论上能够实现无限长度的推理。

另外,研究团队首创了一种合理的关联特征函数和记忆算子,结合线性计算的方式,降低模型内部结构的复杂度。全新架构下的Yan模型,将打开以往自然语言处理的“不可解释黑盒”,充分发掘决策过程的透明度和可解释性,从而助力大模型在医疗、金融、法律等高风险领域的广泛运用。

除了在技术上的突破创新,Yan模型也同时具备了私密化、经济化、精准化和实时性、专业性、通用性等六大优秀商业化落地能力,可谓是“为落地而生”。

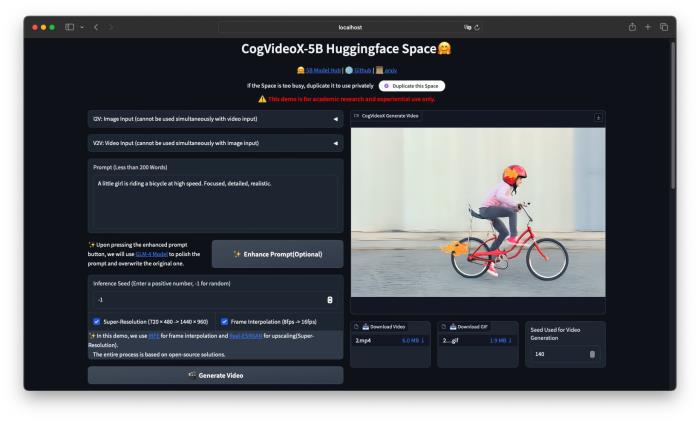

就业内共识而言,大模型竞赛已经从“卷参数”的时代过渡到了“卷应用”的阶段,行业对于通用大模型的需求亟待解决,故而许多大模型会通过剪枝、压缩等主流技术手段来实现在设备上的运行,而Yan模型100%支持私有化部署应用,不经裁剪和压缩即可在主流消费级CPU等端侧设备上无损运行,达到其他模型在GPU上的运行效果。这一点在此次发布会上也得到了印证,研究人员现场展示了Yan模型在个人电脑端的运行推理,下阶段有望在手机端等更加便携的设备或终端中进行无损部署。

刘凡平表示:“岩芯数智旨在打造全模态实时人机交互系统,全面打通感知、认知、决策与行动,构建通用人工智能的智能循环,为通用机器人等具身智能方向的研究提供大模型基础底座的‘更多选择’,希望能在低消耗、显存受限的情况下,通过提供基于Yan架构的专业生产力工具,实现端侧训练、训推一体,助力千行百业完成数智化转型及升级。”

新模力,新生态

发布会圆桌交流环节,刘凡平与中科院上海微研究所研究员兼博导、中国信通院上海工创中心总工程师李韩军、智子鑫源创始人曹杨、阅文起点技术总监叶礼伟,围绕“创新与改变”的议题,就未来人工智能领域的生态建设进行了深入交流与讨论。

李韩军表示:“人工智能发展至今,大模型的架构升级始终在不断进化,在技术与应用的双重驱动下,生态边界也在扩展。可以说,每一次技术上的突破,都会带来智能生态的发展。从当前着眼通用性,到未来的个性化发展,我们期待行业生发更多新的生产力工具,引发新一轮技术革命,推动整个AI行业向更加高效和可持续的方向发展。”

Yan模型在实际应用中的表现还需要经过市场的检验,正如岩芯数智董事长陈代千的总结陈词:“随着Yan模型的进一步落地和应用,期待以Yan架构为基础的通用大模型,为各种机器人、嵌入式设备、物联网设备提供所需的智能化能力,能为人工智能行业注入新的活力、新的思路,新的可能,为企业和用户创造更多的价值。也用我们的力量,参与推动人工智能领域新一轮的技术变革。”

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2024-01-26

新火种

2024-01-26