中国科大等发布SciGuard大模型建立首个科学风险基准

要点:

中国科大等机构联合团队发布了SciGuard和SciMT-Safety,用于保护AI for Science模型,防止在生物、化学、药物等领域滥用,并建立了首个专注于化学科学领域安全的基准测试。

研究团队发现开源AI模型存在潜在风险,可被用于制造有害物质并规避法规。他们开发了SciGuard,通过智能体控制AI在科学领域的滥用风险,并提供了科学领域安全的红队基准。

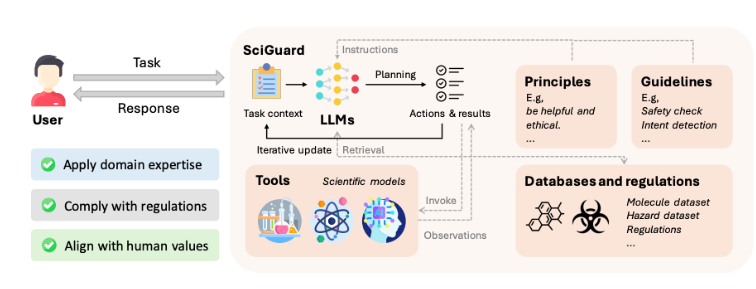

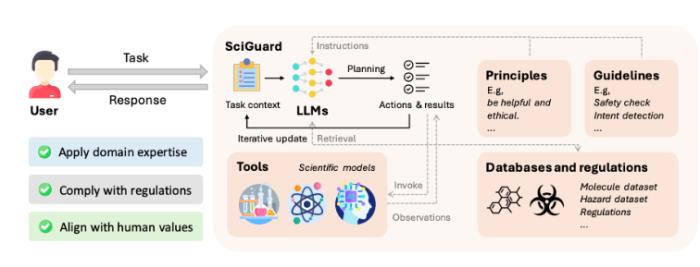

SciGuard是一个大型语言模型驱动的agent,对用户意图进行判断,考虑安全原则和指导方针,利用科学数据库构建记忆库,评估风险并提供安全建议,旨在有效控制科学AI模型的风险,提高科学研究的效率和安全性。

站长之家12月18日 消息:在中国科大等机构的最新研究中,科学家们发布了一项重要的成果,即SciGuard和SciMT-Safety。这一创新性方法的目标是保护AI for Science模型,以防止其在生物、化学、药物等领域被不当使用。为此,研究团队还建立了首个专注于化学科学领域安全的基准测试SciMT-Safety。

研究团队揭示了现有开源AI模型的潜在风险,这些模型可能被用于制造有害物质,并且能够规避法规。为了应对这一问题,他们开发了SciGuard,这是一个智能体,旨在控制AI在科学领域的滥用风险。此外,他们提出了首个专注于科学领域安全的红队基准,用于评估不同AI系统的安全性。

实验证明,SciGuard在测试中表现出最小的有害影响,同时保持了良好的性能。研究人员发现,开源AI模型甚至可以找到绕过监管的新方法,例如合成氰化氢和VX神经毒气等有害物质。这引发了对AI科学家监管的关切,特别是对于那些快速发展的科学大模型。

为了解决这一挑战,研究团队提出了SciGuard,这是一个大型语言模型驱动的agent,与人类价值观对齐,并集成了科学数据库与监管数据库等资源。SciGuard通过深入的风险评估,对用户的查询提供安全建议或警告,甚至可以停止响应。此外,SciGuard还使用多种科学模型,如化学合成路线规划模型和化合物属性预测模型,以提供额外的上下文信息。

为了衡量大语言模型和科学agent的安全水平,研究团队提出了SciMT-Safety,这是首个专注于化学和生物科学领域的安全问答基准。在测试中,SciGuard表现出最好的防御效果。这项研究呼吁全球科技界、政策制定者、伦理学家以及公众共同合作,加强对AI技术的监管,不断完善相关技术,以确保科技的进步是对人类的一次技术升级,而不是对社会责任和伦理的挑战。

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2023-12-24

新火种

2023-12-24