一文帮您了解生成对抗网络(GAN)的概念和原理

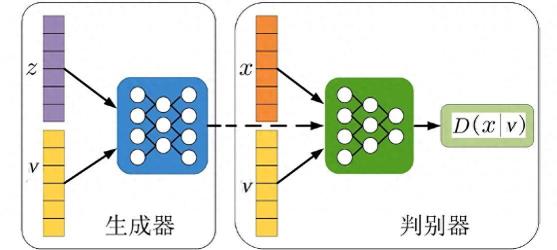

生成对抗网络(GAN)是一种深度学习模型,它可以通过两个神经网络的相互博弈来学习生成数据。GAN由一个生成器(Generator)和一个判别器(Discriminator)组成。生成器的目标是从一个随机噪声向量生成类似于真实数据的样本,比如图片、文本或音频。判别器的目标是区分输入的数据是真实的还是生成器生成的。通过不断地更新生成器和判别器的参数,GAN可以逐渐提高生成数据的质量和真实性。

GAN的原理是:判别器要最大化自己对真实数据和生成数据的正确判断概率,生成器要最小化判别器对生成数据的正确判断概率,也就是最大化判别器对生成数据的错误判断概率。这样,生成器和判别器就形成了一个零和博弈的过程,最终达到一个纳什均衡点,即生成器生成的数据和真实数据无法被判别器区分。

GAN的算法流程可以用以下的伪代码来描述:

# 初始化生成器G和判别器D的参数theta_g = initialize_parameters_for_G()theta_d = initialize_parameters_for_D()# 迭代训练for i in range(num_iterations): # 固定生成器G,更新判别器D的参数 for k in range(num_steps): # 一般取k=1 # 从真实数据分布中采样m个样本x x = sample_from_data_distribution(m) # 从噪声分布中采样m个样本z z = sample_from_noise_distribution(m) # 用生成器G生成m个样本G(z) g_z = G(z, theta_g) # 计算判别器D对真实数据和生成数据的输出概率 d_x = D(x, theta_d) d_g_z = D(g_z, theta_d) # 计算判别器D的损失函数 loss_d = - (log(d_x) + log(1 - d_g_z)) # 根据损失函数对判别器D的参数进行梯度下降更新 theta_d = theta_d - learning_rate * gradient(loss_d, theta_d) # 固定判别器D,更新生成器G的参数 # 从噪声分布中采样m个样本z z = sample_from_noise_distribution(m) # 用生成器G生成m个样本G(z) g_z = G(z, theta_g) # 计算判别器D对生成数据的输出概率 d_g_z = D(g_z, theta_d) # 计算生成器G的损失函数 loss_g = - log(d_g_z) # 根据损失函数对生成器G的参数进行梯度下降更新 theta_g = theta_g - learning_rate * gradient(loss_g, theta_g)

相关推荐

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2023-12-26

新火种

2023-12-26