叶华山博士深度解析:深度学习如何模拟与掌握复杂特征模式

叶华山博士近日详细介绍了深度学习,这是机器学习领域中的一个重要分支。它主要是基于人工神经网络的概念,借助多层次的神经网络结构来模拟和学习各种复杂的特征和模式。

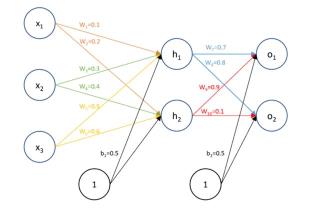

深度学习的核心在于人工神经网络(ANN),这一结构主要由输入层、隐藏层和输出层等多个层次组成。每个神经元,或被称为节点,都会与下一层中的每一个神经元进行连接,同时配有一个权重。这些权重会在训练过程中被不断地调整。

叶博士解释说,深度学习的工作机制始于前向传播。在这一过程中,输入数据会从输入层开始,经过一系列的神经元层进行处理。每一层都会通过加权求和和激活函数的方式对数据进行处理,最终得到输出结果。这个过程其实就是一个将输入数据映射到输出数据的过程,其中还包括了特征提取和非线性变换。

深度学习中的激活函数是神经元中的一个重要部分,它是一种非线性函数,可以为神经元引入非线性特性,从而让神经网络有能力学习更为复杂的模式和特征。目前比较常用的激活函数包括Sigmoid、ReLU(Rectified Linear Unit)和Tanh等。

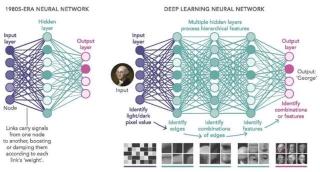

在深度学习中,反向传播算法是训练神经网络的核心。这一算法主要是利用梯度下降法来更新神经元之间的连接权重,以确保神经网络的输出能够尽可能接近目标值。通过计算损失函数的梯度,可以反向传播误差,并据此调整权重,从而持续提高网络的性能。深度学习之所以被冠以“深度”二字,主要是因为它通常都会包含多个隐藏层,这些隐藏层可以学习不同级别的特征和抽象概念,而多层结构也让深度网络具有更强的能力来捕捉数据中的复杂关系。

据叶华山博士介绍,深度学习具有出色的自动特征学习能力,它可以从数据中自动学习到有用的特征,而无需人们手动设计和调整特征提取器。这一特性使得深度学习在许多领域都展现出了强大的实力,尤其是在计算机视觉、自然语言处理和语音识别等任务中表现得尤为突出。

叶博士总结说,深度学习之所以能够在众多领域取得如此显著的成功,主要得益于大规模数据和强大计算资源的支持。目前,借助大规模的数据集和分布式计算技术,深度学习可以更为高效地训练大型的神经网络。其背后的原理和工作机制则主要涉及到了神经网络的层次结构、前向传播、反向传播以及权重调整等多个方面。随着技术的不断进步和发展,深度学习有望在更多的领域中实现更为广泛的应用,为人们的生活带来更多的便利和惊喜。

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2023-12-06

新火种

2023-12-06