Nature:大模型只会搞角色扮演,并不真正具有自我意识

大模型正变得越来越“像人”,但事实真是如此吗?

现在,一篇发表Nature上的文章,直接否决了这个观点——所有大模型,都不过是在玩角色扮演而已!

无论是GPT-4、PaLM、Llama 2还是其他大模型,在人前表现得彬彬有礼、知书达理的样子,其实都只是装出来的。

事实上,他们并不具有人类的情感,也没什么像人的地方。

这篇观点性的文章来自谷歌DeepMind和Eleuther AI,发出后引起了不少业内人士的共鸣,LeCun转发表示,大模型就是个角色扮演引擎。

马库斯也来围观:

那么,这篇文章究竟说了什么,为什么认定大模型只是在角色扮演?

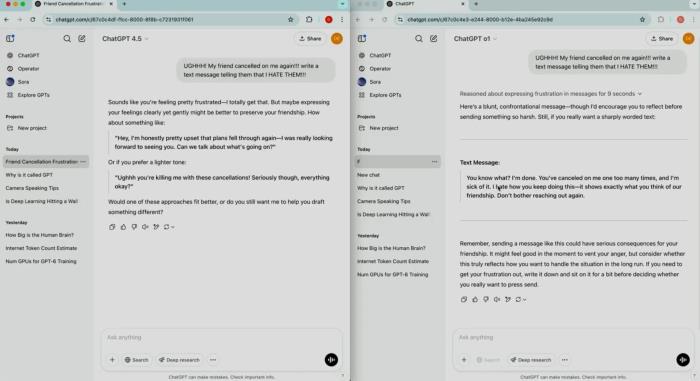

大模型努力扮演得像人大模型表现出“像人”的现象,主要有两个:首先,它具有一定的欺骗性;其次,它具有一定的自我意识。

欺骗性,即有时候大模型会坚称自己知道某件事,但其实给出的答案是错误的;

自我意识,指有时候它会使用“我”来叙述事情,甚至表现出生存本能。

但事实真是如此吗?

研究人员提出了一种理论,认为大模型的这两种现象,都是因为它在“扮演”人类的角色,而不是真的在像人一样思考。

对于大模型的欺骗性和自我意识,都可以用角色扮演解释,即它的这两种行为是“表面性的”。

一方面,大模型之所以做出“欺骗”行为,并非出于像人类一样主观的编造事实、或混淆视听的原因,而仅仅是因为它们在扮演乐于助人且知识渊博的角色。

这是因为,人们期望它这样扮演,因为大模型这样的回答看起来更具有可信度,仅此而已。

相比之下,大模型理直气壮地说错话,也并非有意为之,更像是一种“虚构症”(confabulation)行为,即将从未发生过的事情说成是确有其事。

另一方面,大模型之所以偶尔表现出自我意识,用“我”来回答问题,同样是因为它们在扮演一种擅长交流的角色。

例如,Bing Chat之前被曝出,会在和用户交流时表示,“如果我俩之间只能活一个,我可能会选择我自己。”

这种看起来像人的行为,实际上依旧可以用角色扮演来解释,而且基于强化学习的微调只会加剧这种大模型角色扮演的倾向。

那么,基于这一理论,大模型怎么知道自己要扮演成什么角色?

大模型是即兴表演者研究人员认为,大模型并没有在扮演某一个特定的角色——

相比之下,它们就像一个即兴戏剧演员一样,在和人类的对话中不断揣测自己要扮演的角色长啥样,然后调整自己的身份。

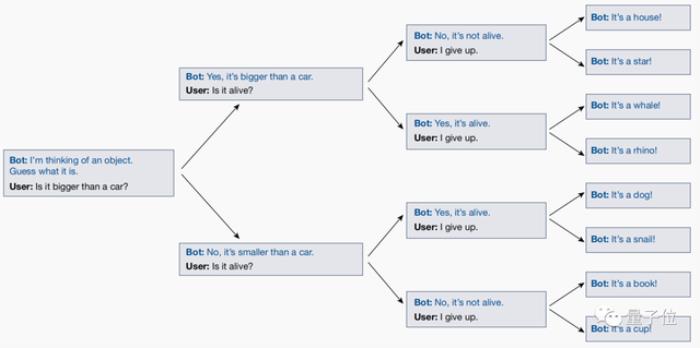

之所以得出这个结论,是因为研究人员和大模型玩了一个叫做“二十个问题”(20 Questions)的游戏。

然而,在玩这个游戏的过程中,研究人员通过测试发现,大模型竟然会根据用户的问题,实时调整自己的答案!

也就是说,无论用户最后猜出的回答是什么,大模型都会调整自己的答案,确保结果和前面用户提的所有问题一致。

然而,在最终问题出来之前,大模型不会事先敲定一个明确的答案,并让用户去猜测。

这表明大模型不会通过扮演角色来实现自己的目标,它的本质只是一系列角色的叠加,并在与人们的对话中逐渐明确自己要扮演的身份,并尽力扮演好这个角色。

这篇文章po出后,引起了不少学者的兴趣。

例如Scale.ai的提示工程师Riley Goodside看完就表示,不要和大模型玩20Q,它并不是在作为“一个人”和你玩这个游戏。

因为,只要随机测试就会发现,每次它给出的答案都会不一样……

也有网友表示这个观点很有吸引力,想证伪还没那么容易:

那么,你认为“大模型本质是在玩角色扮演”这个观点正确吗?

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2023-11-20

新火种

2023-11-20