北大新成果:无需训练,机器人听指令就能灵活走位

要点:

1. 北大研究团队开发了一种具身导航系统,使机器人可以根据口头指令在室内环境中移动,无需额外训练或建图。

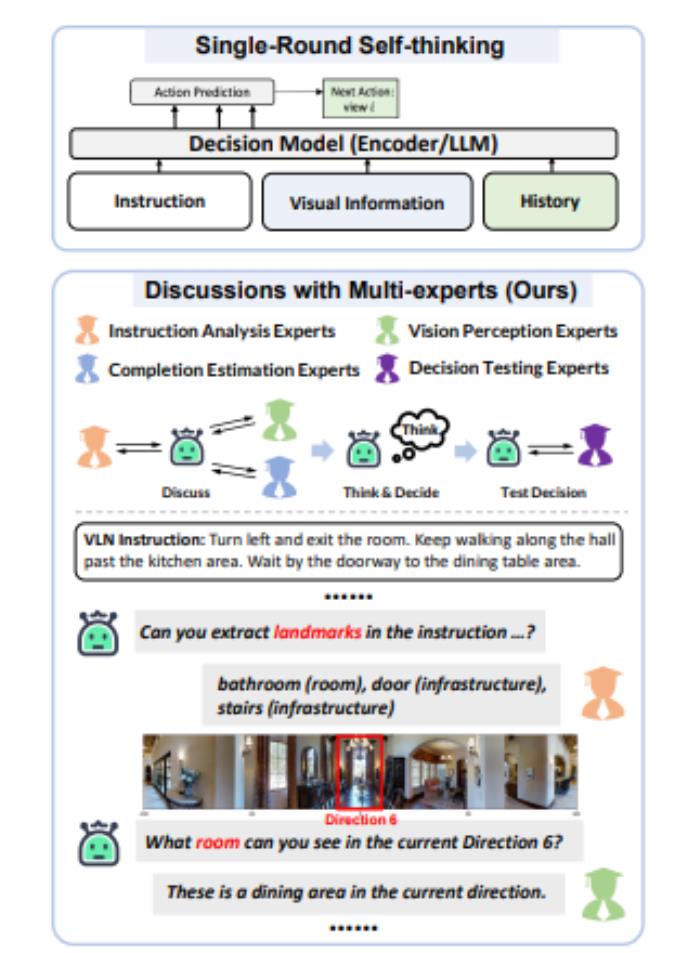

2. 这一系统涉及多个关键任务,包括指令分析、视觉感知、完成估计和决策测试,由大模型专家团队协同完成。

3. DiscussNav系统通过与大模型专家互动,使机器人能够根据人类指令移动,解决了机器人导航训练数据稀缺的问题,同时具备零样本能力,能够执行多样的导航指令。

站长之家11月6日 消息:北大的研究团队近期推出了一项具身导航系统,可使机器人无需额外训练或建图,仅通过口头指令在室内环境中自如移动。这一系统包括指令分析、视觉感知、完成估计和决策测试等多个关键任务,需要不同领域的知识,这些任务由一个大模型专家团队协同完成。

作者启发于现实中专家讨论行为,设计了DiscussNav导航系统,通过赋予大语言模型(LLM)和多模态大模型(MLM)专家角色和任务,构建了具备不同专长的视觉导航专家团队。

论文地址:https://arxiv.org/pdf/2309.11382.pdf

在这一系统中,导航机器人会在每一步移动前主动与专家讨论,以理解人类指令中所需的动作和提及的物体标志。然后,它会根据这些物体标志类型倾向性地感知周围环境,估计指令的完成情况,并做出初步的移动决策。

值得注意的是,在决策过程中,机器人会同时生成多个独立的预测结果,并在这些结果之间出现不一致时,向决策测试专家求助,以筛选出最终的移动决策。这一方法不同于传统方法,无需额外预训练,通过与大模型专家的互动,直接解决了机器人导航训练数据稀缺的问题,并具备零样本能力。

DiscussNav系统在经典的视觉语言导航数据集Room2Room上的表现显著超越了所有零样本方法,甚至胜过了经过训练的方法。

研究团队还在Turtlebot4移动机器人上进行了真实室内场景导航实验,结果表明,该系统在真实世界中的表现明显优于之前最优的零样本方法和经过预训练微调的方法,展现出良好的从模拟环境到真实环境的迁移能力。

作者指出,这一系统具备四个强大的能力,包括识别开放世界物体、识别细粒度的导航标志物体、纠正其他专家在讨论中的错误信息,以及排除不一致的移动决策。

此外,作者还提出,深入研究如何有效利用仿真数据和大模型从海量数据中学到的先验知识是未来具身智能研究的发展方向。尽管受到数据规模和真实环境探索成本的限制,但大模型的进展为具身智能提供了新方向,将推动其发展。

在总体上,北大的DiscussNav系统代表了具身导航领域的一项重要突破,使机器人能够根据口头指令自如导航,同时具备零样本能力,这对未来的智能机器人和自动化应用具有重要意义。

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2023-11-11

新火种

2023-11-11