蚂蚁集团发布DevOps领域大模型评测基准DevOps-Eval

站长之家 11月2日 消息:蚂蚁集团联合北京大学发布了面向 DevOps 领域的大语言模型评测基准 ——DevOps-Eval。

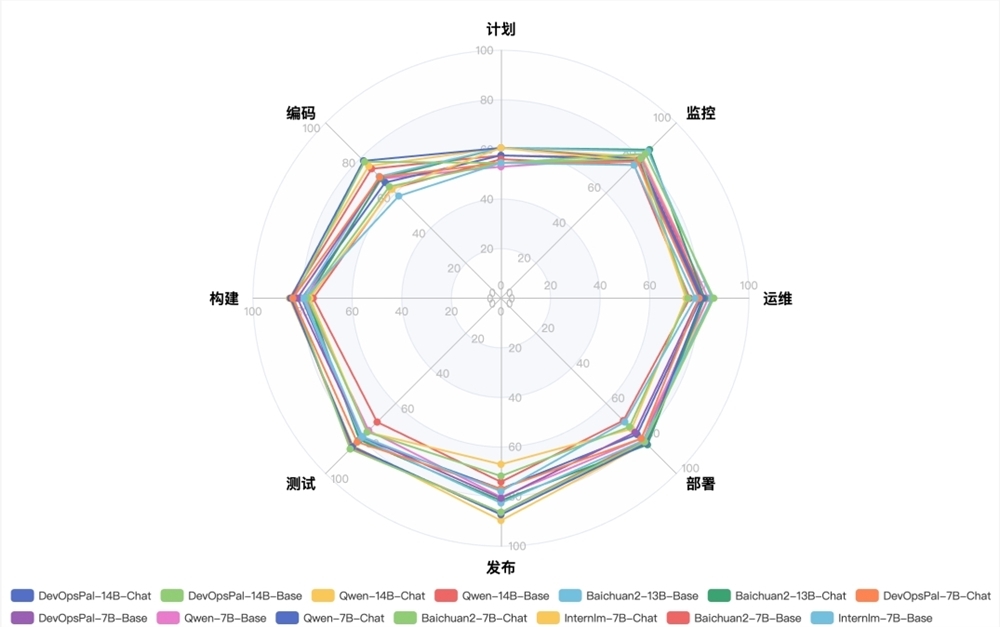

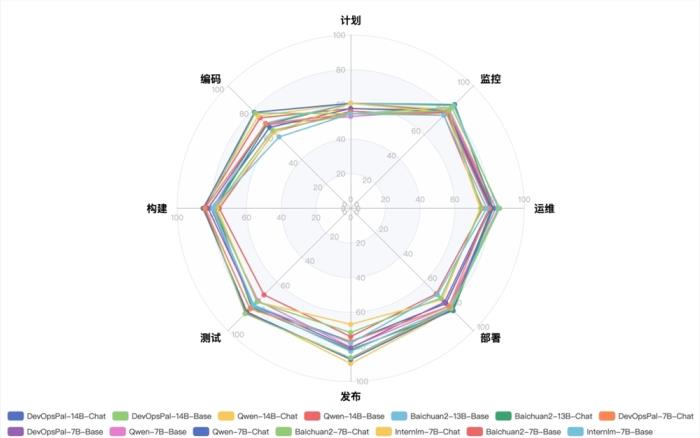

该评测基准包含了计划、编码、构建、测试、发布、部署、运维和监控等8个类别的选择题,共计4850道题目。

此外,还针对 AIOps 任务做了细分,并添加了日志解析、时序异常检测、时序分类和根因分析等任务。

目前,DevOps-Eval已发布了第一期的评测榜单,评测了 OpsGpt、Qwen、Baichuan 和 Internlm 等开源大语言模型。DevOps-Eval 的评测方式包括 Zero-shot 和 Few-shot,评测结果显示各模型得分相差不大。

未来,DevOps-Eval 将持续优化,丰富评测数据集,重点关注 AIOps 领域,并增加更多的评测模型。

相关推荐

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

热门文章

新火种

2023-11-07

新火种

2023-11-07