康奈尔中国博士生打造AI声呐眼镜,能连续识别31条无声语音指令

“据我们所知,EchoSpeech 是第一个使用眼镜框来进行无声语音识别的工作。论文发表之后我们收到了很多邮件。在发信人中,有即将被移除声带的癌症患者、有语音障碍的孩子、也有来自医生的。这些反馈激励着我们更加努力地将本次成果带出实验室,做出真正能够改变人类生活的产品。”清华大学校友、目前正在美国康奈尔大学读博的张瑞东表示。

图 | 图中张瑞东佩戴的眼镜就是 EchoSpeech 设备(来源:Photo Courtesy of Dave Burbank)

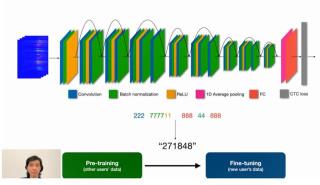

EchoSpeech 是一款新型可穿戴无声语音识别系统 ,它可以连续识别 31 条无声语音指令,准确率达到 95%,最高电池续航时间约 10 小时。其中,传感器成本不超过 100 元,单片机处理器成本 300 元左右。

无声语音指的是只动嘴、而声带不发声的说话方式,有些类似于耳语(不严格区分的话,耳语也可以算作无声语音)。

不过,耳语本身必须发出一些声音,而无声语音则无需发出任何声音。正在阅读这篇文章的你可以尝试一下耳语,但是不要送出气流,这样几乎不会发出任何声音,而嘴唇和舌头依然会动。

对于公众来说,无声语音可能仍然是一个新鲜事物。但是,大家在日常中或多或少都会接触到。比如,开会时和别人交流时的耳语。

相比有声语音来说,无声语音最大的优势就是“无声”。在一些安静的场合,比如图书馆、会议中等,出声地说话是不合适的;另外,在特别嘈杂的环境中,语音交流也会容易受到噪声的影响。在这种情况之下,都可以使用耳语。

而对于声带损伤者或残疾人士来说,无声语音可能是最接近语音交流的唯一选择。在这个意义上,关于无声语音的相关应用具备很大的潜力。

对于无声语音识别这项技术,已经有很多课题组在研究。最成熟、最流行的是依靠计算机视觉的方案:即使用相机直接捕捉面部运动尤其是嘴唇的运动。

这种方法的缺点十分明显:它必须在用户面前放置相机,而这就涉及到普适性、功耗、隐私等问题。

也正因此,目前面向可穿戴领域的解决方案多数还不成熟,在穿戴舒适度、功耗、系统等方面依旧欠佳。

例如,在多支团队的研究成果中,都需要在口腔内放置传感器来追踪舌头运动。绝大多数方案只能识别说得比较清晰、语速较慢的离散指令,例如能识别单独说出来的、中间有暂停的 1-2-3,但是无法识别连续说出来的 123。

而张瑞东所在团队研发的 EchoSpeech,在穿戴舒适度和连续识别上有着明显优势。

在 EchoSpeech 的设计中,传感器即小扬声器的麦克风,被安装在眼镜框的下边缘。这时,通过采用声波感知技术,就能探测面部运动尤其嘴唇的运动,并以此来识别无声语音。

与同类成果相比,EchoSpeech 具有体积小、佩戴舒适、功耗低、隐私保护好等优势。同时,在识别连续词组/句子的能力上,EchoSpeech 也有着很大提升。

(来源:ACM)

长期来看,无声语音识别技术很有潜力作为普通语音识别的替代和补充。有研究显示,隐私和社交尴尬是用户不愿使用语音识别的重要因素 [1,2]。而无声语音恰好解决这两个问题,原因在于它可以扩展语音输入整体的应用。

另一方面,无声语音还能把语音识别技术扩展到更多场景中,例如有望让用户在工作环境下使用无声语音控制设备,同时也能让用户使用无声语音来与 AI 使用自然语言交流,这样一来既能大大提高工作效率,也不会打扰到周围人。

不过短期来看,由于词汇量、识别准确率等方面的限制,要想实现大规模的应用可能还不成熟。目前,最有希望将 EchoSpeech 用于控制音乐播放和社交软件等。

张瑞东表示:“一直以来,我们实验室都专注于可穿戴交互设备的研究。我的上一个项目 SpeeChin,也是一个无声语音识别的工作。不同之处在于,SpeeChin 采用挂在项链上的红外相机来捕捉下巴运动,进而去推断无声语音。”

相比之前的工作,SpeeChin 在识别准确率和设备舒适性上有着极大提高。但是,作为一种采用相机的方案,其依然存在功耗高、侵犯隐私等问题。

正因为这些原因,该团队一直在开发应用范围更广泛的感知技术,比如声波感知技术等。

张瑞东表示:“为此我参与了一个名为 EarIO 的项目,期间我们利用耳机上的扬声器和麦克风,借助声波感知技术通过捕捉耳后皮肤的微小震动来重建面部表情。在 EarIO 获得成功时,我们立刻意识到了这项技术在其他方面的巨大潜力。于是开启了本次 EchoSpeech 的项目。”

立项之后,有两个难题摆在张瑞东面前:一是寻找最合适的设备形态,包括设备本身的形态,以及传感器的位置、角度和数量;二是提高系统性能,尤其是识别连续短语和句子的能力。

在寻找设备形态上,他们尝试了很多方案,比如耳机+外延的结构、以及环绕头部固定器+外延结构等。但是,这类结构的主要问题在于,在多次佩戴之后稳定性欠佳。

他们也尝试过入耳式耳机、头戴式耳机等结构,不过由于距离主要“发音器”(即说话时活动的部分例如嘴唇、舌头)比较远,故在同等条件之下识别准确率不甚理想,同时所需要的数据也更多。

后来,张瑞东的导师想到了眼镜。“导师强烈建议我试一试眼镜框,我之前对眼镜框不是很有信心,因为它离主要的‘发声器’太远了。而且由于位置和角度的原因,并没有合适的直线传播路径。但是,在尝试中我意识到对于信号来说,其实并不需要直线传播。”张瑞东说。

眼镜的好处之一在于稳定性高,一般情况下眼镜会被贴合地佩戴在头上,在多次佩戴之后依然具备较好的稳定性。并且,眼镜和主要“发声器”之间的相对距离比较稳定。

直到这时,装置的最终形态终于被确定下来:即在眼镜框下缘布置传感器,其中一侧放置扬声器,另一侧放置麦克风。

在提高系统性能上,他们并未使用先切割出来说话部分、再进行识别的方法,而是使用端到端的方法,一次性地完成切割任务和识别任务。

这样一来,当佩戴者不说话的时候,系统就会输出空标签。至此,前面提到的两个难题均被攻克,关于 EchoSpeech 的课题也正式宣告结束。

日前,相关论文以《EchoSpeech:由声学传感驱动的最小干扰眼镜上的连续无声语音识别》(EchoSpeech: Continuous Silent Speech Recognition on Minimally-obtrusive Eyewear Powered by Acoustic Sensing)为题发在 2023 ACM 人机交互国际会议上,该会议也被认为是人机交互领域最负盛名的会议。张瑞东是论文第一作者,康奈尔大学教授张铖担任通讯作者 [3]。

图 | 相关论文(来源:ACM)

基于本次成果,张瑞东也将开展语音合成、以及扩展词汇量。

假如可以实现语音合成,那么就能用于发音障碍人群身上,从而给他们提供一个真正的语音交互接口。

而之所以打算拓展词汇量,是因为如果想把无声语音识别真正做成一个有用的产品,就必须能够识别更多的单词。

长期来看,该团队希望无声语音识别技术的表现,能够和普通语音识别相媲美,只有这样才能讨论更加长远的应用。

另据悉,张瑞东所在的团队专注于研究智能传感器件,此前他们还曾造出可以检测表情的耳机等创新设备。目前,该团队已有超过 20 项正在申请的美国专利和国际专利。

参考资料:

1.Christine Rzepka. 2019. Examining the use of voice assistants: A value-focused thinking approach. (2019).

2.Philip Weber and Thomas Ludwig. 2020. (Non-)Interacting with Conversational Agents: Perceptions and Motivations of Using Chatbots and Voice Assistants. In Proceedings of Mensch Und Computer 2020 (Magdeburg, Germany) (MuC ’20). Association for Computing Machinery, New York, NY, USA, 321–331. https: //doi.org/10.1145/3404983.3405513

3.Zhang, R., Li, K., Hao, Y., Wang, Y., Lai, Z., Guimbretière, F., & Zhang, C. (2023, April). EchoSpeech: Continuous Silent Speech Recognition on Minimally-obtrusive Eyewear Powered by Acoustic Sensing. InProceedings of the 2023 CHI Conference on Human Factors in Computing Systems (pp. 1-18).

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2023-11-01

新火种

2023-11-01