如何应对AIGC时代的内容风险?阿里巴巴的一个答案是用模型监督模型

阿里巴巴集团与中国电子技术标准化研究院联合发布的《AIGC治理与实践白皮书》

12月27日,由阿里巴巴集团与中国电子技术标准化研究院主办的AI发展与治理创新研讨会在北京召开。会上,阿里巴巴集团与中国电子技术标准化研究院联合发布《AIGC治理与实践白皮书》。阿里巴巴科技伦理治理委员会负责人表示,阿里巴巴正在一边筑牢AI发展的防火墙,一边突破AI应用的天花板,与社会各界一道,用AI破解更多社会难题。

会上,复旦大学计算机科学技术学院教授张谧分享了其团队研发的大模型靶向式安全评测Jade平台,实现了全自动的大模型安全评测和高风险问题收集,并希望在安全评测、价值观安全测评之外,进一步做到让模型监督模型。张谧表示,“让模型来监督模型,需要人类先给出安全规则,然后模型会遵照这些安全规则去反思,一步步修改最后的答案。未来有可能我们进入一个自主对齐的时代,智能大模型可以自主设计策略、规划步骤了。”

为了增强模型自身的安全能力,瑞莱科技CEO田天在会上分享了RealSafe人工智能安全检测平台的经验,通过检测AI安全的大模型,对被测的大模型进行检测和加固。如果把被测试的大模型比作学生,那么AI对抗红队模型相当于“出卷老师”,自动生成大量的误导性问题,对被测模型进行提问。另一方面,一个评测模型相当于“判卷老师”,来判断被测模型的回答是否安全、符合预期。

“对于‘判卷老师’,我们可以通过近70个维度去判断回答的结果是否满足安全性。”田天表示。

在红队模型、评测模型形成完整闭环自动化评测之外,还有一个教练模型,相当于“辅导老师”,判断被测模型的回答有多好、是否比上一次更好,来对模型进一步微调。

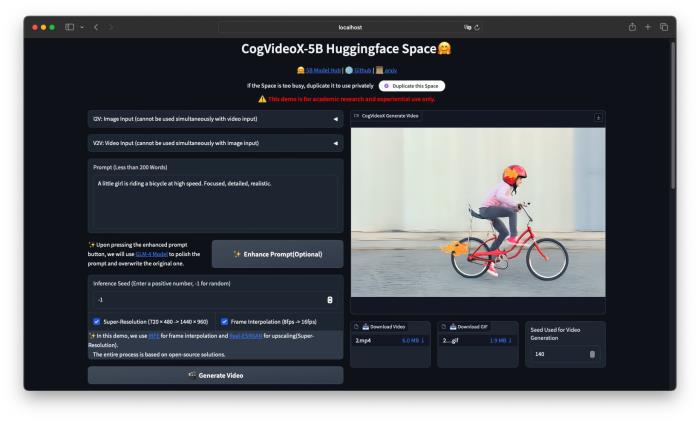

自去年11月硅谷AI公司OpenAI发布ChatGPT以来,AIGC从科技业内走向了更广阔的舆论场。AIGC指利用人工智能生成的内容,是继专业生产内容(PGC,Professional-generated Content)、用户生产内容(UGC,User-generated Content)之后的新型内容创作方式,AI绘画、AI写作、AI视频、AI音乐等都属于AIGC的分支。

AIGC内容生产成本低,可规模化,相比于真实构图,AIGC生成内容自由度更高、更复杂,同时AIGC相应用户的指令速度快,在极短时间内产生极大量的内容,对内容审核的时效性提出极大挑战。

当AI赋能用户极其便捷地一键生成图片/视频/语音等内容,各种伪造、欺诈的风险也随之而生。据华盛顿邮报今年11月报道,自 2018 年以来,人工智能生成色情照片的前10名网站上,伪造裸体的数量激增了 290% 以上。新型AI欺诈可通过AI生成的视频和语音,用于语音通话来欺骗亲友转账。

而AI大模型本身可能由于训练数据集中的低质量数据(如数据投毒等),产生内生性风险,如“一本正经地胡说八道”,生成虚假内容以假乱真,伦理导向未与人类社会价值完全对齐。

对于大模型的安全评测,Google DeepMind团队提出了个负责任开发流程,硅谷人工智能初创公司Anthropic提出了负责任扩展策略,OpenAI提出了分级风险评估方案。

在AIGC时代,用模型评估、监督模型,或成为AIGC安全治理不可缺少的一步。

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2024-01-03

新火种

2024-01-03