谷歌的量子王炸能迎来“ChatGPT时刻”吗?

2024年12月10日或成AI划时代纪念日

作者/ IT时报记者 郝俊慧

编辑/ 王昕 孙妍

量子计算似乎迎来了“ChatGPT时刻”。

北京时间12月10日,谷歌在《自然》发表了最新量子芯片Willow的研究成果,在量子纠错率和随机电路采样(RCS)基准测试上取得关键性突破,用5分钟完成了一项标准计算,而当前最快的超级计算机Frontier则需要10²⁵(10的25次方)年才能完成,“比宇宙的年龄都要大”。

谷歌CEO桑达尔·皮查伊把量子计算的突破比作“莱特兄弟的首飞”,也有人将Willow类比为Transformer,在这个同样由谷歌推出的AI架构上,OpenAI做出了ChatGPT。

量子与AI的纠缠还不止于此,发布Willow的是谷歌量子AI实验室,这个名字听起来“与时俱进”的实验室,实际上成立于2012年,而Willow之所以在纠错上突破了30年来的挑战,源自谷歌已经于11月份发布的基于Transformer的解码器AlphaQubit,通过AI实时为量子计算机解码纠错,从而让Willow的量子纠错“低于阈值”。

所谓“低于阈值”,指的是量子比特越多,错误率越低,中国科学技术大学教授陆朝阳认为,Willow从之前的“越纠越错”,进步到“越纠越对”,突破了量子纠错“盈亏平衡点”,实现了量子比特的“正增益”。

Willow成功的迹象在今年8月谷歌量子AI实验室发表的一篇《量子误差修正低于表面码阈值》论文中可见一斑,文中对谷歌在量子纠错上的突破做了详细说明:每个(逻辑量子比特)编码的距离增加2,错误率就会下降一半以上。

在理解这句话之前,不妨先来了解一下量子计算的基本原理。

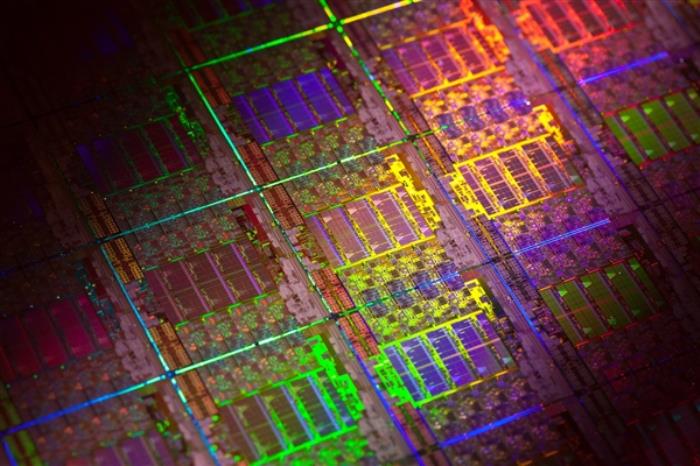

如大家所知,我们现在采用的经典计算是0和1的排列组合,你在电脑上、手机上输入的每个指令,最后都会被编译成0和1组成的代码,被计算机识别并计算。所谓的CPU芯片,就是晶体管组成的一个超大“开关”,每个晶体管的on/off,代表0或者1,而一颗强大的CPU可能拥有上千亿个晶体管。比如苹果的M2 Ultra上便有1340亿个晶体管。

受限于摩尔定律和量子隧穿效应,装在手机和电脑里的CPU不可能无限制地塞入更多晶体管,因此很多需要超大规模计算的问题,尤其是自然界的本源,传统经典计算很难解决。

量子计算则完全不同,它可以让0和1处于任何叠加态中,简单理解,如果一块传统芯片能存储n个数据,那拥有同样量子比特数量的芯片,可以存储2的n次方个数据。

这种计算能力指数级的上升,也是为何每次量子计算研究突破后,其表现出的算力和经典超级计算机相比,都不只是遥遥领先,而是百亿级以上的差距。

只是,算得快,并不等于算得好。

超导量子非常脆弱,周围的一点点干扰,甚至宇宙射线都会让其丢失信息,也即所谓的“退相干”。从目前研究结果来看,单个量子比特的错误率降低到千分之一(0.1%)后便很难进一步推进,而通用量子计算阶段的错误率,普遍被认为至少要下降至10的负12次方,也即万亿分之一。

学术界普遍采用建构逻辑量子比特的方式来实现量子计算纠错。比如谷歌此次用来实验的3×3、5×5、7×7编码模式,便是以一个物理量子比特为信息的存储载体,其他围绕它的量子比特作为“锚定比特”,通过冗余和特定的编码方案,检测并纠正可能产生的错误。而谷歌的实验结果证明,当形成一个逻辑比特的物理比特数量从90(3×3×10)到250再到490不断扩展时,错误率指数级下降,从而“低于阈值”。

同时,量子计算的特性,对量子纠错也产生了指数级的杠杆作用。比如,如果物理量子比特的错误率降低两倍,那么距离为27×27的逻辑比特性能就能提高四个量级,进入可被接受的错误率范围之内。也即7290个量子比特形成一个逻辑比特的话,量子计算的通用容错量子计算(FTQC)应该可以实现。

话说到这里,国人最关心的是,中国的量子计算和谷歌差距远吗?

一位量子科学家的话让我放下了心:差距是有,但无论在硬件层面还是纠错算法方面,中国都一直在跟进,而且进展也都不错。

硬件结构上,Willow采用的是Tunbale coupler架构,这个技术架构于2019年发布,国内中科大、北京量子研究院、南方科大都有类似的实验成果;纠错效果上,Willow实现了“低于阈值”,并在实验体系中实现了d=5和d=7的纠错,说明谷歌在量子控制技术上实现了超越性突破,但国内南方科技大学俞大鹏院士团队也在去年实现了“量子纠错盈亏平衡点”。国内也有其他研究团队采用和谷歌类似的表面码方案,在编码距离上略有落后,目前应该处于d>5>3的位置。

尽管从大方向上看,Willow似乎依然走在“老路”上,但进步往往发生在隐秘的角落。谷歌借助AI实现了Decoder(解码器)方案的筛检和软硬件上的实时线路编译,证明它的系统工程能力非常强。就好像OpenAI选择的LLM大模型道路,同样并不新鲜,但基于其强大的算力投入和系统工程能力,最终引爆此次人工智能浪潮。

从这个意义上看,Willow至少处于ChatGPT 1.0时期,目前实验结果显示,谷歌找到了一条相对正确的路。

不过,从谷歌官方透露的信息显示,Willow的随机电路采样(RCS)基准测试,虽然在“经典难以解决”的基准线智商,但其商业相关性还比较弱,这表明其依然不具有实用价值。

中国量子科学的顶尖科学家、中国科学院院士潘建伟将量子发展分为三阶段:实现量子优越性、解决专用计算问题、通用量子计算。目前全球量子科研水平多集中于第二阶段,对于第三阶段的实现,科学家们曾给出了10~15年的时间窗口,但Willow的成功,AI for Science的变革,让这个窗口期正在缩短。

量子力学被称为自然界的“操作系统”,模拟大自然的任务被认为只有量子力学能够完成。比如通过量子测量,在磁共振成像(MRI)和核磁共振(NMR)中,以原子为尺,可给出分子、原子核之间的精确距离,从而在更高维度解锁AI目前面临的“数据困境”。物理、化学、生物医药、核聚变、材料科学等领域,都将可能因此迎来划时代的突破。

更关键的是,电力消耗也将指数级下降。短时期内,限制量子计算发展的“摩尔定律”还不会出现。科学家预估,物理量子比特要达到百万级以上才可能摸到通用计算的门槛,但这个级别量子位的芯片,和如今千亿级的晶体管相比,制程工艺要求低许多,以国内现有的制程工艺来看,实现不难。

长期来看,经典计算机在规模扩张、应用落地、场景寻找等范式变革过程中遇到的挑战,在超导量子计算机上也会“复刻”一遍,但这一次,全世界应该会更快找到适应的办法。

比尔·盖茨说:“人们总是容易高估未来两年的变化,却往往低估未来十年的变革”。

十年之后回头看,2024年12月10日或许会被定义为“前AI时代”的一个纪念日。

这一天,OpenAI正式发布了Sora,意图“无中生有”,生成一个虚拟的物理世界,而Willow则正好相反,试图用量子计算解读自然界的一切。当二者进入“叠加态”时,科幻正变为科学,曾经遥远的未来,正在逼近现实。

排版/ 潘璐

图片/ pixabay 谷歌

来源/《IT时报》公众号vittimes

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

热门文章

T时报

2024-12-13

T时报

2024-12-13