2023年AI芯片盘点!NVIDIA遥遥领先赢麻了

2023年,ChatGPT的爆火预示着AI正式进入快车道。在此背景下,各类AI芯片随之成为最热门的科技话题。其中NVIDIA凭借极具前瞻性的布局,推出了世界上最强的AI计算加速芯片,市值成功突破万亿美元大关,成为今年最大赢家。

也许是NVIDIA在AI芯片领域太强,以至于夺走了所有光环。实际上今年AI芯片的发布和迭代远不止NVIDIA一家。无论是传统芯片巨头,还是新兴科技公司,都是这个赛道的积极布局者。接下来,就让我们一起回顾2023年AI芯片领域的那些重量级新产品。

NVIDIA:H100、H200

今年,NVIDIA发布了两款全新的AI加速卡H100和H200。这两款产品均采用了NVIDIA最新的Hopper架构,其中H100在性能上相较于A100提升了80%。

而H200则具备更强大的性能,成为全球首款采用HBM3e高带宽内存的AI加速芯片,专为推理工作负载而设计,同时也是首款基于Hopper架构的推理加速卡。通过这两款产品的推出,NVIDIA进一步巩固了其在AI计算平台领域的领先地位。

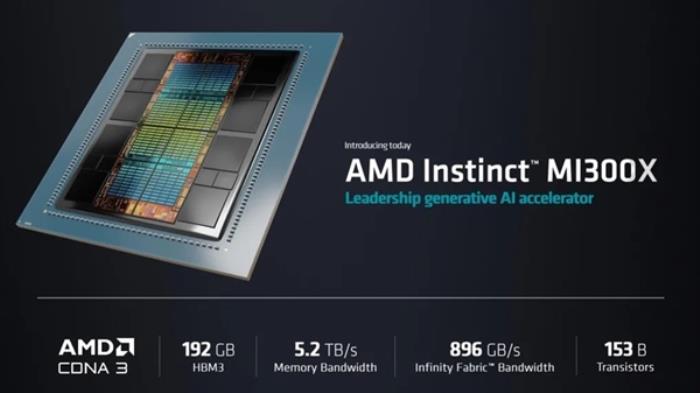

AMD:Instinct MI300

AMD今年拿出了MI300来硬刚NVIDIA的H100。MI300拥有两种型号,分别为MI300A和MI300X。其中,MI300A为结合CPU和GPU的超大规模APU,它将x86 CPU和GPU集成一体,封装小芯片9个,还有128GB的HBM3内存,提供了多达24个ZEN4内核以及228CU。

而MI300X则全部由GPU小芯片封装,一共8颗XCD,每个XCD提供38个CU(满血为40CU),总计提供了多达304CU,一同封装的HBM3内存容量更是提升到了192GB,5.2TB/s 的内存带宽,896GB/s的Infinity Fabric 带宽。

Intel:Gaudi2

Gaudi2基于第一代Gaudi的高效架构打造而成,目前采用7纳米制程工艺,相较第一代产品,在矩阵乘法(MME)和Tensor处理器核心计算引擎中引入了FP8在内的新数据类型,Tensor处理器核心数量增至24个,同时集成了多媒体处理引擎,内存升级至96GB HBM2E,为训练超大规模神经网络提供硬件保证。

AI时代,算力就是产业发展的原动力。这激发着全球芯片巨头纷纷加大在AI芯片领域的研发和部署。

尽管英特尔和AMD都已推出面向AI应用的专用加速产品。但至今,NVIDIA在这个赛道中始终遥遥领先,其产品卓越的性能确保了在训练领域的霸主地位。这也使得NVIDIA系列产品,成为市场上AI应用采购的“头号选择”。

云服务巨头:

Google:Cloud TPU v5e

今年Google Cloud Next ’23 年度大会上,谷歌推出了全新的 TPU 产品 ——Cloud TPU v5e。它为中型和大型训练和推理带来了高性能和成本效益。

这代 TPU 可以说是专为大语言模型和生成式 AI 模型打造,与前代 TPU v4 相比,每美元训练性能提升高达 2 倍、每美元推理性能提升高达 2.5 倍。并且 TPU v5e 的成本不到 TPU v4 的一半,使更多机构有机会训练和部署更大、更复杂的 AI 模型。

Amazon:Trainium2 AI量子芯片

全球第一大公有云巨头AWS(亚马逊云科技)近期扔出了面向生成式AI和机器学习训练的年终“王炸”,Trainium2 AI量子芯片。它针对训练自然语言处理、计算机视觉和推荐器模型进行了优化,这些模型用于文本摘要、代码生成、问题解答、图像和视频生成、推荐和欺诈检测等各种应用程序。

Trainium2是一款量子芯片,号称错误率仅 0.1%,能源效率是上一代的两倍,性能比上一代芯片提高到4倍,可提供65ExaFlops超算性能。

亚马逊计算部门资深副总裁 Peter DeSantis声称,亚马逊量子运算团队在量子纠错上有重大的进展,以逻辑量子位元的方式,将比特翻转(Bit-flip)与相位反转(Phase-flip)错误分开,从而推出了 Trainium2 芯片。

Microsoft:Maia 100

微软自研AI芯片传闻未曾停过,今年终于在Microsoft Ignite 2023大会上,发布了用于资料中心的AI加速器芯片Azure Maia 100,采用5纳米制程生产,适用于OpenAI模型、ChatGPT、Bing、GitHub Copilot 等AI工作负载。

作为全球公有云的三大巨头,谷歌、亚马逊和微软一直与NVIDIA等芯片厂商保持着密切合作,其数据中心大量采用了NVIDIA等厂商的最先进AI加速卡,如A100、H100。这为云平台带来强劲的AI处理性能,大幅提升机器学习等算法的训练效率。

但与此同时,三巨头也意识到过度依赖第三方芯片的风险。因此,他们也开始大力投入自主研发工作,推出定制化的AI处理器。

这不仅能降低成本,也使其拥有芯片创新能力,为平台差异化提供支持。可以预见,这类云定制AI芯片会得到快速迭代和规模化部署。它们甚至有可能通过开放服务,向其他潜在客户提供更经济高效的AI处理能力。

在这场新一轮科技革命中,AI芯片正致力解决计算瓶颈,为智能语音、自动驾驶等前沿技术奠定基石。众多芯片厂商和科技公司争相进入这片蓬勃发展的蓝海。

未来随着AI模型和应用场景不断增多,对算力的渴求也会成正比上升。这必将推动新硬件架构、新工艺技术的快速革新,带来更激烈的平台竞争与融合。

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2023-12-04

新火种

2023-12-04