图森未来正式发布图生视频大模型“Ruyi”

2024年12月17日 - 图森未来今日正式发布“Ruyi” - 图生视频大模型,并将Ruyi-Mini-7B版本正式开源,用户可以从huggingface上下载使用。我们希望通过开源模式,让更多AIGC爱好者和社区成员能够自由体验。“Ruyi”专为在消费级显卡(例如 RTX 4090)上运行而设计, 并提供详尽的部署说明和 ComfyUI 工作流,以便用户能够快速上手。

关于Ruyi:

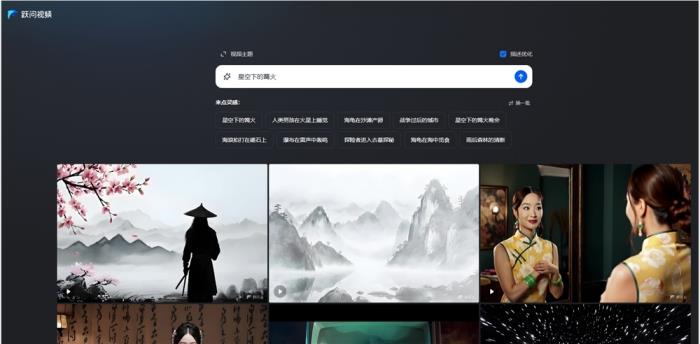

Ruyi是图森未来正式发布的第一款“图生视频”模型。凭借在帧间一致性、动作流畅性方面的卓越表现,以及和谐自然的色彩呈现和构图,Ruyi大模型将为视觉叙事提供全新的可能性。同时,该模型还针对动漫和游戏场景进行深度学习,将成为ACG爱好者理想的创意伙伴。

卓越特性

多分辨率、多时长生成

Ruyi支持最小384*384,最大1024*1024分辨率,任意长宽比,最长120帧/5秒的视频生成。

首帧、首尾帧控制生成

Ruyi可以支持最多5个起始帧、最多5个结束帧基础上的视频生成,通过循环叠加可以生成任意长度的视频。

运动幅度控制

Ruyi提供了4档运动幅度控制,方便用户对整体画面的变化程度进行控制。

镜头控制

Ruyi提供了上、下、左、右、静止共5种镜头控制。

技术概览

模型架构

Ruyi是一个基于DiT架构的图生视频模型,它由两部分构成:一个Casual VAE模块负责视频数据的压缩和解压,一个Diffusion Transformer负责压缩后的视频生成。其中Casual VAE模块会将空间分辨率压缩至1/8,时间分辨率压缩至1/4,压缩后每个像素由16位的BF16进行表示。DiT部分使用3D full attention,在空间上使用2D RoPE进行位置编码,时间上使用sin_cos进行位置编码,最终的loss选用了DDPM进行训练。模型的总参数量约为7.1B,使用了约200M个视频片段进行训练。

训练数据和方式

整个训练分为了4个阶段:

在第一阶段我们使用约200M的视频数据+30M图片数据进行256分辨率的预训练,训练batch size为4096,共训练350k个iteration至充分收敛。

第二阶段使用了约60M的视频数据进行384-512分辨率的多尺度微调训练,训练batch size为1024,共训练了60k个iteration。

第三阶段使用了约20M的高质量视频数据和8M的高质量图片进行384-1024分辨率的多尺度微调,训练batch size根据显存大小进行动态调整,共训练约10k个iteration。

第四阶段使用了10M的精选高质量视频数据进行了图生视频的训练,训练batch size为1024,共训练约10k个iteration。

输入格式和生成长度/模式

Ruyi需要用户提供一张图片作为输入,并可以选择输出时长、输出分辨率、运动幅度和镜头移动方向等选项,如意会根据输入的图像输出一个不超过5秒的视频。

现存缺陷

Ruyi目前仍然存在手部畸形、多人时面部细节崩坏、不可控转场等问题,我们正在改进这些缺点,在日后的更新中对它们进行修复。

下一步计划

随着AIGC领域竞争的日益激烈,图森未来认为: 最佳应用场景是孵化生成式AI工具的原动力。公司致力于利用大模型降低动漫和游戏内容的开发周期和开发成本。因此,Ruyi将持续聚焦在如何真正解决行业痛点。

本次发布的Ruyi大模型,已经可以实现输入关键帧后,生成之后5秒的内容,或输入两个关键帧,由模型生成中间的过渡内容,降低开发周期。未来将持续深耕场景需求,在此基础上实现直接生成CUT的突破。在下一次的发布中,我们将同时发布两个版本,为不同需求的创作者提供更加灵活的选择。

我们欢迎开发者持续探索Ruyi的能力,利用Ruyi开发出更多更好的应用。

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2024-12-18

新火种

2024-12-18