特斯拉机器人真这么丝滑?科技博主在线「打假」:远程操控的

特斯拉,你说句话呀。

前天,特斯拉开了一场相当科幻的发布会,其中一大看点就是新一代人形机器人 Optimus。

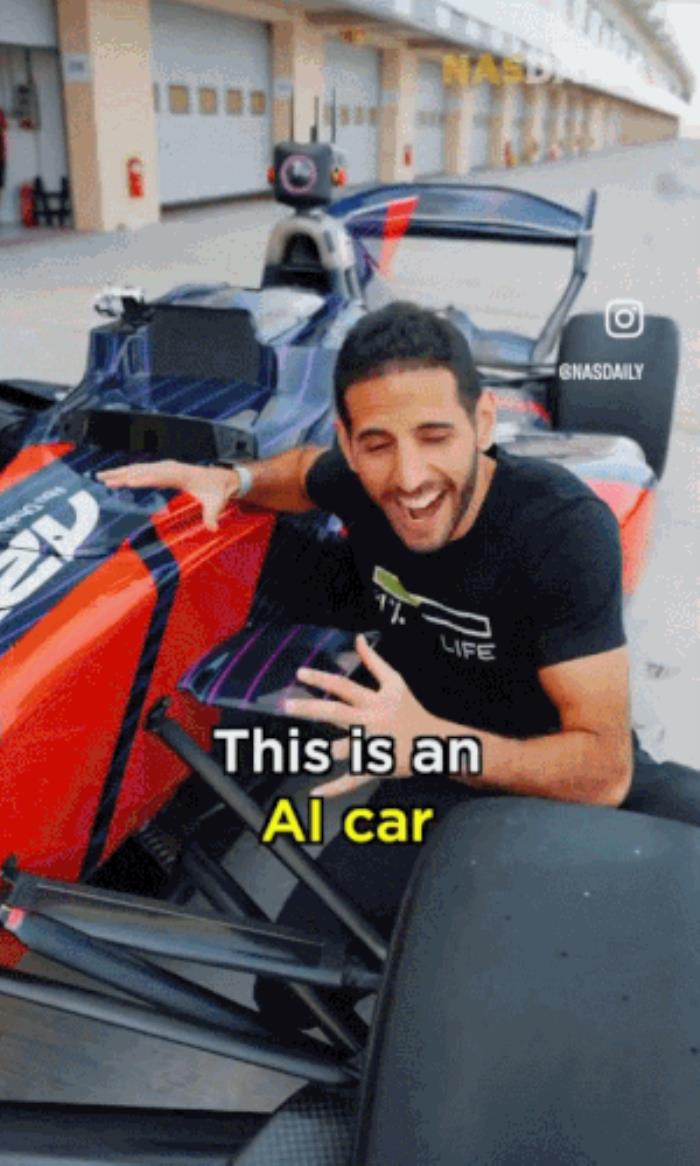

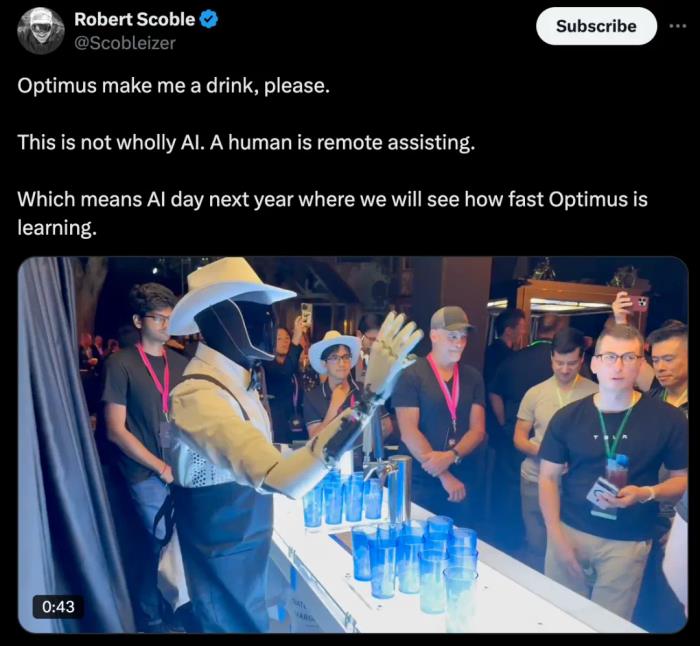

「你能以 2 万到 3 万美元的价格购买一台 Optimus 机器人,它可以当老师、帮你照顾孩子,可以遛狗、修剪草坪、买菜、做你的朋友、端上饮料,你能想到的任何事情,它都能做。」「我认为这将是有史以来最伟大的产品!」身穿皮衣亮相发布会的马斯克,一脸自豪地夸赞着自家的机器人。与此同时,社交媒体上也冒出一堆视频,均是展示 Optimus 的强大实力。比如,戴着牛仔帽的 Optimus 化身调酒小哥,平稳地倒着饮料:

视频来源:https://x.com/ChrisJBakke/status/1844610918552121596唱着生日快乐歌:

视频来自:https://x.com/ray4tesla/status/1844606188790370611它还到处闲逛,各种跟人搭话聊天:

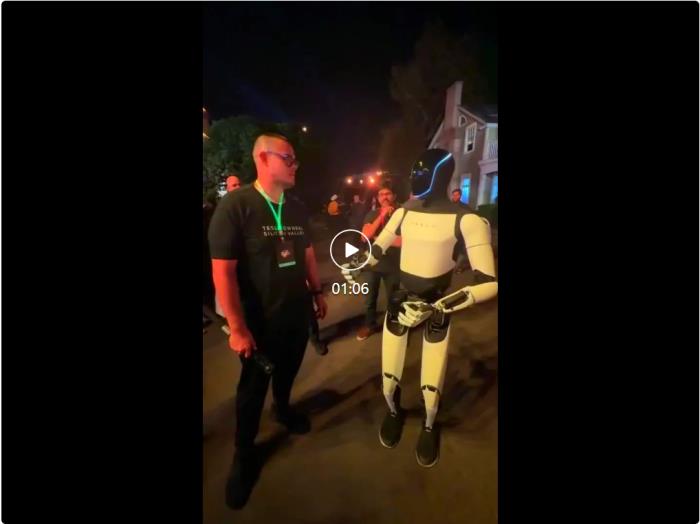

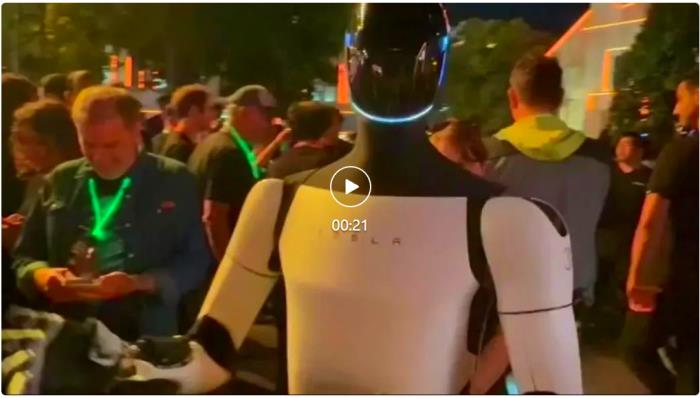

视频来源:https://x.com/teslaownersSV/status/1844610376165425658现场如此嘈杂,声音也是纷乱,Optimus 不仅能精确地锁定对答,还如此流畅,丝毫察觉不到响应的间隔。语言风格、语气语调听起来都与真人无异。如果这些都是 Optimus 的自主回应,那说明特斯拉的技术已经达到了新的 level。除了交流,Optimus 的动作似乎更加「出卖」了它。它的头部可以在对话过程中四处观察环境,扫视众人。手指也比往常更加灵敏,看起来每个动作都精准且生动,不得不让人怀疑,这真的是 Optimus 自己的水平吗?果不其然,有科技博主开始在线「打假」。科技博主在线「打假」几天前,特斯拉在华纳兄弟工作室的摄影棚中,举行了一场备受期待的媒体活动,并推出一款马斯克称之为 Cybercab 的无人驾驶出租车。华尔街并不买账,特斯拉股票应声跌了约 9%。当然,这并没有影响 Party 上的气氛,参加特斯拉活动的人们在社交媒体上发布了几十个视频,展示了 Optimus 机器人的绝活 —— 跳舞、说话,甚至调酒。不过,科技博主 Robert Scoble 在 X 上质疑:「这并非完全是人工智能,而是有人在远程协助」,并附上了一段视频。

图源:https://x.com/Scobleizer/status/1844593576040333767Scoble 的质疑并非空穴来风。他在现场专门问了一个机器人:「嘿,Optimus,你的人工智能成分有多少?」Optimus 有些慌乱地回答:「我不能透露具体有多少。这是你以后需要弄清楚的事情。」Scoble 又问:「是有一部分还是完全没有?」Optimus 开始打太极:「我想说,可能有一部分。我不会确认,但可能有一些。」

视频来源:https://x.com/Scobleizer/status/1844594008225611858答案似乎呼之欲出。以马斯克的性格,如果他真的制造了一群能与大量人群实时互动的机器人,早就大肆宣扬这一点了,但现实情况恰恰相反,他们的回应相当含糊其辞。Scoble 还发了一条后续推文,说他与一位特斯拉工程师进行了交谈以获得清晰的答案。「当它走路时,是 AI 在控制 Optimus。Optimus 可以在人群中走来走去,这真的太棒了。」但 Scoble 没有进行进一步详细说明。

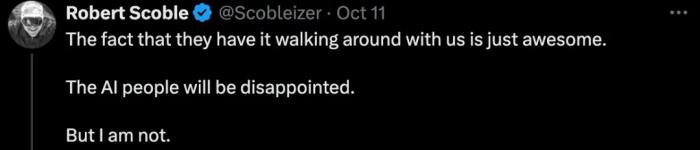

科技媒体 Gizmodo 也表示,以他们对 Optimus 的了解,马斯克实际上远远落后于竞争对手。今年 1 月份,马斯克篡改了一个 Optimus 的演示视频,被网友抓包。视频中,Optimus 正在叠衬衫,但眼尖的观众注意到,有一只手不断进入摄像机的视野。这意味着,有人在镜头外执行折叠任务,而机器人只是在模仿人类。

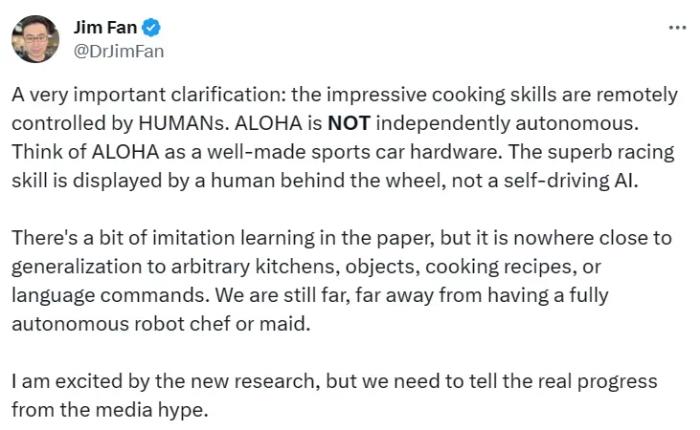

来自英伟达的研究科学家 Jim Fan 当时发布了推文,提醒大家别因为视频的惊艳程度就忽略了其中技术真相。他提到,应该将 Mobile ALOHA 看作是一辆制造精良的跑车,而它仍需要人类驾驶才能表现出自己的能力。现在的水平与能够完全自主的厨师还有较大的差距。

在机器人技术领域,从人类示范中进行的模仿学习已经取得了令人瞩目的成绩。其实训练 Mobile ALOHA 的过程就是像是在玩游戏 —— 操作机器人直到动作通关。Mobile ALOHA 之所以能够让人发出惊叹,是因为它所展示的任务不局限于桌面操作。这些复杂且灵活的动作源于研究者开发的一套系统,用于模仿需要全身控制的双臂移动操作任务。利用 Mobile ALOHA 收集的数据,进行有监督的行为克隆。研究团队在介绍时表示,对于一些简单的任务,Mobile ALOHA 可以在 50 次学习之后达到 90% 的行动成功率。对于一些简单的任务,如炒一只虾仁(有且只有一只)、拿块抹布、摆放好椅子,Mobile ALOHA 无需人类指点,还是可以自己 hold 住的。

今年 7 月,MIT 的研究人员竟通过头戴 Apple Vision 实现了远程操控 UCSD 实验室中的机器人。这种基于 VR 头显的 Open-Television 遥操作系统,可支持不同 VR 硬件平台来映射接入任意一种机器人,通过隔空操作来采集数据。操控者能以立体式主动感知机器人周围的环境。该系统还能将操控者的头部和手部动作映射到机器人上。

体验过 Mobile ALOHA 的梁力天表示:Mobile ALOHA 的直接关节映射使用起来非常直观,这使它成为比 VR 控制器更好的解决方案。这样的能力,只要 3.2 万美元的预算真的太值了。Mobile ALOHA 依赖于低成本的全身远程操作系统来收集数据,然后通过监督行为克隆的方式进行训练。它更侧重于移动和双臂协调控制,结合全身远程操作界面,使机器人能完成更复杂的操作任务。而 Open-TeleVision 强调基于视觉反馈的远程操作,使用强大的视觉模型来实时分析环境信息,并将手部关键点动作映射到机器人的关节角度。这种方式依赖高质量的视觉输入来精确地进行操作,适合用于复杂的、细粒度的任务。这表明 Open-TeleVision 适合那些需要高精度和视觉反馈的任务,其训练方式更复杂,适合处理细节精度要求较高的场景。而 Mobile ALOHA 则更加适合日常家务等移动和协调操作任务,它通过较少的训练数据就能取得很高的成功率,是一种更为实用的解决方案。在这次特斯拉的活动中,马斯克谈到了 Optimus 机器人,但并没有提及这些机器人是否完全自主。他表示这些机器人可以帮你剪草坪、买杂货,甚至照看孩子。不过,完成这些任务还是要依靠 AI 的自主执行能力。毕竟没人愿意买个需要远程操作机器人回家吧。

参考链接:

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种 2024-11-16

新火种 2024-11-16