中富金石:ChatGPT多模态重磅升级加速AI应用端需求

事件刺激:

今年以ChatGPT为代表的AI科技点燃市场热度,随着ChatGPT、Midjourney等现象级爆品出现,微软、Adobe、Salesforce、Zoom等软件巨头纷纷推出商业化产品,当前海外已进入商业落地阶段。ChatGPT引领的AI技术,将迎来大模型时代,作为大模型的基建底座,推动存算传需求激增。

最新消息:

9月26日,微软宣布Copilot将以初期版本形式推出,随后在今年秋天扩展到必应、Edge浏览器以及微软365 Copilot,而全球版 Copilot将在11月1日起面向企业用户提供服务。New Bing中集成DALL 3模型以加强图像AI功能,并向Bing聊天企业版提供多模态可视化搜索和图像创建工具,将加速AI应用端需求。

9月21日,华为云加速器—盘古大模型AI生态加速营在上海开营,作为中国首个全栈自主的AI大模型,盘古3.0包括"5+N+X"三层架构,将帮企业熟悉盘古、昇腾技术能力,加速AI驱动的规模化成长。

关注逻辑:

多模态AI加速突破,图生文能力打开GPT应用

9月20日,OpenAI宣布推出新版文生图AI工具DALL-E3,DALL-E3通过集成ChatGPT能力实现多项升级。此前,根据TheInformation报告,OpenAI即将推出多模态大模型GPT-vision。9月25日,根据OpenAI官网信息,ChatGPT即将在两周内对Plus和Enterprise用户开放一系列新功能,包括图像读取与理解(即图生文),以及语音对话能力。用户可以通过语音直接对ChatGPT对话,而ChatGPT也可以直接以语音的方式回复用户,使用一种新的文生语音模型,其中可选的五种声音由chatgpt向配音演员特别定制而来。

随着人工智能感知、交互和生成能力的快速发展,多模态大模型正推动人工智能迈进“通感”时代,应用场景和生态也将进一步丰富。多模态功能已成为各家AI大模型的必争之地。Meta最近推出AudioCraft,通过AI生成音乐;谷歌Bard及必应机器人均已部署多模式功能;苹果也在试验AI生成语音Personal Voice。而语音与图像数据大小显著高于文本,多模态大模型的训练推理算力需求将大幅攀升。

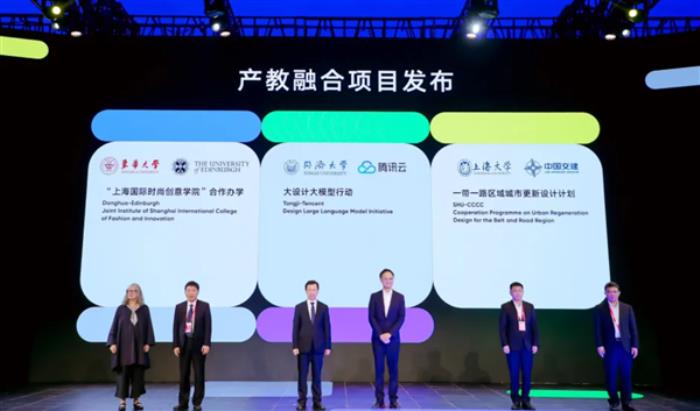

国内”大模型国家队“组建,大模型进入快速发展期

今年5月,国家启动大模型标准化工作,设立大模型专题组,其中百度、华为、阿里、360等入局“大模型国家队”,展示了目前国内较高水平数个大模型。《中国人工智能大模型地图研究报告》显示,从全球已经发布的大模型分布来看,中美两国数量合计占全球总数的超 80%,美国在大模型数量方面居全球之首,中国目前则已进入大模型快速发展期,与美国保持同步增长态势。据不完全统计,截止今年5月,中国10亿参数规模以上的大模型已发布79个。

截止目前国内已经有上百个大模型产品问世。而从地缘的角度来说,占据C位的还是北京和上海,其中北京的大模型公司数量和研发数量均独占鳌头,多达54个;而上海的优势则在AI算力方面。其他的一线城市如深圳、广州、杭州等也都有多个大模型创业公司。据统计,国内有11家大模型陆续通过《生成式人工智能服务管理暂行办法》备案,其中北京5家,上海3家率先上线,广东2家和安徽1家也陆续开放。从去年到现在,国内已经发生了接近100起以上的大模型行业的融资案例。从整个产业的投入估值来说, 2023年这个行业新增投入大概在150亿元到200亿元。

万卡规模、万亿参数,大模型有“高门槛”

大模型的快速迭代,需要高效算力和存储基础设施的加持。一方面,算力是大模型的引擎。语言类、视觉类模型容量和相应的算力需求都在快速扩大,金融大模型发展的背后是庞大的算力支撑。如果用“算力当量”(PetaFlops/s-day,PD),即每秒千万亿次的计算机完整运行一天消耗的算力总量,来对人工智能任务所需算力总量进行度量,大模型训练需要几百甚至几千PD的算力支持,意味着需要巨大的算力成本。如当前GPT-4和PaLM-2的算力当量已经达到GPT-3的数十倍,而谷歌正在开发的下一代多模态大模型Gemini,其训练量碾压GPT-4,达到后者5倍。

大模型光有算力远远不够,还取决于数据规模和数据质量,近几年,通用大模型的参数量快速增长。2016年OpenAI发布Gym强化学习平台,2018年GPT-1问世,模型参数为1.17亿,经过不断迭代,GPT-4参数规模达到1.76万亿。Google从2017年发布Transformer(6500万参数)架构以来,陆续发布BERT(2018年,3亿参数)、T5(2019年,110亿参数),参数规模逐步提高。近期,Google发布通才模型PaLM-E,这是全球最大的视觉语言模型,包含5620亿参数。

以ChatGPT3.0为例进行拆解,训练一次的成本约为140万美元,对于一些规模更大的模型来说,训练成本介于200万美元-1200万美元之间。随着算力需求持续增长,AI服务器的应用场景更加广泛。Trendforce预估,预估2022年全球搭载GPGPU的AI服务器年出货量占整体服务器比重近1%,即约14万台。预计2023年其出货量年成长可达8%,到2026年预计全球搭载GPGPU的AI服务器出货量将达到22.5万台左右,2022-2026年CAGR将达10.8%。根据IDC预测,到2027年中国加速服务器市场规模将达到164亿美元其中非GPU服务器市场规模将超过13%。

随着AI商业化落地节奏加快,后续需求有望逐步释放,将会对算力多个环节产生增量,大模型整个数据中心的架构都会发生改变,从AI服务器、到存储、再到网络的全栈方案都需要适应大模型时代的需求,同时软件服务公司将为大模型的研发及稳定运行提供安全支撑。

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2023-09-27

新火种

2023-09-27