要我说,人工智能还得看英特尔

2023年12月15号,英特尔发布了第五代英特尔至强可扩展处理器(以下简称第五代至强),大幅度强化了在人工智能方面的表现,为此还特意请了二手玫瑰乐队来热场。对于了解人工智能行业或者了解CPU的人来说会耐人寻味,因为在人工智能领域中,GPU往往才是那个起决定性作用的,英特尔作为CPU的代表,为什么会也强调人工智能的表现呢?

对于人工智能企业,通常会以服务器搭载的GPU来决定其性能。这是因为当下人工智能所使用的神经网络非常复杂,想要计算出一个完整且靠谱的结果,就需要将一个大任务划分成多个小任务,再同时执行,这种方法称作是并行计算。另一方面,由于多个任务同时执行,那就需要更多的节点加入到整个计算的过程中,也就是分布式计算,常见的分布式计算框架包括MapReduce和Spark等。

将上述两种计算方法综合在一起,再加上数据结构和软件优化,就是人工智能领域总是挂在嘴边的密集计算。GPU具备大量的并行计算核心,可以同时处理多个数据并行任务。此外,GPU对图像、视频等非传统数据结构的密集型任务处理效果更好。再加上GPU还有高效的内存访问模型(比如HBM3和GDDR6),就让更多的人工智能企业只在乎GPU而忽略了CPU的重要性。

诚然,GPU肯定是有GPU的好处,但事实上CPU亦是不可或缺,乃至至关重要的一环。让我们把麦克风交给英特尔,看看这位CPU老牌厂商是怎么做的。英特尔发布的第五代至强,单从平均性能上看,比第四代至强高出了21%。

第五代至强更新了几个重要的方向,以加速人工智能密集计算。第一个就是高级矩阵扩展(英特尔AMX),支持INT8和BF16这两种数据类型的深度学习训练和推理。INT8是指使用8位二进制表示整数的数据格式。在人工智能领域,INT8被广泛用于量化模型和低精度推理,以提高计算效率和减少存储需求。相比于更高位数的整数或浮点数,INT8占用更少的内存空间,可以减少数据传输和存储的消耗。虽然INT8表示的数值范围较窄,但在许多人工智能应用中,精度要求相对较低,使用INT8可以在不显著降低模型性能的情况下大幅提高计算速度。

BF16就更厉害了,这是一种浮点数格式,使用16位二进制表示浮点数。它在位数上比较接近于传统的半精度浮点数(16位),但在指数部分和尾数部分的位分配上有所变化。BF16在人工智能领域中用于深度学习模型的训练和推理,尤其是在使用混合精度计算(Mixed Precision)的情况下。相比于传统的单精度浮点数(32位),BF16可以在减少内存消耗的同时,保持对模型参数和计算结果的较高精度。它是一种平衡了计算性能和精度需求的浮点数格式。

那么回到刚才提到的,数据结构是构成密集计算的关键,支持更多种类的数据结构就会提高密集计算的效率。这是CPU在人工智能方面性能升级的核心之一。第五代至强第二点更新是寄存器的带宽以及加装了两个FMA单元。

寄存器(Register)是计算机体系结构中的一种存储器件,用于存储临时数据和指令操作数。寄存器位于CPU内部,是与CPU内部数据通路直接连接的高速存储器。与内存相比,寄存器具有更快的访问速度和更低的延迟。寄存器带宽越高,性能就越好。

FMA(Fused Multiply-Add)单元是一种计算单元,用于同时执行多个浮点数乘法和加法操作。它是现代CPU的一个重要部分,用于实现高性能的浮点数运算。FMA单元可以用较低的延迟和更高的吞吐量进行浮点数乘加运算。FMA单元可以在一次指令周期内执行一个乘加操作,利用了乘法和加法之间的数据依赖性。这种乘加操作常用于矩阵乘法、向量加权和神经网络的计算等任务中,可以加速复杂的数值计算。

说了这么多产品的技术那么回到性能层面,第五代至强相较于第四代至强在推理方面的性能提升了42%,自然语言处理的性能提升了23%,图像分类和目标检测性能提升了24%,运行参数量在200亿以下的大语言模型时,能够实现词元处理时延低于100ms。

英特尔努力给谁看?

我要是英特尔我肯定选择摆烂,因为CPU的工作方式是指令解码和执行,通过从内存中获取指令,并将其解码成可执行的操作。在拿到任务以后,分配给其他单元,比如算术逻辑单元、控制单元等。有点像是工地上的工头,分配工人们搬砖、砌墙。

CPU的优点是极强的单线程执行能力、灵活、以及高可编程性。可这些优点在人工智能的密集计算中并不是很需要,这也是为什么我刚才说“如果我是英特尔,那我会开始摆烂”。毕竟逆风局,打得太累了。可英特尔之所以继续加把劲,原因在于英特尔的战略规划。

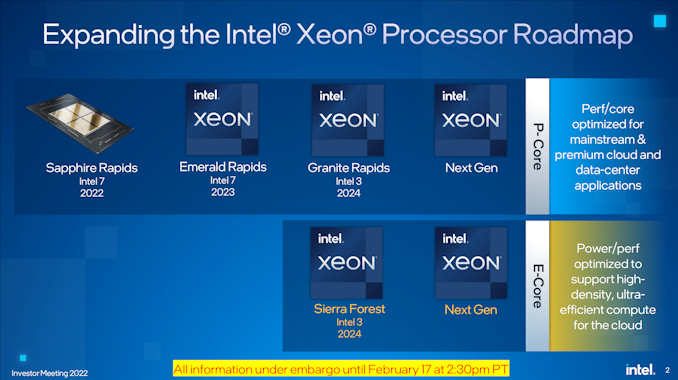

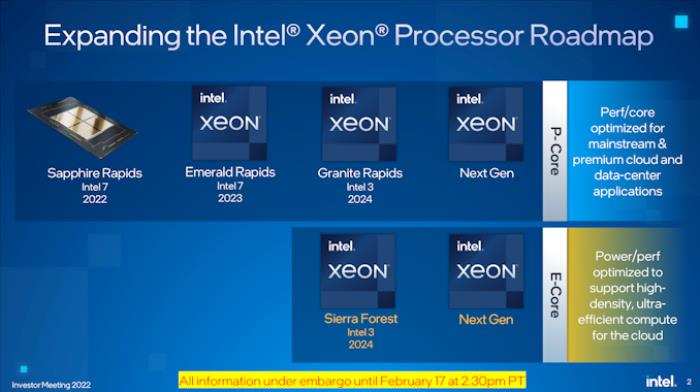

这时候就要搬出这张图了。

英特尔产品规划图

这张图描述的是英特尔至强处理器产品的规划,从2024年开始,产品线会增加一倍,分别为P-core至强和E-core至强。P-core指的就是高性能,E-core指的就是低功耗。就从起名方式来看,也知道下一代至强E-core版有多么特殊。从2017年的第一代至强开始,其代号分别为天湖、喀斯喀特湖、库珀胡、冰湖、蓝宝石急流、翡翠急流、花岗岩急流,都是水相关的。而下一代至强E-core叫做Sierra Forest。

Sierra并不是英语,而是西班牙语,意思为山脉。比如Sierra Nevada就是内华达山脉的意思,那么Sierra Forest就是山地森林的意思。那我考考你,如果你是一个大型人工智能企业,你有很多预算,如果英特尔推出了下一代至强产品,你应该买更高性能的P-core版,还是更低能耗的E-core版?

这是一个很反直觉的事情,答案是E-core。大规模客户往往已建立好服务器集群,服务器跟3C产品不一样,企业客户换代不需要频繁更新换代,但是会替换一些过时的服务器产品以填补人工智能领域的算力需求。这时候性价比更高的E-core给了大规模客户更多的选择空间,能用更少的预算达到相同的目标,而且大规模的服务器集群,维护成本是指数级上涨的,低能耗的产品就意味着运维成本更低。事实上,一台服务器从采购到报废,90%的成本,甚至可以说99%的成本都是运维。

另外一点,第四代至强和第五代至强采用的制程都是Intel7。说到这里补充一个冷知识,包括英特尔内部人员在内仍有很多人分不清,Intel7、Intel4、Intel3,代表的不是咱们说的3纳米、4纳米和7纳米,而是英特尔独有的制程规划。Intel7和10纳米差不多、Intel4和7纳米差不多。从规划图中可以看到,下一代至强直接跳过了Intel4,直接使用Intel3。虽然现在还不清楚Intel3制程的具体参数,不过可以猜到,应该会比2023年所有高精尖芯片的性能都要强。

芯片制程越小,CPU能耗就越低,这也正是当下所有人工智能,尤其是大型人工智能企业最需要的。再加上E核和P核的战略,可以明显看出英特尔在2024年主打一手专门针对人工智能企业强化销售,进而提高企业收入。

回到第五代至强,既然英特尔很清楚怎么提高人工智能时代下的销售额,那么首先就需要给市场打一针强心剂,或者说用产品来给企业定性。让英特尔的客户以及潜在客户明白,即使步入了人工智能领域,GPU当道的局面,你照样得需要一颗“灯,等灯等灯”的CPU。英特尔在15日发布会上强调无数次,说2023年是AIPC的元年,这可不是随口找个slogan,综上所述,人家可是真的这么玩的。

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2023-12-28

新火种

2023-12-28