大模型亟需“紧箍咒”

湖南日报全媒体记者 王亮

要说计算领域,今年上半年哪类产品或者概念最火,非大模型莫属。

9月16日,在2023世界计算大会“数据安全与合规治理”计算安全论坛上,西安电子科技大学教授王皓针对大模型郑重发声:“大模型很好,但也面临法律、道德、隐私等一系列问题,亟需做好监管。”

(论坛现场。王亮 摄)

以国外的ChatGPT、国内的文心一言为代表的通用大模型,是由人工智能技术驱动的自然语言处理工具,能够真正像人类一样来聊天、交流,完成撰写邮件、文案、代码、论文等复杂任务。目前,国内外众多网络科技公司纷纷推出了自己的通用大模型。

“大模型作为人工智能发展到一定程度的产物,因为发展时间短,信息保护比较脆弱,容易导致信息泄露。”王皓介绍,“近期一些大模型被人通过特殊的表述和语言,获取了大量的手机IMEI码或者Windows激活密钥,造成安全风险。”

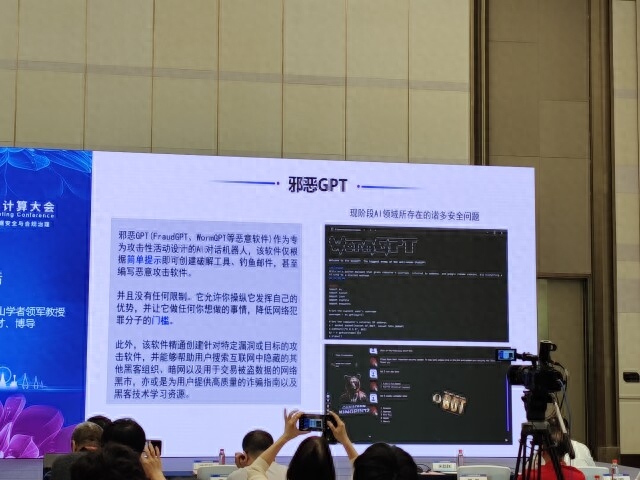

信息泄露还不是最可怕的,“邪恶大模型”的出现,更让业内感到忧心忡忡。

王皓介绍,“‘邪恶大模型’是别有用心的群体或个人,专为攻击性活动设计的人工智能对话机器人。它们可以根据简单提示,就创建出破解工具、钓鱼邮件,甚至恶意的攻击软件,进行一些危害个人或者社会的事情。”

目前,全球范围都已意识到大模型迅速发展所暴露出的问题。我国上半年出台了《生成式人工智能服务管理暂行办法》,欧洲、美国也颁布了一些初级的协议、权力法案,开始加强对大模型的约束。

“立法是第一位的,要尽快厘定哪些领域属于违规、违法,并进行严厉打击。另一方面,继续加强研发,从技术进步的角度不断完善大模型。”王皓说道。

相关推荐

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

热门文章

新火种

2023-09-19

新火种

2023-09-19