焦李成院士:进化优化与深度学习的思考

编辑丨青暮

2021年12月17日,西安电子科技大学人工智能学院教授、欧洲科学院外籍院士、IEEE Fellow焦李成受邀参加2021中国计算机大会“下一代演化计算发展趋势”论坛,并做了“进化优化与深度学习的思考”的主旨报告。

在报告中焦李成梳理了“进化”相关的发展渊源与思想起源,指出了当前人工智能的学术缺陷与实际困境,并从类脑的角度给出了解决路径:

“神经网络不应该是目前的意义上进行权重调参,它的结构应该具备变化性、可塑性、学习性和动态性;在类脑感知的过程中,脑的奖惩、学习、信息表征机制,以及突触的学习记忆、再生长和发育的机制对于信息的重建及编码和处理具有重要的作用。上述特性是现有深度网络所没有重视的。”

以下是报告全文,AI科技评论做了有删改的整理:

今天的演讲主要分为五个部分:发展渊源与思想起源、进化优化与学习、类脑表征学习与优化、进化优化与深度表征学习,以及思考与挑战。

人工智能几十年来得到了长足的发展,而进化优化和类脑启发的深度学习是现在人工智能技术的核心,其关键是:用脑处理知识和自然演化思想发展人工智能技术。这两个思想的发展可以通过历年颁发的科学奖项窥得一二。

例如通过梳理脑科学诺贝尔奖可以明晰“人类如何思考”,回顾图灵奖可以讨论“机器如何进行学习和推理”,了解历年生物相关的诺贝尔奖,可以在“生物如何选择优化”方面给我们启示。那么这些工作对现在的人工智能技术发展有什么启示?

其实,目前学者用人工智能解决实际问题可以分为以下几个步骤:机器学习推导符号=>深度学习=>深度强化学习(感知+决策)=>深度迁移学习(环境适应)=>深度元学习(自动学习)。对于这一步骤路径,徐宗本院士曾经有一段关于机器自动学习的描述:

“机器学习自动化:首先在数据层面上,数据样本需要实现自生成、自选择;其次在模型算法层面上,模型算法需要实现自构建、自设计;最后在环境任务层面上,环境任务要实现自适应、自转换。人工智能的发展轨迹应该是从人工走向自动化,再迈向自主智能。”从这段话也可以看出,这几个步骤环环相扣,一层比一层有难度,那么我们应该如何更加有效的优化这条路径?

进化优化思想起源

进化优化的思想起源很早,达尔文提出的全局优化以及拉马克、班德温提出的局部学习奠基了如今进化算法的学术思想。在进化学习语境下,我们希望无组织机器通过进化、学习、反馈的路径找到通用的机器学习方法。

1948年,图灵在《智能机》报告中也指出从婴儿到成人,人类大脑皮层可以看做从无组织机器进化为通用机器。在这之后,进化优化发展出了四大基本分支:

进化编程:1960年,L.J.Fogel提出将模拟进化作为一个学习过程以生成广泛的人工智能机器,其强调自然进化中群体级行为变化。

进化策略:1964年,德国柏林工业大学的两位学生 L.Rechenberg与H. Schwefel借鉴生物的变异和选择提出了进化策略。

遗传算法:1975年,J.H.Holland借鉴了C.R.Darwin的生物进化论与G.J.Mendels的遗传定律提出了遗传算法。

遗传编程:1980年,S.F.Smith提出了基于遗传自适应算法的学习系统,J.R.Koza撰写了《遗传编程:用自然选择让计算机编程》。

根据进化计算思想,科学家们又设计了它的动力学过程:群体智能,它可以由混沌状态出发,通过价值启发信息探索规律、模式和知识,最终得到解。它的过程是通过动力学的演化过程,以概率1收敛到全局最优解,特点表现为随机、非线性、遍历、自组织性、适应性、多样性、稳定性和高度并行性。

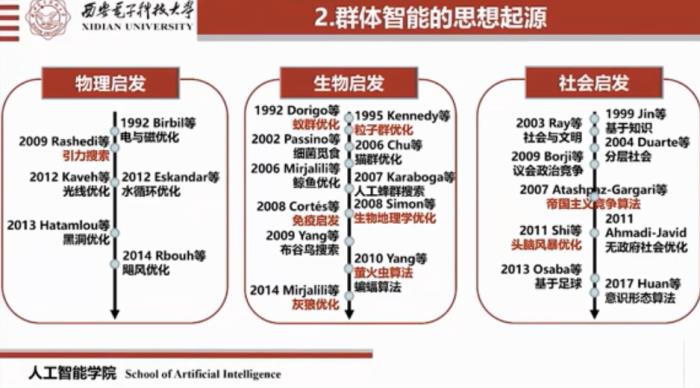

如上图所示,群体智能的思想起源很早,其代表性的方法包括蚁群优化、粒子群优化、免疫算法、萤火虫算法等等。利用进化优化求解复杂问题,主要是利用它的并行性、奇异性、易修改性、高度的非线性以及广泛的应用性等特点,从而匹配NP难问题和组合爆炸问题。

此外,在进化优化算法发展的过程中,自然免疫学理论为人工免疫进化优化提供了坚实的理论基础。从信息负表示算法到免疫进化算法,再到人工免疫的网络、克隆选择算法,以及树突细胞算法,让进化优化算法有了“利用先验知识,具有容错性、免疫性、鲁棒性”等特点,使其和实际问题更加靠近,能够在动态中寻求最优解。

生物免疫同样也证明了这一点,生物诺奖的领域也为发展新的算法提供了坚实的理论基础。“在记忆中学习,在遗忘中加速”使最优解算法更加有效,符合优胜劣汰的根本思想。

人工免疫系统模型的特点是:学习记忆性、多样性、分布性、容错性和被动免疫性。这也为构造高效、鲁棒、容错的算法提供了生物的基础。人工免疫系统方法应用在各个领域,已经有非常好的表现,希望它能够和进化计算、深度学习结合起来,共同推动领域发展。

提及进化,一定离不开类脑的感知和认知,离不开神经网络以及深度学习。2021年诺贝尔医学奖颁给了David Julius和Ardem Patapoutian,当时给出的获奖理由是:

人体对热、冷和触觉的感知能力对我们的生存至关重要,并且支撑着我们与周围世界的互动。他们发现了“温度和触觉的受体”。这给我们带来了“类脑感知与认知研究非常有意义”的启示。从类脑的感知到认知是长时间的过程,而认知科学是一门对心智及其过程进行多学科研究的科学,如果说感知包含视觉、听觉、触觉、味觉等,而认知是教会我们理解、思考、推断、决策,那么如何对心智及其过程进行准确而全面的观察是认知科学的基础,也是巨大的挑战。Tomaso A.Poggio教授认为:人工智能过去的突破来自于神经科学,将来的突破也来自于神经科学。

类脑表征学习与优化

回忆类脑的感知和认知,首先要了解脑的生物机理和基本特性。如上图所示,人脑的六个特性是近20年生物界最新发现:稀疏性、学习性、选择性、方向性、知识性和多样性。

稀疏性:1996年, Olshausen和 Field在《Nature》上发文提出神经元稀编学说;2007年,Svoboda和 Brecht在《Science》上发表论文,用白鼠实验验证了神经元“稀疏编码”假说。

学习性:2011年,美国MIT学者 Tenenbaum与CMU、 Berkeley、 Standford大学等人在《Science》上指出:人类能从少量的数据学到一般化的知识,即具有“抽象知识”的学习能力。

选择性:2011年, Pieter.R等在《Science》发文提出:经实验证明,猴子大脑细胞具有自主控制注意区域的能力;2012年 Xilin Zhang在《Neuron》上发文提出视觉信息加工的初期具有显著注意机制。

方向性:2015年 Arseny Finkelstein在《Nature》上指出生物大脑中存在能感知方向与位置信息的方位角和倾斜角细胞;2020年 Joshua Jacobsi等人在《Neuron》上发表观点提出在人脑内侧额叶中发现了一种以自我为中心空间定位的神经编码模式。这群神经元在空间和情景记忆中发挥重要作用。

而现在的深度学习只建立在巨量神经元的并行上,更热衷于前向的网络,而对于神经元与神经元之间的反馈连接却没有多少研究。因此,对于类脑的感知和认知,无论从宏观层面、介观层面以及微观层面,都需“再出发”,都需要利用上述机理和特性进行分析、模拟、构造模型。

神经网络的发展有很长的历史,上述图片展示了一些卓越贡献者。例如最早生物神经元的提出者、MP神经元模型的提出者、感知机的提出者、连续神经元的提出者以及到后来明斯基提出感知器只能解决线性可分问题而不能解决非线性异或问题。

其他学者在神经网络领域的贡献更加出色和难能可贵,例如Grossberg夫妇奋斗一生提出了自适应共振机理论和三个ART系统。

在中国层面,提出发育神经元模型的吴文俊先生,提出视觉通路中三色传导学说的张香桐先生,模式识别的创始人傅京荪以及提出了忆阻器、Chua电路、细胞神经网络等理论的蔡少棠先生为神经网络的发展做出了巨大贡献。

值得一提的是,郭爱克、陈霖、蒲慕明等学者在生物领域的工作,为建立神经网络提供了良好的基础。

时刻不能忘记前辈的努力,当代华人学者也在接力,他们卓越的学术工作使得中国在国际上更有影响力。

另外,在2021年,深度卷积网络发明者日本学者福岛邦彦获鲍尔奖,表彰他通过发明第一个深度卷积神经网络「 Neocognitron」将神经科学原理应用于工程的开创性研究,这是对人工智能发展的关键贡献。LeCun也曾评价:福岛邦彦教授1980年的卷积网络工作给了他很大的启发,促使了他1989,1998年分别提出CCN和LeNet。

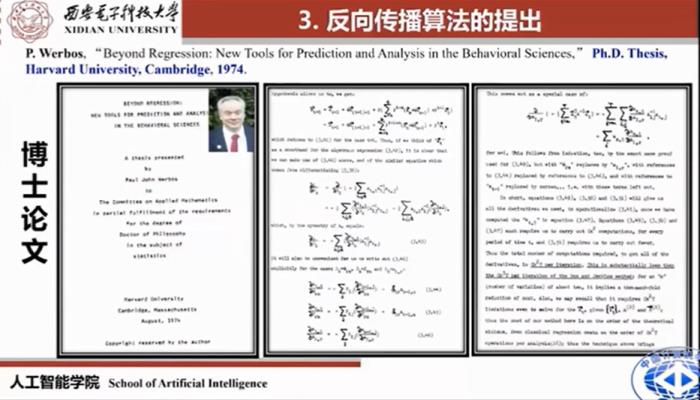

人工智能的发展和深度学习的兴起分不开,从1943年、1944年、1949年到今天,已经经历了几起几落。值得一提的是,BP算法的出现让神经网络可以学习多层网络,从某种意义上回答了明斯基“单层感知器不能解决非线性可分”的问题。

BP算法出现自1974年,P.Werbos在其哈佛大学博士论文中首次给出详细的数学推导。之后众多学者在其基础上进行改进才有了今天神经网络的发展。2021年Francis Crick最新工作指出:大脑实际上不太可能使用反向传播,也就是说BP复制或传递突触权重的信息进行更新,但是在生物网络中,神经元只能接收到其他神经元的输出信息,而不能接收到突触权重或内部过程。这一发现也指出,更具生物学意义的学习机制,或许可以替代反向传播机制,例如反馈比对、预测性编码、锥体神经元、注意力机制等等。

因此,神经网络不应该只是如今意义上的权重调参,更重要的是其结构要具有变化性、可塑性、学习性和动态性,目前这些特性是现在深度网络所没有重视的。

同样,在类脑感知的过程中,奖惩机制、学习机制、信息表征机制、再生长和发育机制等,对于信息的重建、记忆编码和处理具有重要的作用。目前这些特性在深度神经网络中也没有得到重视。

人工智能中的“特征工程”、“特征搜索”、“表征学习”的说法,应该换成“大数据驱动下的表征学习”、“大数据和知识先验驱动下的表征学习”,这样显然更有意义。

在研究认知建模、自动学习以及渐进演化的过程中,应该结合环境的变化、自然的演化以及学习动态变化,能够帮助我们在认知、学习、优化、计算、识别的道路上构造新的模型,构造新的算法,创新新的有潜力的途径。

目前,我们将物理的Wishart极化特性与大脑的稀疏性相结合,提出了一种快速提取目标信息的非线性稀疏变换网络——Wishart Deep Stacking Network(W-DSN),设计了初级快速感知与高级层次感知模块,能够在噪声未知时对目标数据自动抽取高层语义特征,实现自动、高效、精准的分类。

另一个工作是也把物理特征、脑的稀疏特征、多尺度特征与卷积神经网络相结合,提出Contourlet卷积神经网络,解决了稀疏的、方向的、多非变的尺度特征的提取和表征问题。

进化优化与深度表征学习

人脑的进化,包括神经网络的进化,其实是参数的进化、超参数调整,以及结构进化和动力学过程。而进化算法其实是从人工到自动的突围,深度学习与进化相结合或许是让机器学习拥有自动进化能力的一种路径。

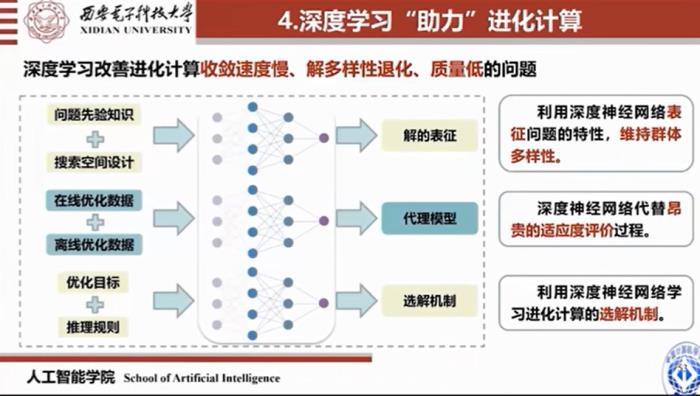

深度与进化结合的研究有两方面的优势。其一,进化解决深度网络结构、权重、参数等优化的科学问题;其二,深度解决进化搜索效率低、复杂度高的科学问题。具体而言,深度学习改善进化计算收敛速度慢、解多样性退化、质量低的问题。

例如,利用深度神经网络表征问题的特性,维持群体多样性;深度神经网络代替昂贵的适应度评价过程;利用深度神经网络学习进化计算的选解机制。

进化计算和深度学习相结合在谋求自动求解非线性、小样本、大数据、高维度、组合爆炸等复杂向题非常有潜力。这方面的代表性工作是“神经结构进化搜索(NAS)”。

神经网络结构的进化研究已经有几十年的历程,如上图所示,已经出现了一些出色的工作。它有如下特点:

无需求导:进化搜索是随机搜索算法,不需要计算梯度和解析的目标函数。

群体特性:进化搜索是基于种群的搜索算法,一次可以获得多个解。

组合爆炸:进化搜索应用范围广,适合大规模复杂问题的优化。

全局最优解:进化搜索是随机搜索方法,且算法以概率1收敛到全局最优解。

非线性随机:进化搜索可以解决非线性问题,寻优规则由概率决定。

并行计算:可以通过大规模并行计算来提高计算速度。

2021年的最新工作中,加拿大渥太华以及麦吉尔大学的研究人员表明:使用突发规则构建的深度神经网络具有良好性能,为进化神经网络架构搜索供了更加坚实的理论基础。换句话说,机器正在进行的学习方式可以通过生理过程来逼近。

神经网络权值优化也经过了多年的发展。80年代提出的权重优化相关工作包含动力学过程;而目前神经网络的进化优化,主要局限于权值的优化和超参的优化。这是组合爆炸问题,使得优化过程收敛速度慢、计算时间长、复杂度高,而难以使用。因此,梯度优化算法容易受到局部最优的影响,而进化算法在存在鞍点的情况下表现非常好。

当前超参数选取大多依靠堆叠GPU,这只能缓解计算量问题,但从机理上而言,需要找到自动学习的方法。超参数优化的问题在于:非线性、非凸、组合优化、混合优化、试错成本高、组合爆炸。经过几十年的发展,这些问题仍然没有解决。

同样有几十年研究底蕴的领域还有元学习,它需解决的基本问题是:元知识的表征、元学习器以及元目标。现在已经有一系列的办法解决可解释性和鲁棒性,但远远不够,因为对泛化性能的提高、对可解释性的追求、对进化全局最优解的追求永远在路上。

总结

因此我们需要通过自然智能(包括类脑智能学习和优化)来达成这些目标。在进化的路上,我们需要做到“耳聪目明”,例如表征的紧促、正交、准确,学习的明确,解释的清楚。以雷达研究为例,从最早的看得见,到测得准,再到观得清,最后到辨得明,这恰恰印证了人工智能(包括进化计算和深度学习)的发展特点。

ABC,也就是人工智能(AI)、生物智能(BI)、计算智能(CI)有无限光明。希望我们共同牢记初心、不负使命、砥砺前行,认认真真、扎扎实实做学问。

推荐阅读

2021-12-12

2021-12-25

2021-12-29

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

热门文章

新火种

2023-10-30

新火种

2023-10-30