“超级有用”的AI,被百度做成了

大模型,怎么才叫成了?

11月12日的2024百度世界大会上,李彦宏抛出这样一个问题。

“没有应用,基础模型不值一提”,是李彦宏一贯的观点。在他看来,应用落地是衡量大模型的最佳标准,当一个大模型的API日均调用量达到20亿,就可以说它成了。

而今年9月以来,百度文心大模型的日均API调用量出现爆发式增长,已达到15亿水平,短短半年增长7.5倍。

如此看来,百度大模型真的快成了。

百度在AI大模型落地应用上的领先地位,也得到第三方数据支持。

IDC报告显示,2024年上半年,百度智能云以32.4%的市场份额,位居中国MaaS市场第一。与此同时,2024年上半年中国AI大模型解决方案市场,百度智能云营收占比达17.0%,位居市场第一。

谈到大模型,外界往往有种误解,认为基础大模型、GPU硬件的研发才是硬科技,做应用只是跟随;但深入到技术层面就会发现,想要实现大模型的落地应用,挑战并不比大模型本身更小。

“快成了”的百度大模型,做对了什么?

“大模型已基本解决幻觉问题”

当两年前ChatGPT-3横空出世,尽管其能力已经足够让人惊艳,但“一本正经地胡说八道”仍然时有出现。

这种现象被称为“幻觉”,如果不能把“幻觉”概率降到足够低,大模型就无法真正从一个好用的工具变成真正的智能伙伴。

为了解决幻觉问题,百度凭借搜索引擎的技术积累,较早引入了检索增强机制。即通过搜索互联网上已有的人类知识,来帮助大模型给出更准确的回答。

如今,检索增强在文本生成领域的应用已经较为成熟,而百度又将精力投向了文生图。

从下图可以看出,普通AI大模型生成的物体(左侧)相比于现实物体(右侧),往往还会存在明显幻觉,将天坛的三层结构变成了四层。

为此,百度开发了检索增强的文生图技术iRAG(image based RAG),将百度搜索的亿级图片资源跟强大的基础模型能力相结合,可以生成各种超真实的图片,“整体效果远远超过文生图原生系统,去除了机器味儿”。

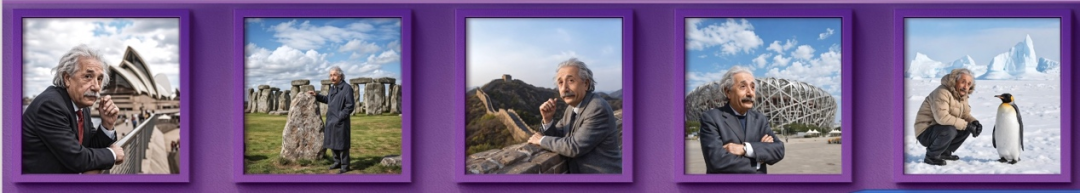

李彦宏现场展示了一幅由文心大模型生成的大众揽巡汽车飞跃长城的图片。通过文心iRAG技术,无论是这款特定型号汽车的车型车标、还是作为背景的长城,均未出现错误或变形的幻觉问题。同时展示的“爱因斯坦环游世界”图片中,爱因斯坦和各个背景景点的结合也与真实世界高度相似,质感接近照片。

李彦宏指出:“过去24个月,AI行业的最大变化是什么?是大模型基本消除了幻觉。”

解决幻觉问题以后,AI大模型终于可以快速走向智能体,迎接AI原生应用的大爆发。

例如百度文库和百度网盘联合打造的工具类智能体“自由画布”,让用户可以在一块类似“画布”的界面上自由拖拽文档、音视频等富媒体素材,迅速生成多模态内容。

更让人惊艳的,是李彦宏提前剧透的无代码编程工具“秒哒”,由大模型直接生成代码,不需要人写一行代码。

“一个人通过自然语言交互,就可以完成一套系统的搭建,”李彦宏指出,这意味着每个人自己就能指挥多个智能体来协同完成任务,“只要有想法,你就可以心想事成,我们将迎来一个前所未有的,只靠想法就能赚钱的时代。”

AI算力的另一场硬实力竞争

AI幻觉的大幅降低,不仅让百度自身的AI应用快速进化,也能够让更多行业放心用上大模型。不过对于行业落地而言,便宜好用的算力同AI能力本身一样重要。

因此在谈应用之前,我们不妨先谈谈基础设施。

得算力者得天下,是大模型时代的共识。

这样的共识让GPU企业一飞冲天,也让单卡算力成为市场追逐的热点。不过人们往往忽视了,整个算力集群的实际性能,并不简单等于单卡算力之和。

如果说CPU 是一个很复杂的大脑,GPU就是数量巨大的机械臂组合。GPU内的每一个计算核心所做的工作都很简单,但真正的难度在于如何同时指挥这么多“机械臂”。

正如战场上需要及时把指令传达给每一个士兵,GPU核心之间的通信效率才是发挥性能的关键。

单个GPU内的通信已经会延缓计算速度,而在万卡集群之中,GPU之间的通信效率还会有数量级的下降,如果说机内通信带宽是50的话,机间可能就只有2或3。

显卡加速一直都是GPU应用中不容忽视的部分,如果做不好加速,万卡集群的利用率甚至可能低至10%,90%的算力都被白白浪费。

英伟达70%的人力都用于软件开发,人们说,英伟达真正的壁垒是基于 CUDA的庞大加速库。

因此,除了单卡算力之外,集群效率也是中美之间围绕算力的另一场硬实力竞争。

在这场竞争中,百度已经用百舸4.0平台给出了万卡规模上的优异答卷。

百度集团执行副总裁沈抖在不久前的云智大会上曾表示,百舸4.0预置了主流的大模型训练工具,能够实现工具层面的秒级部署,并将万卡集群运行准备时间从几周缩减至1小时,极大地提升部署效率,缩短业务上线周期。

稳定性方面,百舸4.0有效训练时长占比99.5%以上,业界领先,极大地节约了客户算力与时间成本。此外,通过在集群设计、任务调度、并行策略、显存优化等一系列创新,百舸4.0大幅提升了集群的模型训练效率,整体性能相比业界平均水平提升高达30%。

而在美国的算力限制下,中国算力平台还不得不面临一个特殊难题——需要使用不同规格的显卡搭建异构集群,进行多芯混训

为此,百舸将不同地点、不同规模的异构算力进行统一管理,构建起多芯资源池。当业务提交工作负载时,可自动进行芯片选型,依据集群剩余的芯片资源,选择性价比最高的芯片来运行任务,从而最大化地利用集群的剩余资源。最终,可实现高达95%的万卡多芯混合训练效能。

做好国产大模型的基础设施

凭借高效的百舸AI异构算力平台,百度不仅持续升级自己的文心大模型,也在为更多中国AI企业提供服务。

教育无疑是AI应用最有意义的领域,但是对AI的准确率也提出了更高要求,这就需要深耕教育领域的企业基于垂直数据来训练模型。

对于好未来这样的企业来说,自己去购买显卡搭建算力集群的投入是难以承受的,而百度百舸为好未来自研“九章大模型(MathGPT)”早期高效低成本“跑起来”提供了关键支撑作用。

基于百度百舸平台,好未来可以快速、方便的创建出千卡级别的训推任务集群。算力方面,集群最大可支撑 16000 GPU卡的规模;存储方面,适用于大规模深度学习训练场景,可提供亚毫秒级(300us)的时延,支持百万级 IOPS,服务可用性不低于99.95%。

百舸还提供了强大的加速能力,LLaMA2系列、GLM系列等多尺寸模型都实现了训练指标的最佳实践,千卡任务加速比保持在90%,训练吞吐与大模型训练理论值相当。

百度自身利用百舸训练文心大模型的成熟经验,也能够帮助其它大模型企业快速训练。

成立于2023年3月的生数科技,仅仅一年后就发布了被称为“国产Sora”的视频生成大模型Vidu。

在影响用户体验的推理速度层面,Vidu实现了业界最快的实测推理速度,生成一段4秒片段只需30秒。而市面上的主流 AI视频工具在生成4秒左右的视频片段时,用户通常需要等待1到5分钟,甚至更长。

传统行业的生产力飞升

在大模型落地层面,直接由大模型催生的AI原生应用看上去酷炫,但是不要忽视了,AI对千行百业传统生产流程的改造可能会创造更大价值。

李彦宏曾举例说,“Microsoft 365 Copilot 一年营收 50 亿美元,比 OpenAI 全年的收入都大很多倍。仅就对现有产品的改造而言,就已经创造出来这么多新的价值。”

因此在李彦宏看来,“百度不是要推出一个‘超级应用’,而是要不断地帮助更多人、更多企业打造出数百万‘超级有用’的应用。”

在中国,典型的AI应用场景是智能客服,但是传统的智能客服普遍需要人工提前准备好现成的FAQ,对用户问题的理解能力也非常有限。而在大模型的加持下,智能客服对自然语言的理解能力出现了质的飞跃,无论是应用范围还是部署成本都明显改善,是大模型对于现有产品改造的绝佳案例。

百胜中国是国内最大的餐饮公司,其基于文心大模型打造的AI智能客服系统,已经在为旗下包括肯德基在内的多个品牌提供服务。

目前,AI客服每天能够为百胜中国处理超过15万次客服沟通任务,问题解决率高达90%;辅助人工客服快速总结沟通历史,整理归纳诉求,提供建议回复话术、一键发送等功能,提升客服员工产能效率10%。

杭州全诊医学基于千帆平台和文心大模型打造了AI医疗助理应用,则能够在导诊、预诊、诊间、入院、手术、随访等全阶段服务医生患者。以辅助医生撰写病历为例,全诊医学通过使用20万份精标病历数据对大模型进行了精调,使AI医疗助理的医学用语更准确、更规范,大幅提升病历内容质量。病历生成的准确度提升了45%,医生的接诊量提高了20%,造福更多病患。

大模型的应用不仅限于自然语言理解,也能够深入改造传统企业的生产环节。

在能源电力行业,国家电网正在围绕文心大模型、千帆平台,结合电力行业高质量数据,联合百度共创电力行业大模型基础底座,并在调度、设备、营销等六大专业领域深入探索。目前,已经在电力设备运检、供电服务等电力行业核心场景成功完成应用落地。

得益于在全栈AI技术、产品创新和产业落地方面的持续投入,百度智能云拥有中国最广最深的大模型产业落地规模,超60%的央企正在使用百度智能云进行AI创新。百度智能云千帆大模型平台已经帮助客户精调了3.3万个模型、开发了77万个企业应用、文心大模型日均调用量超过15亿次。

这就是李彦宏说出“应用来了”的底气:“我是软件工程师出身,国外有一种说法叫‘软件吞噬世界’。但我认为,这个世界不应该被吞噬,而应该被创造。AI时代,应用创造世界。所以请大家和我一起见证,AI applications creating the world。”

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

热门文章

新火种

2024-11-21

新火种

2024-11-21