微软:从“软件老大”到“AI帝国”

从2009开始开发AI模型,到2019年投资OpenAI,微软正在一步一步成为AI时代的庞然大物。

对于微软及其生态系统而言,今年的Ignite技术大会堪称异彩纷呈。微软一口气公布了100多项以 AI 为中心,在云计算基础设施、 模型即服务 MaaS 、数据平台、Copilot 人工智能助手等方方面面的新产品和新功能,展示了一个端到端的AI全面愿景。

但有一个细节应当被注意:在微软的传统上,Ignite大会主要聚焦于基础设施和运营,而Build大会则主要针对开发者。

而本次的Ignite大会,针对开发者和机器学习工程师的人工智能内容占据了中心位置。

这意味着,这场大会不仅仅关乎开发者和IT专业人士,更像是整个微软生态系统的一个划时代时刻。

在主题演讲中,微软首席执行官Satya Nadella明确表示,微软渴望成为AI生态系统的重要力量。从开发自己的人工智能加速芯片到推出Copilot市场,微软已经制定了人工智能的长期战略。

总体而言,微软在Ignite 2023上的战略明确表明,其重点是引领人工智能革命,利用其平台传统,在硬件和软件方面进行创新,以保持行业的主导地位。

Azure→新AI操作系统 Copilot→新应用微软正试图复制在软件操作系统时代的荣光。

在构建系统平台方面,微软确实有着丰富的经验:从最早的Windows平台、OLE和COM的开发,到2000年代初的Microsoft. NET和Visual Studio推动了Web服务的开发,再到上个十年成功推出的Azure平台。

现在,微软希望通过人工智能再次重现这种奇迹,创造一个集合了开发者、独立软件供应商(ISV)、系统集成商、企业和消费者的繁荣生态系统。

而这一次,Azure成为新的操作系统,就像新的Windows,提供运行时和平台服务,而Copilots成为微软称之为AI助手的新应用程序。GPT-4等基础模型构成了这个新操作系统的内核。

与Visual Studio类似,微软也以AI Studio和Copilot Studio的形式投资了一套开发者工具。这种堆栈与Windows、.NET和Visual Studio非常相似,后者曾统治开发者领域长达数十年之久。

短短几个月内,微软已经交付了多个嵌入人工智能的产品,从New Bing到Microsoft 365,再到Window操作系统。

微软拥抱生成式人工智能的速度令人震惊,这种做法也表明了一种紧迫感:这家公司正在致力于成为人工智能的先驱,使AI的能力更贴近客户。

Satya Nadella可能不想再让微软错过技术领域的下一个风口,就像微软当年错过了搜索和移动领域一样。

自研CPU、GPU和DPU在过去,CPU制定了软件架构的规则并影响其发展,现在GPU也在影响着人工智能的发展,而微软想要直接把握这一关键环节。

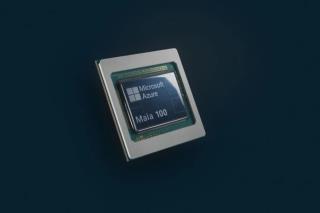

本次Ignite大会上,微软就发布了首款定制CPU Azure Cobalt 和AI加速芯片 Azure Maia。

Microsoft Azure Cobalt 是一款基于 Arm 架构的云原生芯片,针对通用工作负载的性能、功率和成本效益进行了优化。纳德拉称,这款 CPU 芯片已经在支持 Microsoft Teams Azure 通信服务以及 Azure SQL 的部分中使用;明年也将向客户提供这款产品。

Microsoft Azure Maia 是一款 AI 加速芯片,用于 OpenAI 模型、Bing、GitHub Copilot 和 ChatGPT 等 AI 工作负载运行云端训练和推理。这款芯片采用了 5 纳米工艺制造,拥有 1050 亿个晶体管。

Azure Maia 100 美颜照|Microsoft

Azure Maia 100 美颜照|Microsoft

微软自己的DPU——Azure Boost也已全面上市。微软在今年早些时候收购了 DPU 公司 Fungible,以提高 Azure 数据中心的效率。通过 Azure Boost,虚拟化、网络管理、存储管理和安全等软件功能被卸载到专用硬件上,使 CPU 可以将更多的周期用于工作负载而不是系统管理。由于繁重的工作被转移到专用处理器上,这种卸载大大提高了云基础设施的性能。

纳德拉称,“硅多样性(sillicon diversity)是我们能够支持世界上最强大的基础模型和所有 AI 工作负载的关键因素”,在本次 Ignite 技术大会上,微软不仅发布了两款自研芯片,也纳入了更多行业合作伙伴的最新 AI 优化芯片,包括 AMD Instinct MI300X,以及英伟达 H100 和 H200。

在上述超级计算机之上,微软还提供参数量从数十亿到数万亿不等的基础模型,来满足不同开发者构建AI应用程序时的成本、延迟和性能需求。

自研和开源基础模型虽然目前Azure依然是企业使用OpenAI模型的首选平台,但微软也在投资建设自己的大模型。

此前曾介绍,微软正在开发自有的“小模型”。

与传统的大型语言模型相比,微软Phi-1.5 和 Phi-2 是轻量级的小型语言模型,需要的资源更少。Phi-1.5有13亿个参数,Phi-2有27亿个参数,与 Llama 2(起始参数为 70 亿个,最高可达 700 亿个参数)相比小得多。

因此,这些小模型非常适合嵌入到Windows中,以提供本地Copilot体验,而无需往返云端。微软还发布了Visual Studio Code的扩展,允许开发人员在云中微调这些模型,并将其部署到本地进行离线推理。

此外,微软研究院还开发了Florence模型,允许用户分析和理解图像、视频和语言;微软的模型平台Azure ML现在还支持包括Llama、Code Llama、Mistral 7B、Stable Diffusion、Whisper V3、BLIP、CLIP、Flacon 和 NVIDIA Nemotron在内的其他开源基础模型,为客户提供了最全面、最广泛的基础模型选择。

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

热门文章

周晓雯

2023-11-23

周晓雯

2023-11-23