玩转围棋、国际象棋、扑克,DeepMind推出通用学习算法SoG

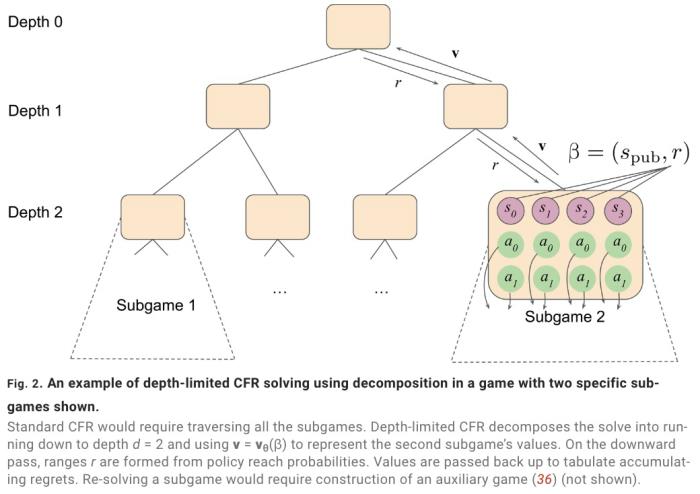

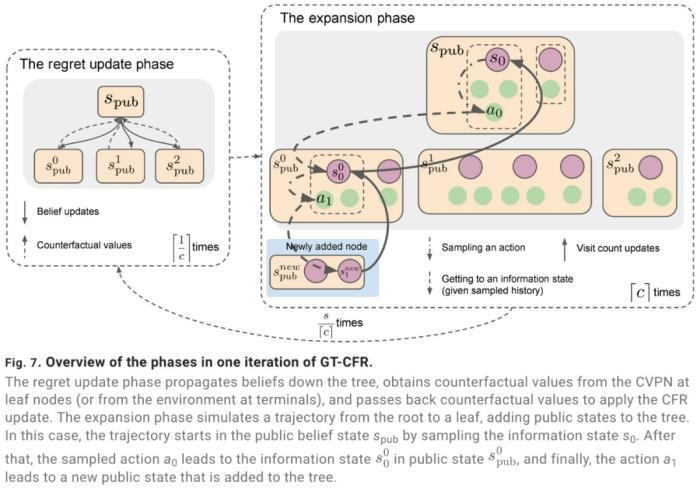

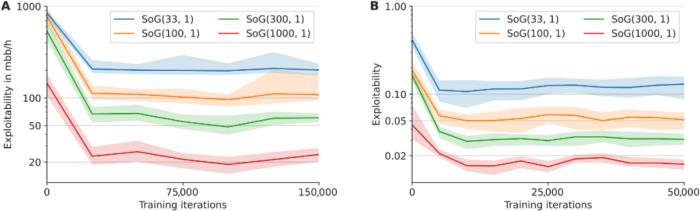

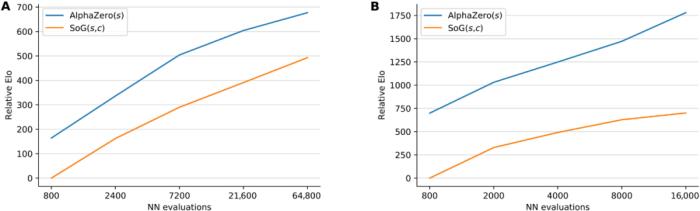

2016 年 3 月,一场机器人与围棋世界冠军、职业九段棋手李世石展开的围棋人机大战受到全球的高度关注。我们知道,最后的结果是 DeepMind 的机器人 AlphaGo 以 4 比 1 的总比分获胜。这是人工智能领域一个里程碑性的事件,也让「博弈」成为一个热门的 AI 研究方向。AlphaGo 之后,DeepMind 又推出了赢得国际象棋的 AlphaZero、击败《星际争霸 II》的 AlphaStar 等等。使用搜索和学习的方法,AI 在许多完美信息博弈中表现出强大的性能,而使用博弈论推理和学习的方法在特定的不完美信息博弈中表现出强大的性能。然而,大多数成功案例有一个重要的共同点:专注于单一博弈项目。例如,AlphaGo 不会下国际象棋,而 AlphaZero 虽然掌握了三种不同的完美信息博弈,但 AlphaZero 无法玩扑克牌,也不清楚能否扩展到不完美信息博弈。此外,现有研究往往会使用特定领域的知识和结构使 AI 实现强大的性能。现在,来自 Google Deepmind 的研究团队提出了一种利用自我博弈学习、搜索和博弈论推理实现强大博弈性能的通用学习算法 ——Student of Games(SoG)。研究论文发表在《Science Advances》上。

相关推荐

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

热门文章

新火种

2023-11-22

新火种

2023-11-22